Capítulo I

Psicobiología

Mercè Boixadós i Anglès

Ana Moreno Alcázar

Mariona Portell Vidal

Diego Redolar Ripoll

Noemí Robles Muñoz

Jaume Vives Brosa

1.Introducción al estudio del cerebro y de la mente

Hoy en día, sabemos que el sistema nervioso controla y regula la mayoría de actividades del organismo. La información de nuestro entorno es captada por diferentes tipos de receptores sensoriales distribuidos ordenadamente por nuestro cuerpo. Éstos recogen y envían la información para que sea procesada e integrada por nuestro sistema nervioso central. De igual forma, constantemente se están poniendo en marcha los complejos planes motores que se desarrollan en nuestro cerebro y que, finalmente, conllevan a la coordinación de diversos grupos musculares para permitir un determinado movimiento. El cerebro recibe, integra, procesa la información y envía diferentes señales para regular múltiples funciones en el organismo, desde la puesta en marcha de la propia conducta hasta la regulación de distintos mecanismos homeostáticos y de los sistemas endocrino e inmunológico. El sistema nervioso no sólo establece un puente de unión entre la información proveniente del medio y la respuesta que el organismo realiza para adecuarse a las demandas cambiantes del entorno, sino que nos convierte en lo que somos, subyace a nuestras emociones, a la resolución de problemas, a la inteligencia, al pensamiento, a capacidades tan humanas como el lenguaje, la atención o los mecanismos de aprendizaje y memoria.

Es necesario partir de un concepto clave que tendremos que tener presente a lo largo de los próximos apartados, y es que nuestro sistema nervioso se debe concebir como un todo con diferentes niveles de complejidad y, por tanto, con diferentes niveles de estudio y de aproximación experimental.

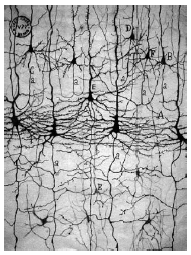

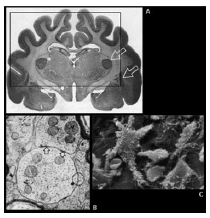

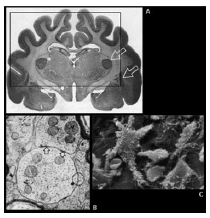

La unidad estructural y funcional del sistema nervioso queda fundamentalmente constituida por las neuronas y las células gliales. Se calcula que existe alrededor de 100 billones de neuronas en el sistema nervioso humano, y unas 10 veces más de células gliales. En cada una de las células, podemos distinguir diferentes componentes u orgánulos, y dentro de éstos, podemos llevar a cabo un análisis molecular y estudiar canales, receptores, e incluso el ADN neuronal. Por tanto, en un extremo tendríamos el nivel celular y molecular, y en el otro extremo de la escala tendríamos la anatomía en el nivel macroscópico, donde es posible establecer diferentes divisiones sin necesidad de recurrir a los aumentos del microscopio.

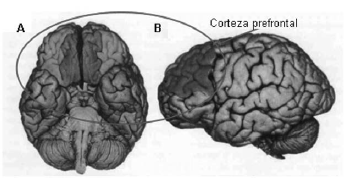

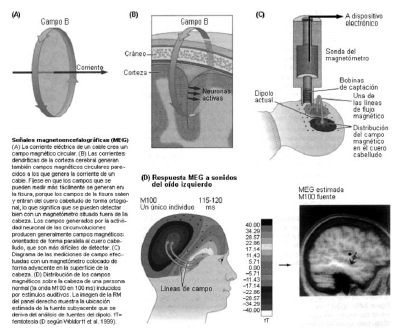

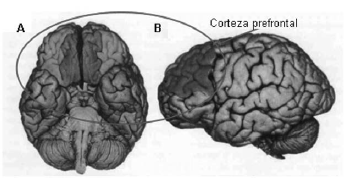

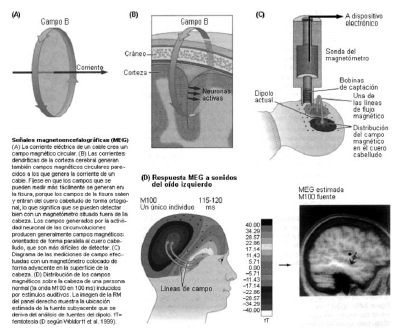

Figura 1. Diferentes niveles de estudio del cerebro humano. Cuando se analiza la anatomía cerebral, se puede abordar su estudio desde un punto de vista macroscópico o bien a través de los diferentes componentes que lo integran: las células nerviosas, partes de éstas, las sinapsis, la estructura interna de la célula, las moléculas presentes en la membrana o en el citoplasma o incluso los genes que se expresan en el tejido nervioso. (Adaptada de Rosenzweig y col., 2001).

Partiendo de la organización de nuestro sistema nervioso en diferentes niveles de complejidad estructural, es necesario atender en primer lugar a los principales elementos celulares, fisiológicos y moleculares como punto de partida para poder comprender otros niveles de organización más global, como la conformación del cerebro por núcleos, capas y vías de proyección, la estructuración de los diferentes sistemas neurales y la descripción macroscópica cerebral.

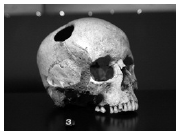

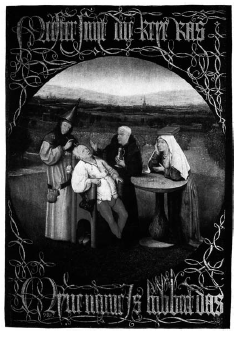

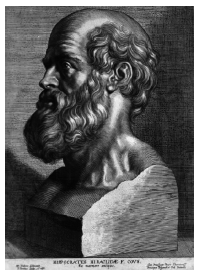

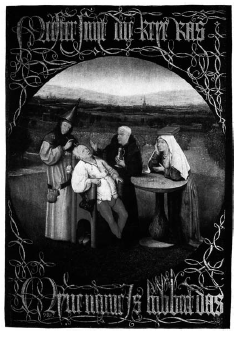

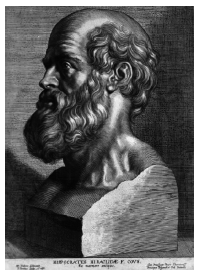

Los hombres deben saber que el cerebro es el responsable exclusivo de las alegrías, los placeres, la risa y la diversión, y de la pena, la aflicción, el desaliento y las lamentaciones. Y gracias al cerebro, de manera especial, adquirimos sabiduría y conocimientos, y vemos, oímos y sabemos lo que es repugnante y lo que es bello, lo que es malo y lo que es bueno, lo que es dulce y lo que es insípido […]. Y gracias a este órgano nos volvemos locos y deliramos, y los miedos y terrores nos asaltan […]. Debemos soportar todo esto cuando el cerebro no está sano […]. Y en este sentido soy de la opinión de que esta víscera ejerce en el ser humano el mayor poder.

Hipócrates. Sobre las enfermedades sagradas (siglo IV a. C.).

2.¿Qué es la psicobiología?

La psicobiología es la disciplina cuyo objeto de estudio es la conducta y la cognición, pero atendiendo a las bases biológicas subyacentes.

El origen de la psicobiología se circunscribe, fundamentalmente, a la década de 1950; no obstante, el estudio del sistema nervioso y de cómo éste puede explicar el comportamiento es mucho más antiguo. La publicación del libro de D. O. Hebb The Organization of Behavior (La organización de la conducta) en 1949, marcó una inflexión en la demarcación de la psicobiología como disciplina científica dentro de la neurociencia. En dicha obra, Hebb postuló un modelo sobre el funcionamiento del sistema nervioso en relación a la producción y regulación de la conducta y la cognición. En el modelo presentado por Hebb, se intentaba explicar cómo la actividad neural podría contribuir a la génesis de procesos cognitivos como el aprendizaje y la memoria, la atención, las emociones, el pensamiento complejo, etc.

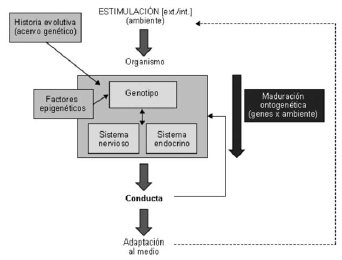

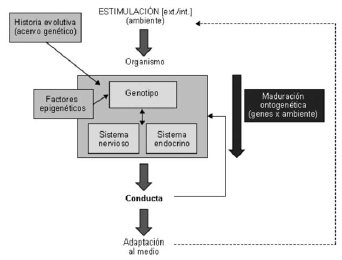

Utilizando el método científico, por un lado, la psicobiología tiene como objeto de estudio la conducta, en tanto que ésta se aborda como un proceso biológico. En base a esto, desde la psicobiología interesa analizar los diferentes componentes del sistema neuroendocrino implicados, los factores genéticos y epigenéticos subyacentes, los procesos que ponen en marcha la conducta y aquellos que la controlan; incluso interesa conocer el conjunto de adaptaciones acaecidas a lo largo de la historia evolutiva que son recogidas en el acervo genético y que la modelarían.

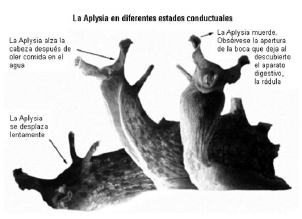

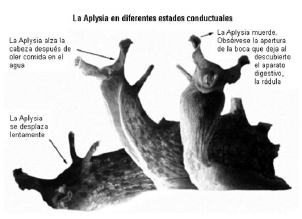

En tanto que la conducta depende de la historia evolutiva del ser humano, el análisis de las bases biológicas de ésta en diferentes modelos animales puede proporcionar información elemental para la explicación de la conducta humana en términos biológicos. No es de extrañar, por tanto, que una buena parte de la investigación en psicobiología utilice diferentes modelos animales basándose en el establecimiento de esa correspondencia filogenética (tal como se verá en apartados posteriores).

Figura 2. La conducta humana es fruto de la evolución, con lo que la historia evolutiva desempeña un papel primordial para entender las variaciones acaecidas en el comportamiento a lo largo de la filogenia, gracias a la relación evolutiva del ser humano con otras especies. Por lo tanto, podemos destacar que el acervo genético del hombre abarca los éxitos adaptativos de sus antecesores. Asimismo, la estimulación del medio externo y del medio interno del propio organismo, elicita una respuesta en éste, cuya finalidad última es su adaptación al entorno cambiante. Entre el estímulo y la respuesta se posiciona el organismo, entendido en términos biológicos. De esta forma, la conducta permite al organismo relacionarse de forma activa con el medio. En definitiva, laconducta deriva de la actividad integrada del sistema nervioso y del sistema endocrino, mientras que los genes y todos los factores epigenéticos regulan la forma en que se organizan y responden dichos sistemas.

En definitiva, la psicobiología utiliza la metodología científica y tiene un objeto de estudio propio. Éste, por un lado, queda circunscrito a la conducta, aludiendo a las bases biológicas de ésta. Dentro del ámbito de estudio de la psicobiología, hemos de tener presente que la conducta ha de explicarse como un fenómeno contrastable, de tal forma que se puedan buscar evidencias empíricas que rechacen o acepten las hipótesis formuladas en el estudio de algunos de los aspectos relacionados con ésta. De este modo, la conducta necesariamente ha de abarcarse como una actividad observable emplazada entre unos medios determinados y un resultado o finalidad.

La psicobiología, por tanto, estudia las bases biológicas relacionando los resultados con el comportamiento. Del Abril y colaboradores (2001) definen acertadamente la conducta en términos psicobiológicos como “el conjunto de manifestaciones públicamente observables regula das por el sistema neuroendocrino, mediante las cuales el animal como un todo, en respuesta a un estímulo interno o externo, se relaciona activa y adaptativamente con el medio ambiente”. De esta definición podemos colegir que la cognición y los procesos mentales también serían susceptibles de ser abarcados por la psicobiología como objeto de estudio.

En tanto que la cognición deriva de la actividad neural, la psicobiología ha de ser capaz de estudiar los sistemas neurales cuya actividad resulta en diferentes procesos cognitivos (aprendizaje y memoria, atención, emociones, funciones ejecutivas, etc.). De forma añadida, es necesario tener presente que los procesos generados por la actividad de estos sistemas neurales son capaces de regular la propia conducta.

En definitiva, la psicobiología pretende estudiar el comportamiento observable y los procesos cognitivos como un conjunto de las fases sucesivas de un fenómeno biológico.

2.1.La psicobiología en relación a la neurociencia y la neurociencia cognitiva

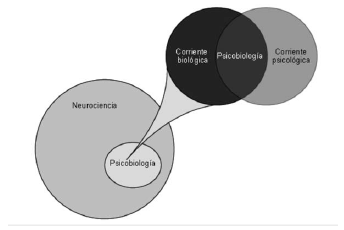

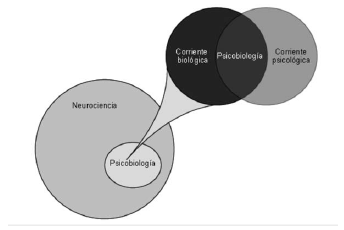

Hemos de tener presente que la psicobiología se sitúa en el contexto de la neurociencia, disciplina que estudia el sistema nervioso, ubicada entre dos corrientes de obtención del conocimiento: la corriente psicológica y la corriente biológica.

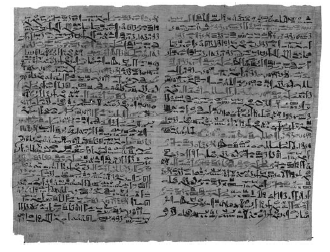

El término neurociencia es joven. La Society for Neuroscience, asociación de neurocientíficos profesionales, fue fundada hace relativamente poco, concretamente en 1970. No obstante, el estudio del cerebro es tan antiguo como la propia ciencia. Históricamente, los científicos dedicados a comprender el sistema nervioso procedían de disciplinas científicas diferentes, como la medicina, la biología o la psicología. La revolución de la neurociencia se inició cuando estos científicos se dieron cuenta de que la mejor esperanza para discernir el funcionamiento del cerebro necesitaba un posicionamiento multidisciplinar, requiriendo conocimientos sobre infinidad de hechos, desde la estructura de una molécula de acetilcolina hasta la razón por la que el perro de Pavlov segregaba saliva cuando sonaba la campana. Por tanto, la unidad de estudio de la neurociencia, como disciplina, requiere de diferentes niveles de análisis, siendo, en un orden de complejidad ascendente: molecular, celular, sistémico, conductual y cognitivo. La psicobiología, en relación con la neurociencia, también intenta englobar diferentes niveles de análisis, pero siempre poniendo el énfasis en el estudio del papel del sistema nervioso, en interacción con el resto del cuerpo, sobre el control del comportamiento.

Figura 3. La psicobiología se ubica en el marco de referencia de la neurociencia y nace entre dos corrientes científicas de obtención del conocimiento: la psicológica y la biológica. No obstante, la psicobiología tiene un objeto de estudio propio y esto es lo que la desmarca de una mera intersección entre estas dos corrientes.

Asimilar los contenidos de la neurociencia posiciona a la psicobiología en un emplazamiento que le debería permitir contextualizar, entender y reflexionar sobre los diferentes mecanismos y sistemas de funcionamiento del sistema nervioso y endocrino, conociendo los diferentes métodos y estrategias utilizadas para el estudio de estas funciones, así como relacionar e integrar toda esta información funcional con sus bases fisiológicas, celulares, bioquímicas y anatómicas en relación con la producción y regulación de la conducta y la cognición.

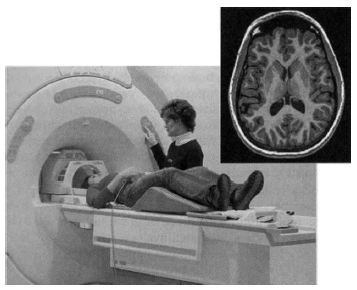

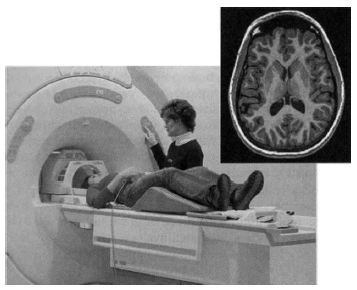

La neurociencia cognitiva, por su parte, es un campo científico de surgimiento relativamente reciente entre dos disciplinas: la neurociencia y la psicología cognitiva. En tanto que la psicología cognitiva tiene como objeto de estudio las funciones cerebrales superiores y todas las conductas asociadas, y la neurociencia su objeto de estudio es el sistema nervioso a diferentes niveles de análisis (molecular, celular, fisiológico, etc.), la neurociencia cognitiva nace en la convergencia de estas dos disciplinas. Parte de la investigación llevada a cabo dentro del marco de la psicobiología (sobre todo la realizada con técnicas de neuroimagen), viene determinada por los principales propuestos y premisas de la neurociencia cognitiva.

3.El método científico en psicobiología

Hemos de partir del hecho irrefutable de que en el mundo existen diferentes tipos de conocimientos. El sentido común del ser humano, la magia, la religión, la filosofía etc., han proporcionado a nuestra raza diferentes fuentes de conocimiento. La ciencia ha intentado acumular y ampliar el conocimiento siguiendo un conjunto de reglas y procedimientos. Por su parte, la tecnología ha intentado aplicar dicho conocimiento a la generación de instrumentos útiles para el hombre.

El conocimiento científico en psicobiología se genera al acumular datos adquiridos mediante contrastaciones empíricas con el objetivo de obtener leyes de máxima generabilidad. El modo utilizado para llevar a cabo dicho acopio de datos es el método científico. Por ello, la caracterización del conocimiento científico puede centrarse tanto en la confección de teorías de gran calidad como en la acumulación de datos mediante la implementación de diferentes procedimientos que permitan las contrastaciones empíricas.

“Investigar es lanzar una red al mar de la intuición y esperar que la razón te guíe entre éxitos y fracasos”.

Arvid Carlsson, premio Nobel de Fisiología o Medicina del año 2000, por sus investigaciones sobre la dopamina.

El método científico parte de una premisa esencial que constituye uno de sus rasgos cardinales: la replicabilidad. En base a ésta, se pretende generar consenso dentro de la propia comunidad científica. La replicabilidad de los procedimientos, por tanto, es la característica del modo de generar el conocimiento que posibilita que cada nueva contribución pueda ser, periódicamente, contrastada por diferentes grupos de investigación.

Cuando estamos delante de un determinado experimento, nos podemos cuestionar si la investigación que hemos llevado a cabo nos proporciona las garantías suficientes de su fiabilidad. ¿Qué es la fiabilidad de una investigación? Se trata de la facultad determinada por la persistencia, a lo largo del tiempo o a lo largo de diferentes evaluaciones simultáneas, de los resultados obtenidos. Se trata, por tanto, del grado en el que se estima que, al replicar una investigación, obtendremos los mismos resultados. A mayor cantidad de medidas de control implementadas en un experimento, mayor probabilidad de que éste sea fiable.

La fiabilidad no sólo la podemos circunscribir a una investigación determinada, sino también a las medidas y evaluaciones realizadas en un mismo experimento. Cuando se llevan a cabo varias medidas, en momentos temporales diferentes o por evaluadores diferentes, y se analiza el grado de consistencia de dichas medidas, hablamos de fiabilidad temporal y de fiabilidad interjueces, respectivamente.

En el marco de la investigación en psicobiología, cuando se habla de sensibilidad de un experimento nos estamos refiriendo a la condición de la operativización de las variables, de los procedimientos utilizados y del aparataje e instrumentación implementada en el diseño experimental, para reconocer los efectos de la manipulación realizada. En el momento en que un experimento no permite detectar el efecto de los cambios en los niveles de la variables independiente, señalamos que no asume sensibilidad.

En definitiva, la psicobiología tiene un objeto de estudio propio y utiliza el mismo método que el resto de disciplinas neurocientíficas1. Por tanto, se persigue la contrastación empírica, en tanto que se formulan hipótesis para buscar evidencias empíricas que las confirmen o las refuten. De igual forma, uno de los rasgos cardinales de la investigación en psicobiología es la búsqueda de la replicabilidad.

3.1.Obtención del conocimiento

Durante el proceso de obtención del conocimiento, es posible utilizar diferentes estrategias y procedimientos. Lo que queda claro es que el eje vertebral de la obtención del conocimiento se ha de centrar en la replicabilidad.

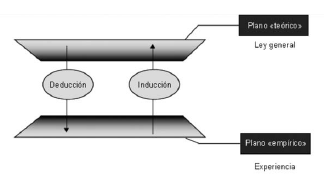

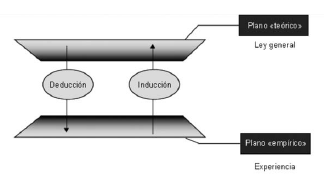

La metodología inductiva se basa en la obtención del conocimiento mediante sucesivas observaciones para establecer una ley de ámbito lo más global posible mediante el uso de la generalización. Por tanto, este tipo de metodología se centra en la generalización de una observación del mundo real para llegar a elaborar una regla o una ley dentro de un plano más teórico.

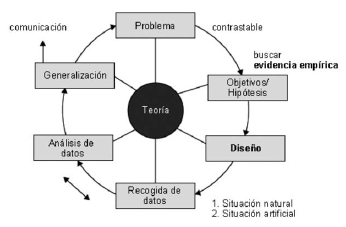

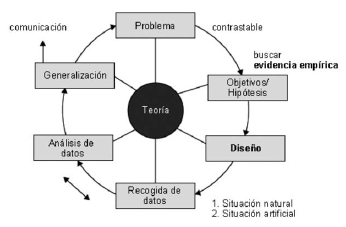

Figura 4. El método científico en el proceso de obtención del conocimiento puede utilizar diferentes estrategias de sistematización. Por un lado, puede ir del plano teórico al plano empírico mediante el uso de argumentaciones deductivas, y por otro lado, puede partir de la experiencia para establecer una ley general (ir del plano empírico al teórico) mediante el uso de argumentaciones inductivas (figura reproducida de Portell y colaboradores, 2003).

La metodología deductiva parte de un plano teórico en base a leyes generales para extraer implicaciones a través de la lógica que puedan ser contrastadas en un plano empírico. Mediante esta metodología, es posible partir de una regla o ley elaborada mediante la razón para deducir derivaciones lógicas que puedan ser adaptables a la experiencia del mundo en el que vivimos.

La metodología hipotética-deductiva se centra en el uso tanto de argumentaciones deductivas como de argumentaciones inductivas, en función de la fase de la investigación en la que nos encontremos. De este modo, es posible partir de una teoría para deducir una consecuencia contrastable en un plano empírico, llevando a cabo observaciones que permitan corroborar o transformar los supuestos de dicha teoría. También sería posible partir de un plano empírico realizando diferentes observaciones que permitan, mediante generalización, llegar a una teoría o ley general; a partir de la elaboración de la ley, volver a realizar observaciones en el plano empírico.

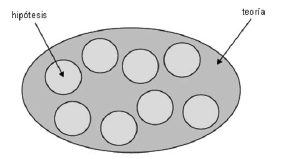

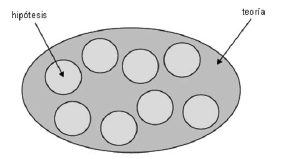

Durante la obtención del conocimiento, la investigación científica sigue un proceso claramente diferenciado. En primer lugar, se necesita un problema al que poder dar una respuesta utilizando el método científico. Este problema, por tanto, ha de ser contrastable. A partir de dicho problema, se han de generar los objetivos y las hipótesis de la investigación como explicación al fenómeno (problema) que se pretende estudiar. En esta fase del proceso de investigación, se han de forjar las bases que permitan la búsqueda de evidencias empíricas que confirmen o refuten las hipótesis planeadas. De hecho, una hipótesis resulta ser una solución tentativa a un problema o fenómeno de estudio. Ésta tiene que estar formulada con un perfil claramente contrastable. Por su parte, una teoría abarca el conjunto de soluciones tentativas contrastadas (hipótesis) sobre un determinado fenómeno o ámbito de análisis.

Figura 5. Una hipótesis es una solución tentativa a un fenómeno de estudio, mientras que la teoría resulta ser el conjunto de soluciones tentativas contrastadas sobre dicho fenómeno. Entre la teoría y la hipótesis aparece un conjunto de herramientas teóricas, de un nivel intermedio, que ayudan a vincularlas.

En la generación de hipótesis, se puede establecer una jerarquía. De esta forma, las hipótesis teóricas serían las más generales. Éstas se suelen denominar, por este motivo, hipótesis generales o de sistema. En una hipótesis general, no se suelen especificar las variables que se estudiarán en la investigación. Después, vendrían las hipótesis de la investigación o hipótesis empíricas, en cuyo núcleo se derivarían variables concretas. No obstante, todavía faltaría un nivel de mayor especificidad, ya que las variables en una hipótesis empírica no se encuentran operativizadas. Las hipótesis operativas presentan un núcleo con las variables de estudio definidas de forma operativa.

Después de la elaboración de cuestiones y/o de la deducción de hipótesis contrastables, tiene que plantearse el diseño experimental que permita obtener la información necesaria. Por ello, una vez planteado el diseño a utilizar se tienen que recoger los datos de la investigación, ya sea en una situación natural o en una situación artificial, dependiendo de la metodología utilizada y de los fines perseguidos. Dicha recogida de los datos es un paso crítico y previo para el análisis de los mismos, ya que lo predeterminará. En función de cómo se recojan los datos, las técnicas de análisis estadístico serán unas u otras. Del mismo modo, si se pretende utilizar una herramienta estadística determinada a priori, será necesario recoger los datos de una forma que permita su posterior implementación en la investigación. La fase final del proceso será la posible generalización de los resultados y su comunicación al resto de la comunidad científica y a la propia sociedad.

En las fases del proceso de la investigación científica, también podemos distinguir una serie de niveles que se producirán en una continuidad determinada que implicará tanto la utilización de inducciones como de deducciones, así como la operativización y la comunicación. En un nivel teórico conceptual, se delimitará el ámbito de estudio y la pregunta a responder mediante el uso de la metodología científica. En este nivel se ubican las hipótesis teóricas, las teorías y modelos, así como las hipótesis empíricas y las consecuencias contrastables. Mediante la operativización de éstas llegamos a un nivel técnico metodológico donde se diseña el plan de la investigación y la estrategia de recogida de datos mediante un tipo concreto de metodología (experimental, cuasi-experimental, selectiva y observacional). A partir de aquí, entramos en el nivel estadístico analítico, donde se elaboran y se reúnen los datos, determinando los modelos y las pruebas estadísticas que se utilizarán para contrastar las hipótesis y obtener pruebas de significación. De este nivel, mediante el uso de la inducción se discuten y generalizan los resultados para llegar al nivel expositivo, donde se han de comunicar al resto de la comunidad científica. De la exposición y comunicación de los resultados, el proceso vuelve a su punto de partida, es decir, al nivel teórico y conceptual.

Figura 6. Fases de la investigación científica para la obtención del conocimiento. (Reproducida de Portell, Vives i Boixadós (2010). Mètodes, Dissenys i Tècniques d’Investigació. Col·lecció d’esquemes. Bellaterra: UAB.

3.2.Evaluación del conocimiento: ¿por qué los científicos deben dudar de lo que está establecido?

La ciencia debe de dudar de todo lo establecido y debe examinarlo mediante un conjunto de procedimientos formales. Hemos de plantearnos que el conocimiento científico no es inmutable. Tiene que haber cierto dinamismo para poder avanzar y generar un acervo de conocimientos contrastados de forma empírica.

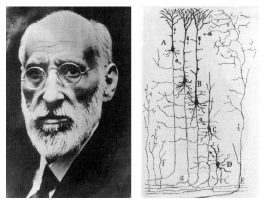

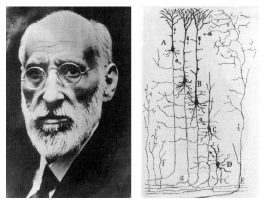

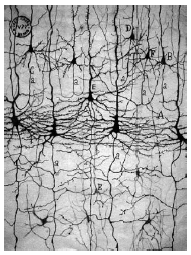

Imaginemos que hubiera sucedido si, a finales del siglo XIX, Santiago Ramón y Cajal no hubiera dudado del dogma biológico que aseguraba que el tejido nervioso era un retículo continuo que compartía el mismo citoplasma y que no presentaba células individuales. O bien imaginemos que la comunidad científica no hubiera dudado del consenso establecido sobre que las neuronas de un cerebro adulto habían perdido su capacidad mitótica y que, por tanto, la formación de nuevas neuronas era algo inverosímil en el tejido nervioso adulto. Se tiene que dudar para poder avanzar en el proceso de obtención del conocimiento. Es necesario someter a continua evaluación el conocimiento que se tiene acumulado.

Podemos destacar que, en el ámbito de la psicobiología, existen dos procedimientos claramente diferenciados para evaluar el conocimiento: la verificación y la falsación. Se trata de dos estrategias utilizadas para contrastar las hipótesis. Las hipótesis se han de contrastar, es decir, hemos de buscar evidencias empíricas que las confirmen o las rebatan. La verificación se basa en la búsqueda de datos que afirmen y confirmen la hipótesis trazada en una investigación, mientras que la falsación consiste en la búsqueda de datos que la objeten y refuten.

3.3.Variables: operativización y medida

En primer lugar es necesario definir qué es una variable. Una variable es un atributo susceptible de tomar diferentes valores que pueden ser medidos. Una vez se han identificado las variables implicadas en el núcleo de una hipótesis, se han de detallar y especificar hasta tal punto que sea posible explorarlas y medirlas. Este procedimiento de descripción y especificación de las variables se denomina operativización.

La operativización de una variable nos permite el establecimiento de un criterio de medida de la variable. En función del criterio de la escala de medida, podemos distinguir dos tipos fundamentales de variables:

1)Variables cuantitativas (discretas y continuas).

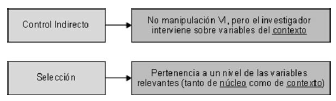

2)Variables categóricas (nominales –dicotómicas y politómicas– y ordinales). En relación a la hipótesis de una investigación, podemos distinguir:

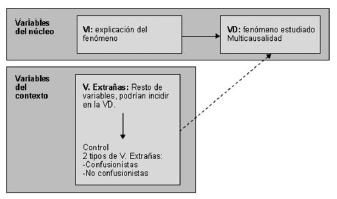

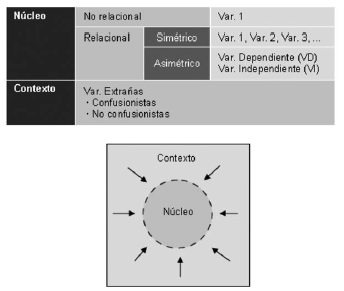

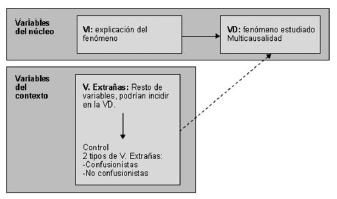

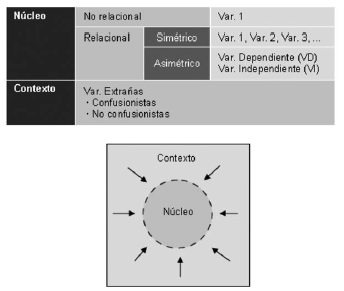

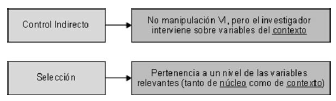

a)Las variables que derivan directamente de la hipótesis (variables del núcleo).

b)Las variables que se encuentran en el contexto de una investigación (variables del contexto).

Dentro de las variables del núcleo, se podrán establecer diferentes tipos de relaciones. Si la relación es bidireccional, diremos que se trata de una relación simétrica, ya que las dos variables ocupan el mismo estatus. Mientras que si la relación es unidireccional, diremos que se trata de una relación asimétrica. En este caso, las variables tienen diferente estatus. En el caso de estar delante de una relación asimétrica, dentro del núcleo de una hipótesis hemos de distinguir la variable independiente (VI) y la variable dependiente (VD). La VI es aquella variable sobre la que se hipotetiza que influirá en la dependiente. En un experimento en psicobiología, es la variable manipulada. La VD, por su parte, es la variable sobre la que se hipotetiza que influirá la VI. En el proceso de una investigación, se pretende explicar las causas de su variación. En definitiva, en una hipótesis determinada de una investigación, las variables del núcleo definirán el tipo de relación que se establecerá.

Figura 7. En una hipótesis de una investigación en psicobiología, se pretende explicar las variaciones encontradas en las medidas que tenemos de un fenómeno determinado, a partir de los diferentes niveles o valores de la variable independiente. No obstante, pueden existir explicaciones alternativas. En el contexto que se lleva a cabo una investigación, se dan lugar una serie de variables que no derivan directamente de la hipótesis experimental pero que puede tener un papel importante. Algunas de estas variables extrañas pueden ser confusionistas de la investigación, en tanto que actúen como posibles explicaciones alternativas de las variaciones ocurridas en la variable dependiente o fenómeno de estudio. (Reproducida de Portell, Vives i Boixadós (2010). Mètodes, Dissenys i Tècniques d’Investigació. Col·lecció d’esquemes. Bellaterra: UAB.

Las variables del contexto son aquellas variables extrañas que podrían influir sobre la VD. De este modo, podemos distinguir entre variables extrañas confusionistas y variables extrañas no confusionistas. Para que una variable extraña sea confusionista (presencia de espuriedad), se tienen que cumplir dos condiciones:

•En primer lugar, esta variable puede influir sobre la VD.

•En segundo lugar, los valores de la variable extraña covarían con los niveles con la VI.

Figura 8. Clasificación de las variables del núcleo y del contexto de una hipótesis. (Reproducida de Portell, Vives i Boixadós (2010). Mètodes, Dissenys i Tècniques d’Investigació. Col·lecció d’esquemes. Bellaterra: UAB).

Una variable confusionista es una variable no controlada que influye sobre la VD con la propiedad de variar simultáneamente con los cambios en los niveles de la VI.

Una variable confusionista rivaliza con la VI como posible causa de las variaciones encontradas en la VD. Las variables confusionistas deben controlarse para aumentar el control interno de la investigación y de esta forma aumentar la validez.

En función del criterio del diseño de una investigación, las variables pueden dividirse en tres grandes bloques claramente diferenciados:

•Variables independientes (manipuladas o no manipuladas).

•Variables dependientes.

•Variables extrañas (confusionistas o no confusionistas).

3.4.Relación, causalidad y validez

Dentro del ámbito de la psicobiología, resulta difícil asegurar, con todas las garantías suficientes, que una variable es causa de otra. No se trata de establecer una causa y un efecto, sino de contrastar una hipótesis causal donde se defina el grado de seguridad que se tiene de que las manipulaciones acaecidas en una determinada variable son la causa de las modificaciones encontradas en otra variable.

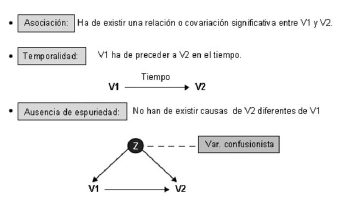

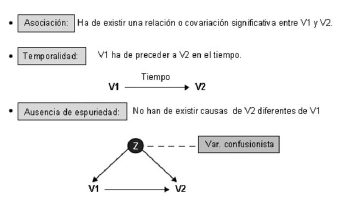

Para hablar de causalidad en una determinada relación, se tienen que cumplir 3 criterios:

1)Por un lado, ha de existir una relación o covariación que sea significativa entre las variables de estudio.

2)En segundo lugar, una de las variables ha de preceder en el tiempo a la otra variable (temporalidad).

3)En tercer lugar, no tiene que establecerse una relación espuria. Es decir, se tienen que descartar las causas diferentes de la variable objeto de estudio que no sean las variables independientes en la investigación (asegurar la ausencia de variables extrañas que confundan los resultados del experimento).

3.4.1.Validez

Cuando intentamos definir la validez de un determinado conocimiento, hemos de plantearnos la correspondencia entre lo que nos proponemos estudiar y lo que específicamente estamos estudiando.

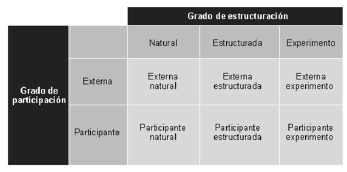

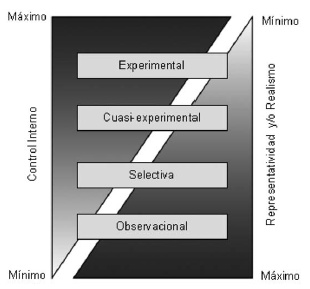

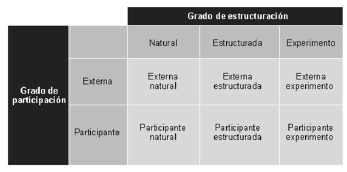

En relación a una investigación, podemos señalar diferentes tipos de validez. Dentro del marco de obtención del conocimiento de la psicobiología, teniendo presente las diferentes metodologías utilizadas y los diseños de investigación implementados dentro de dichas metodologías, al hablar de validez nos centraremos exclusivamente en los componentes que definen la validez externa y la validez interna.

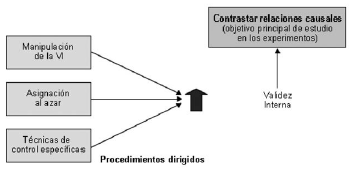

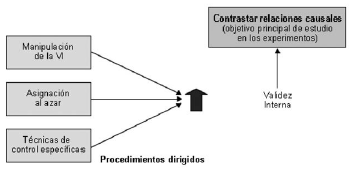

La validez interna es el grado de seguridad con el que podemos establecer y atribuir la causa de las variaciones encontradas en las medidas de la variable dependiente, a los cambios de la variable independiente. El control interno (caracterizado por la manipulación de la variable inde pendiente, el uso de la aleatorización y la implementación de técnicas de control específicas) que tenemos en la situación experimental nos permite rechazar interpretaciones alternativas.

La validez externa es el grado de seguridad con el que podemos generalizar los resultados de nuestra investigación a otros momentos temporales, a otros contextos y a otros sujetos de estudio. Esta capacidad de generalización de los resultados se centra en la representatividad y en las técnicas de muestreo utilizadas para seleccionar la muestra de la investigación.

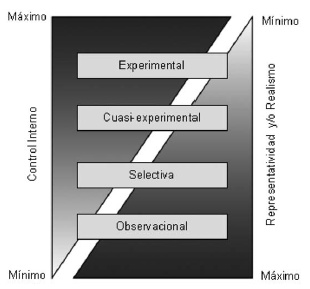

Al tratarse de una cuestión de graduación, las diferentes metodologías experimentales utilizadas en el marco de la psicobiología tendrán mayor o menor validez externa e interna en función del control interno (grado de intervención por parte del investigador sobre la situación objeto de estudio) que implementen en el contexto experimental, y en función de la representatividad (grado de correspondencia entre los sujetos estudiados y los sujetos de interés) y del realismo (grado de correspondencia entre la situación objeto de estudio y la situación natural de interés) de las investigaciones.

Figura 9. Posicionamiento de las diferentes metodologías de investigación habitualmente utilizadas en psicobiología en relación con el grado de control interno (validez interna) y el grado de representatividad y generalización de los resultados (validez externa) (Reproducida de Portell y col., 2003).

La metodología experimental se caracteriza por el nivel más alto de control interno y habitualmente por el nivel más bajo de representatividad y realismo. Por el contrario, la metodología observacional se encontraría en el extremo opuesto, dado que se minimiza el control interno, dotando a la situación de estudio de una gran dosis de realismo. Esto implica cierta cautela en el momento de emitir conclusiones sobre posibles relaciones causales. Entre ambos tipos de metodologías tenemos la metodología cuasiexperimental y la metodología selectiva.

3.5.Metodología experimental

En psicobiología, se pueden utilizar diferentes métodos y diseños de investigación. Los diseños experimentales permiten contrastar hipótesis sobre relaciones causales.

La metodología experimental se caracteriza por la presencia de la manipulación de la VI. Esto implica que el investigador ha de ser capaz de administrar los valores que toma para cada sujeto la VI. De esta forma, la manipulación de la VI puede garantizar que la causa potencial precede al efecto.

Figura 10. Criterios que se han de cumplir para poder inferir que V1 es la causa de V2. (Reproducida de Portell, Vives i Boixadós (2010). Mètodes, Dissenys i Tècniques d’Investigació. Col·lecció d’esquemes. Bellaterra: UAB.

Manipulación de variables

Hay variables independientes donde se puede llevar a cabo la manipulación, y otras donde no es posible.

1)Imaginemos que queremos estudiar el efecto que tiene un posible fármaco sobre la facilitación de la memoria. Para ello, tenemos dos condiciones experimentales: los sujetos que tomarán el fármaco (la pastilla con el principio activo: la galantamida) y los sujetos que tomarán un placebo (la pastilla sin el principio activo). En este caso, el investigador es capaz de asignar los sujetos de la muestra experimental a las diferentes condiciones experimentales (niveles de la VI). Se trata de una VI manipulada.

2)Ahora imaginemos otro experimento diferente, donde queremos analizar el efecto que tiene la personalidad sobre el rendimiento académico en los alumnos de primero de Psicología de una universidad. Concretamente, se pretende analizar dos rasgos de personalidad: la introversión y la extroversión. La VI de la investigación será la personalidad, con dos niveles (introversión y extroversión) y la VD será el rendimiento académico. El investigador no puede asignar los sujetos de su muestra a las dos condiciones experimentales. Lo que hará en su lugar es medir el rasgo de personalidad en los sujetos de su muestra y los dividirá en dos grupos, en función de si puntúan alto en introversión o en extroversión. En este caso, la VI no es manipulada.

En segundo lugar, la metodología experimental se caracteriza por utilizar la alea torización. Es decir, se caracteriza por la utilización de un procedimiento probadamente aleatorio para asignar los sujetos de la muestra a las diferentes condiciones experimentales. Si la muestra es suficientemente grande, mediante el uso de la aleatorización contamos con las suficientes garantías para creer que los diferentes grupos experimentales se encuentran equilibrados en relación a las variables extrañas (tanto conocidas como desconocidas). La aleatorización, junto con la manipulación de la VI, son las características definitorias y distintivas de la metodología experimental.

Figura 11. La manipulación de la VI, la utilización de la aleatorización y la implementación en la investigación de técnicas específicas de control son procedimientos dirigidos a aumentar el control interno de un experimento (grado de intervención por parte del investigador sobre la situación objeto de estudio) y, por tanto, de la validez interna. De este modo, al aumentar el grado de seguridad que tenemos de que los cambios en los valores de la VI explican las modificaciones en la VD, nos posibilita la contrastación de relaciones causales, que es el objetivo de los diseños experimentales.

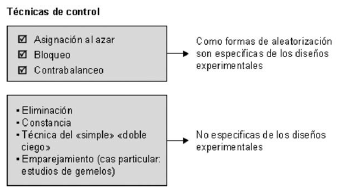

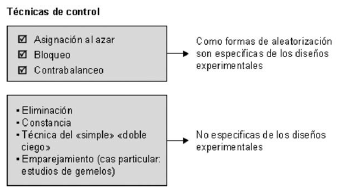

Una tercera característica (aunque no exclusiva de la metodología experimental) es el uso de técnicas específicas para llevar a cabo el control de las variables extrañas y de las diferentes fuentes de error. Se trata de evitar que las variables extrañas que pueden encontrarse en el contexto de una investi gación se conviertan en variables confusionistas. De esta forma, mediante el uso de las técnicas de control se pretenderá que los diferentes grupos sean lo más parecidos en relación a las variables extrañas, de manera que lo único que varíe entre ellos sea el nivel de la VI al que han sido asignados.

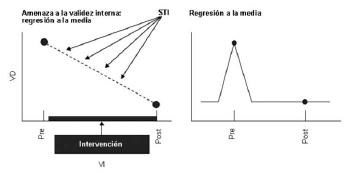

Por lo que se refiere a las fuentes de error, existen diferentes. Una fuente de error que puede afectar a un diseño experimental es la pérdida no aleatoria de sujetos o atrición. Este tipo de fuente de error hace referencia a la pérdida de los participantes de una investigación explicada por motivos diferentes al azar y relacionada con las variables del estudio. Otra fuente de error es aquella relacionada con las expectativas que tienen el sujeto experimental y el investigador sobre el desarrollo y los resultados de un experimento. Una manera de controlar esta fuente de error sería mediante la utilización del simple o doble ciego, en función de si es el sujeto experimental el que desconoce la condi ción experimental a la que ha sido asignado, o bien lo desconoce tanto el sujeto como el propio investigador. Una tercera fuente de error que deberíamos controlar es la de regresión a la media. La regresión a la media es la tendencia de los datos que presentan valores extremos a tornar hacia la media, cuando se repiten las medidas. Esta tendencia se puede explicar por la probabilidad insignificante de que se repitan las ocurrencias excepcionales que favorecen a que una valoración sea extrema. Este tipo de tendencia de los datos suele ser frecuente en el patrón genético de herencia multifactorial.

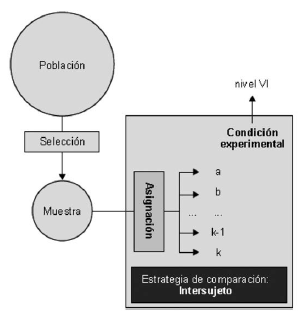

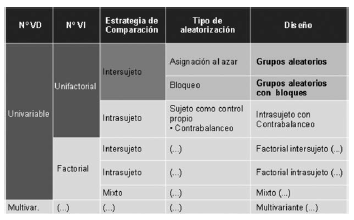

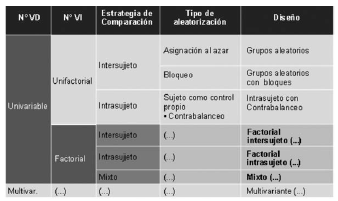

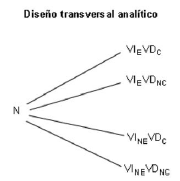

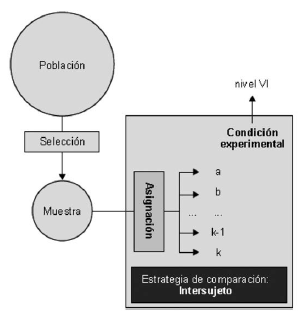

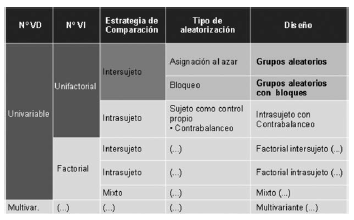

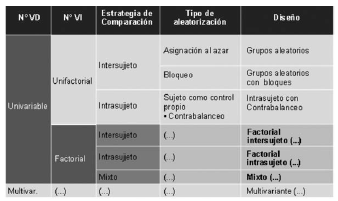

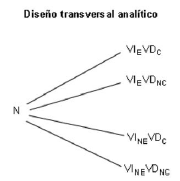

3.5.1.Diseños unifactoriales intersujeto

Los diseños unifactoriales intersujeto son diseños experimentales caracterizados por la presencia de una sola variable independiente (dé ahí unifactoriales) y por el uso de un procedimiento probadamente aleatorio (asignación al azar sin restricciones o con restricciones: bloqueo) para asignar los sujetos sólo a una de las posibles condiciones experi mentales utilizando, por tanto, una estrategia de comparación intersujeto.

Figura 12. En los diseños experimentales se pueden utilizar diferentes estrategias de comparación de los sujetos experimentales. Una de las estrategias de comparación es la denominada intersujeto. Para ello, se selecciona los sujetos de la muestra de la población de estudio (el procedimiento de selección no tiene que ser necesariamente aleatorio) y se distribuye los sujetos de la muestra asignándolos a cada una de las condiciones experimentales utilizando un procedimiento probadamente aleatorio, de tal forma que cada sujeto de la muestra será asignado únicamente a una condición experimental. (Reproducida de Portell, Vives i Boixadós (2010). Mètodes, Dissenys i Tècniques d’Investigació. Col·lecció d’esquemes. Bellaterra: UAB.

Si la asignación de los sujetos a las condiciones experimentales se lleva a cabo sin ningún tipo de restricción, a medida que aumenta el tamaño de la muestra aumentará la probabilidad de obtener grupos equilibrados en relación a las variables confundidoras (tanto conocidas como desconocidas). El objetivo que se persigue es que los grupos que comparemos mediante la estrategia intersujeto sean lo más equivalentes posibles. Se trata de que las variables que puedan confundir los resultados de la investigación se distribuyan de forma equilibrada en las diferentes condiciones experimentales, de tal forma que la única diferencia sustancial entre los grupos debería ser la variable independiente. No obstante, a veces el tamaño de la muestra no es lo suficientemente grande. En este caso, si tenemos conocimiento de alguna posible variable confusionista, para que ésta quede bien repartida (equilibrada en las diferentes condiciones experimentales) se podría utilizar un procedimiento de aleatorización con implementación de restricciones: el bloqueo.

Para llevar a cabo una asignación aleatoria con restricciones (bloqueo) es necesario seguir los siguientes pasos:

•Medir (ordenar o clasificar) a los sujetos en la variable extraña que deseamos controlar por bloqueo.

•Llevar a cabo agrupaciones de sujetos (bloques) con valores similares en la variable que se bloquea.

•Asignar al azar los sujetos de cada bloque a cada uno de los grupos experimentales (niveles de la VI, condiciones experimentales).

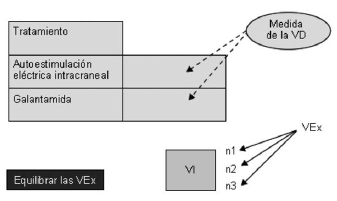

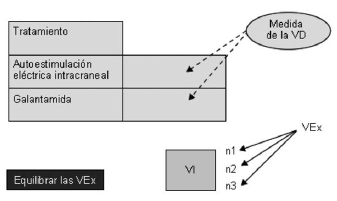

Facilitación del aprendizaje espacial en ratas

Si queremos evaluar el efecto que tienen dos tratamientos (autoestimulación eléctrica intracraneal –AEIC– y la administración de galantamida) sobre la facilitación del aprendizaje espacial en ratas, podemos llevar a cabo una estrategia de comparación intersujeto, es decir, asignar los sujetos experimentales a una sola de las condiciones. Imaginemos que se identifica una variable extraña que puede actuar sobre la VD y variar simultáneamente con los diferentes niveles de la VI (una posible variable confusionista).

Según la literatura previa, se ha puesto de manifiesto que la conducta motora de los animales puede influir en el rendimiento de los sujetos en la prueba de aprendizaje espacial que vamos a utilizar en nuestro experimento. Por ello, para asegurarnos de que los grupos experimentales (el grupo que recibirá la AEIC y el grupoque recibirá la galantamida) se encuentran equilibrados en cuanto a la variable conducta motora, se lleva a cabo un procedimiento de bloqueo. Para ello, se mide y se ordena a los sujetos en la variable extraña que deseamos controlar por bloqueo (conducta motora), utilizando una prueba cuya puntuación mínima es de 0 y máxima de 10. Seguidamente, llevamos a cabo una agrupación de los sujetos, formando dos bloques en relación a los valores que presentan en la variable que se bloquea. De esta forma, el primer bloque incluirá a los sujetos que obtengan una puntuación menor de 5 en la prueba de conducta motora, y el segundo bloque a los sujetos que obtengan una puntuación mayor o igual a 5. Por último, se asignará al azar los sujetos de cada bloque a cada uno de los grupos experimentales (AEIC y galantamida). Con este procedimiento nos aseguramos que la variable extraña quede equilibrada en las dos condiciones experimentales.

Figura 13. Si queremos evaluar el efecto que tienen dos tratamientos (autoestimulación eléctrica intracraneal y la administración de galantamida) sobre la facilitación del aprendizaje espacial en ratas, podemos llevar a cabo una estrategia de comparación intersujeto. Si la muestra es suficientemente grande, podemos asumir que mediante la implementación de un procedimiento de aleatorización sin restricciones, las variables extrañas quedarán equilibradas entre los dos grupos experimentales. Sin embargo, en otros casos será conveniente aplicar la técnica del bloqueo tal como se muestra en el ejemplo.

En función del control que se quiera llevar a cabo y la especificidad, podemos llevar a cabo el bloqueo usando dos tipos de procedimiento:

•Bloqueo con diversos sujetos por nivel y bloque.

•Bloqueo con un sujeto por nivel y bloque.

| DISEÑO DE GRUPOS ALEATORIOS CON DIVERSOS SUJETOS POR NIVEL Y BLOQUE |

| Bloque conducta motora | Condición experimental |

| C. motora < 5 | AEIC |

| Galantamida |

| C. motora > 5 | AEIC |

| Galantamida |

Por consiguiente, podemos destacar que el bloqueo es una técnica de control específica del diseño experimental dirigida a la consecución de grupos equilibrados para poder establecer su comparación en relación a los valores presentados en la VD, minimizando la presencia de variables extrañas que puedan ser confusionistas. Resulta una técnica más efectiva que la técnica de asignación aleatoria sin restricciones para conseguir el control experimental cuando se trata de muestras pequeñas. No obstante, esta técnica nos exige medir y clasificar a los sujetos previamente a la realización del experimento.

En definitiva, en los diseños unifactoriales que utilizan la estrategia de comparación intersujeto (asignar los sujetos solamente a una de las posibles condiciones experimentales), podemos utilizar dos de las formas de aleatorización que son específicas de los diseños experimentales:

•Asignación aleatoria sin restricciones.

•Asignación aleatoria con restricciones: bloqueo.

No obstante, existen otro tipo de técnicas de control que no son específicas de los diseños experimentales y que se podrán utilizar para aumentar el grado de control interno y, por tanto, el grado de validez interna:

•Constancia.

•Eliminación.

•Control por placebo.

•Simple, doble y triple ciego.

•Emparejamiento.

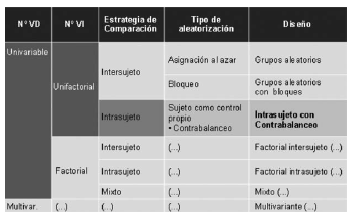

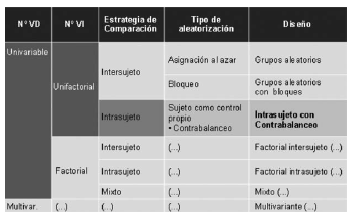

Figura 14. Esquema de los diseños experimentales en función del número de variables dependientes, el número de variables independientes, la estrategia de comparación utilizada y el procedimiento de aleatorización implementado. En negrita, pueden verse los dos diseños fundamentales unifactoriales intersujetos. (Reproducida de Portell y col., 2003).

Estudio de emparejamiento llevado a cabo con la comparación de gemelos monocigóticos y dicigóticos criados juntos y separados

Los “gemelos Jim” eran dos chicos que semanas después de su nacimiento fueron adoptados por familias diferentes. Ni los gemelos ni las familias sabían la existencia del otro. Cuando se encontraron a la edad de 39 años, descubrieron que sus vidas estaban repletas de increíbles coincidencias: no sólo ambos se llamaban Jim, sino que cada uno de ellos se casó con una mujer llamada Betty, los nombres de sus hijos fueron James Alan y James Allen, respectivamente y tenían un perro llamado Toy. Ambos trabajaban en el mismo oficio, conducían el mismo coche y pasaban las vacaciones en el mismo lugar. Tenían la misma altura, peso y fumaban la misma marca de tabaco.

Thomas Bouchard y colaboradores (Universidad de Minnesota, 1990) identificaron más de 100 parejas de gemelos monocigóticos y dicigóticos que habían sido criados juntos y separados. Estos autores examinaron una gran variedad de rasgos y de características psicológicas y cognitivas. En general, pudieron comprobar que los gemelos monicigóticos eran más similares que los dicigóticos, independientemente de si habían sido criados juntos o separados.

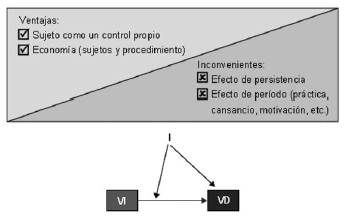

3.5.2.Diseños unifactoriales intrasujeto

Hasta el momento, hemos visto que, en el diseño de una investigación en psicobiología, lo que interesa es que los diferentes grupos de sujetos sean equivalentes. Esto es debido a que los grupos que se comparan se encuentran formados por individuos diferentes. Si el reparto de los sujetos (con sus variables extrañas) no fuera el adecuado, podríamos encontrarnos con diferencias entre los grupos experimentales que no responden a la manipulación de la VI, sino a fuentes de confusión. En definitiva, lo que se perseguía era que los grupos estuvieran lo más equilibrados posible en relación con las fuentes de confusión (tanto conocidas como desconocidas). Por ello, la necesidad de utilizar un procedimiento de aleatorización. En este punto, cabría preguntarse si existe alguna otra estrategia que nos permita tener equilibradas las fuentes de confusión en todas las condiciones experimentales. La respuesta podría ser la utilización de los mismos sujetos en todas las condiciones experimentales, de modo que cada sujeto nos serviría como control propio y evitaría descompensaciones y desequilibrios debidos a las variables que afectaran más a un grupo que a otro.

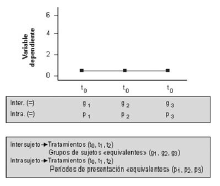

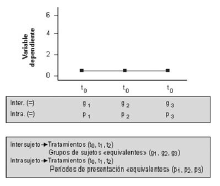

El diseño unifactorial intrasujeto se caracteriza por la presencia de una sola VI y por el uso de una estrategia de comparación intrasujeto. La estrategia de comparación utilizada se fundamenta en la idea de que todos los sujetos pasan por todas las condiciones experimentales. No obstante, si decíamos al principio que para hablar de un diseño experimental es necesario utilizar un procedimiento de aleatorización, ¿dónde podríamos implementarlo en este tipo de diseños? El procedimiento de aleatorización se lleva a cabo en relación a los órdenes de presentación de las diferentes condiciones experimentales. De este modo, todos los sujetos recibirán todas las condiciones experimentales, pero no todos las recibirán en la misma secuencia de presentación.

Figura 15. En los diseños experimentales que utilizan la estrategia de comparación intrasujeto, se selecciona los sujeto de la población de estudio (el procedimiento de selección no tiene que ser necesariamente aleatorio) y se distribuyen al azar a diferentes órdenes de presentación de las condiciones experimentales. Cada sujeto pasa por todas las condiciones experimentales, lo que cambia es el orden de administración de las mismas (figura reproducida de Portell y col., 2003).

Supongamos que estuviéramos ante una VI con 3 niveles, correspondientes a 3 tratamientos experimentales (t 0, t1, t2) de los cuales se pretende valorar su eficacia. Al tener 3 condiciones experimentales, con un diseño intersujeto tendríamos 3 grupos de sujetos diferentes (el grupo que recibiera el nivel t0, el grupo que recibiera el nivel t1 y el grupo que recibiera el nivel t2). Lo que perseguiremos es que los 3 grupos seanequivalentes, es decir, que estén lo más equilibrados posible en relación a las variables extrañas, tanto conocidas como desconocidas. Si todas las variables extrañas se encontraran perfectamente equilibradas en los 3 grupos y administráramos el mismo tratamiento a los 3 (por ejemplo, el t0), ¿qué esperaríamos encontrar? Los resultados deberían mostrar el mismo valor en los 3 grupos en relación a la VD (una línea paralela en el eje de abscisas). En los diseños que utilizan una estrategia de comparación intrasujeto, tenemos asegurada la comparabilidad entre grupos, ya que se encuentran formados por los mismos sujetos. De esta forma, el mismo sujeto actúa como propio control. En este caso, teniendo presente que un sujeto recibirá todos los niveles de la VI (siguiendo con el ejemplo, los tratamientos t0, t1, t2), lo que tiene que ser comparable son los diferentes momentos en los que el sujeto recibe los diferentes niveles de la VI. Dicho de otro modo, los diferentes periodos de presentación han de ser equivalentes. En un diseño experimental intersujeto, los diferentes tratamientos se aplican simultáneamente. Esto no es posible en un diseño intrasujeto, ya que el sujeto ha de recibirlos todos y tiene que existir un tiempo de “lavado” entre cada tratamiento para evitar la persistencia de su efecto cuando se administra el siguiente. Partiendo de esta idea, si los periodos en los que se aplican los tratamientos (p0, p1, p2) fueran totalmente equivalentes y administráramos el mismo tratamiento (por ejemplo, el t0), lo que esperaríamos encontrar es el mismo valor en los 3 momentos en relación a la VD.

Figura 16. Comparación de las estrategias de comparación intersujeto e intrasujeto en relación a la equivalencia entre los grupos de sujetos diferentes y los diferentes momentos de presentación de los niveles de la VI. (Reproducida de Portell, Vives i Boixadós (2010). Mètodes, Dissenys i Tècniques d’Investigació. Col·lecció d’esquemes. Bellaterra: UAB.

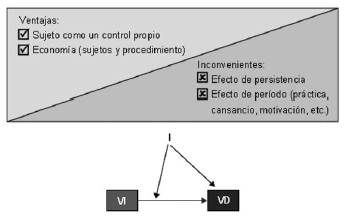

La estrategia de comparación intrasujeto tiene diferentes ventajas, derivadas del hecho de que el sujeto actúa como un control propio. De esta forma, se eliminan las diferencias individuales que podemos encontrarnos cuando comparamos grupos de sujetos diferentes. Del mismo modo, este tipo de estrategia posibilita tener diseños más económicos en cuanto al número de sujetos y en relación al procedimiento.

No obstante, también presenta una serie de desventajas e inconvenientes que debemos tener en cuenta y controlar en la medida de lo posible. Por un lado, los diseños intrasujeto pueden presentar el efecto de la persistencia. Éste se produce en tanto que el efecto de un tratamiento (t0) aplicado en un momento (p0) persiste cuando se aplica otro tratamiento (t1) diferente en un momento posterior (p1). Por otro lado, un segundo aspecto a controlar con la estrategia de comparación intrasujeto es el efecto del periodo. Éste tiene lugar cuando la propia medida de la VD hace que los diferentes periodos no sean equivalentes. Se trata de un conjunto de factores que se derivan del hecho de que los sujetos tengan que repetir en diversas ocasiones la tarea experimental que utilizada para me dir y evaluar la VD.

En ocasiones no podemos asegurar que, cuando aplicamos un nivel de la VI, se ha extinguido por completo el nivel aplicado anteriormente. Si tenemos la sospecha de que los efectos de un tratamiento (por ejemplo, p0) persisten a lo largo del tiempo, se deberían establecer periodos de extinción entre un tratamiento y el siguiente, y diferentes medidas para estudiar la influencia. A pesar de ello, en algunas ocasiones este procedimiento resulta insuficiente para evitar la persistencia y hemos de acudir a diseños más complejos. Si se consigue la eliminación de la persistencia, estamos más seguros de la influencia de la VI sobre la VD. Es decir, mejoramos la validez interna del experimento.

Figura 17. Principales ventajas e inconvenientes de la estrategia de comparación intrasujeto. (Reproducida de Portell y col., 2003).

En relación al efecto del periodo, existen diferentes factores que pueden implicar que los momentos en los que se administran los diferentes niveles de la VI no sean equivalentes:

•Aprendizaje.

•Fatiga.

•Motivación.

•Práctica.

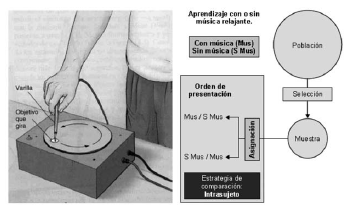

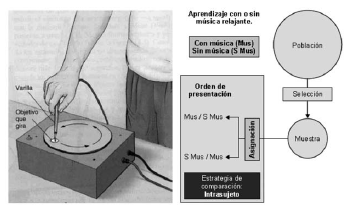

Ejemplo de aprendizaje

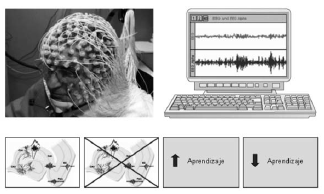

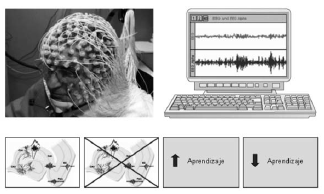

Imagínese que se quiere estudiar el efecto de la música relajante sobre una tarea de aprendizaje que consiste en perseguir un objetivo en movimiento con una varilla metálica en un rotor. Este tipo de aprendizaje sabemos que depende del sistema de memoria del estriado dorsal. Para llevar a cabo el experimento, se selecciona una muestra de la población objeto de estudio y se asignan aleatoriamente los sujetos de la muestra a los diferentes órdenes de presentación, de tal forma que todos los sujetos pasan por las dos condiciones experimentales (llevar a cabo la tarea de aprendizaje con y sin música). ¿Sería adecuado utilizar esta estrategia de comparación? Seguramente, los sujetos tendrán una mejor ejecución en el segundo periodo de administración de la tarea (independientemente de si ésta se realiza con o sin música). Este resultado lo podríamos explicar por el efecto de la práctica o del aprendizaje.

Figura 18. Aprendizaje con o sin música relajante.

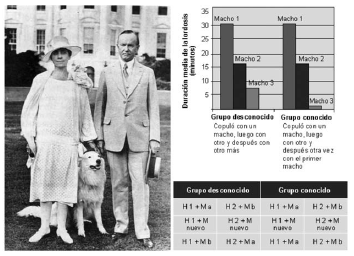

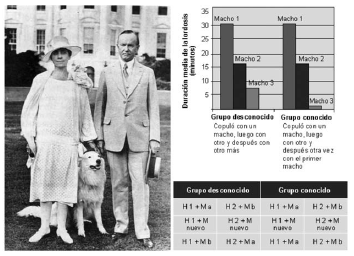

En relación a los inconvenientes de la estrategia de comparación intrasujeto, un diseño experimental llevado a cabo por Lester y Gorzalka en 1988, resalta la importancia de los inconvenientes de este tipo de estrategia de comparación y la dificultad que supone controlarlos. Estos investigadores se plantearon estudiar el efecto Coolidge (aumento de la receptividad sexual cuando un sujeto cambia de pareja después de copular con otra, en comparación a si continuara copulando con la misma) en hámsters hembras. Este efecto se había demostrado claramente en hámsters machos, pero no se había podido poner de manifiesto en hámsters hembras debido a la fatiga sexual que presentaban los machos al copular por segunda vez.

El efecto Coolidge

El nombre del efecto Coolidge proviene de un chascarrillo, contado en forma de anécdota, que describía la visita del presidente de Estados Unidos de América Calvin Coolidge (1872-1933) y su esposa, a una granja avícola. Durante la visita a la granja, la primera dama preguntó al granjero cómo se las arreglaba para conseguir que se engendraran tantos huevos fértiles con un número tan exiguo de gallos. El granjero, orgulloso, le reveló que sus gallos desempeñaban su deber docenas de veces cada día. “Quizá podría explicárselo al señor Coolidge”, replicó la señora Coolidge en un claro tono intencional hacia el presidente. Éste, al escuchar el comentario de su esposa, le inquirió al granjero: “¿Cada gallo cubre a la misma gallina cada vez?”. “No”, exclamó el granjero, “cada gallo tiene a su disposición a muchas gallinas”. “Quizá podría hacérselo saber a la señora Coolidge”, respondió el señor Coolidge.

Figura 19. El efecto Coolidge.

Lester y Gorzalka (1988) quisieron estudiar este efecto (que ya se había demostrado en machos de diferentes especies) en hembras de hámster. Estos investigadores, en un intento de control para que los periodos de presentación de los niveles de la VI fueran equivalentes y la fatiga de los machos no constituyera una dificultad en la atribución de causalidad entre la VI y la VD (al inducir el efecto del periodo), diseñaron el siguiente procedimiento: las hembras del grupo familiar, después de copular con un primer macho (macho a o macho b), copulaban con un segundo macho (macho nuevo), que se utilizaba para que el primer macho pudiera descansar y, de esta forma, su fatiga no enmascarara la receptividad sexual de las hembras. Al acabar con el segundo macho, las hembras eran puestas a copular con un tercer macho (macho a o macho b) que resultaba ser el mismo con el que habían copulado durante la primera ocasión. En el grupo desconocido, el procedimiento era similar; la única diferencia consistía en que, durante la tercera cópula, el macho resultaba ser diferente al introducido durante la primera cópula. Los resultados mostraron que la conducta receptiva de las hembras (conducta lordótica medida en segundos) durante la tercera cópula fue significativamente mayor en las hembras que habían copulado con un macho diferente al de la primera cópula (grupo desconocido).

Para poder controlar los efectos de la persistencia y del periodo, es posible utilizar una técnica muy efectiva: el contrabalanceo o reequilibrado. Esta técnica consiste en la variación sistemática del orden de presentación de los niveles de la VI. Es decir, consiste en llevar a cabo una repetición de la secuencia de presentación de las condiciones experimentales en orden inverso.

El procedimiento a seguir es el siguiente:

1)Generar las permutaciones posibles de los niveles de la VI (secuencias ordenadas de K elementos tomados de un conjunto de n elementos diferentes).

2)Asignar al azar los sujetos de la distribución muestra a las secuencias (órdenes de presentación).

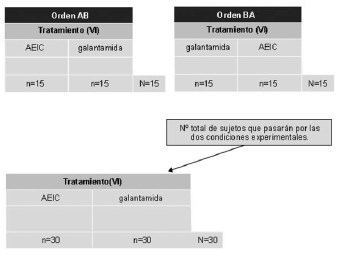

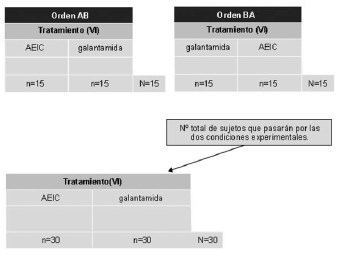

Ejemplo de contrabalanceo

Si queremos evaluar el efecto que tienen dos tratamientos (autoestimulación eléctrica intracraneal –AEIC– y la administración de galantamida) sobre la facilitación del aprendizaje espacial en ratas, podemos llevar a cabo una estrategia de comparación intrasujeto, de tal forma que todos los animales recibirán los dos tratamientos. El procedimiento de aleatorización se lleva a cabo en relación a los órdenes de presentación de las diferentes condiciones experimentales. De este modo, todos los sujetos recibirán todas las condiciones experimentales, pero no todos las recibirán en la misma secuencia de presentación. De los 30 sujetos de nuestra muestra, 15 recibirán los tratamientos en el orden de presentación AB (primero AEIC y luego galantamida) y 15 lo harán en el orden BA (primero galantamida y luego AEIC). Nótese que los 30 sujetos recibirán tanto el tratamiento de AEIC como el tratamiento de galantamida.

En algunas ocasiones, se dan situaciones en las que el uso de los diseños intrasujeto es insostenible, ya que resulta imposible hacer reversible el valor de la VI para cada sujeto.

Figura 20. Ejemplo de contrabalanceo.

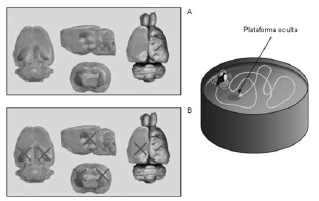

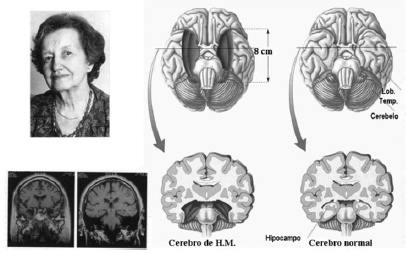

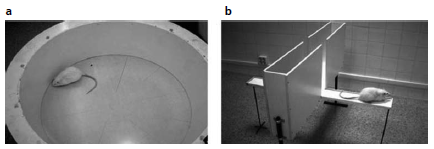

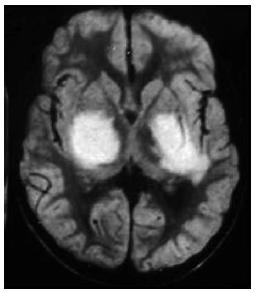

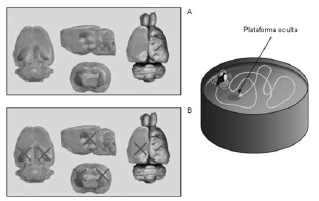

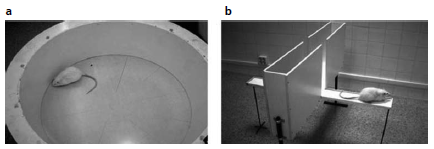

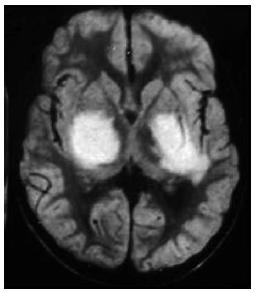

El laberinto acuático de Morris

El hipocampo es una estructura crítica para procesar y recordar información espacial y contextual. En base a esta premisa, se pretende evaluar el papel de esta estructura del lóbulo temporal medial en una tarea de aprendizaje espacial: el laberinto acuático de Morris. El laberinto de agua fue diseñado en 1984 por Richard G. Morris para estudiar y evaluar el aprendizaje y la memoria espacial en ratas de laboratorio. El laberinto acuático es una piscina circular llena de agua a una temperatura que oscila entre los 18 y los 27° C, según se utilicen ratas o ratones, en la que se sumerge una plataforma que debe ser localizada por el animal. El agua se vuelve opaca con leche o alguna sustancia no tóxica como el látex para que el animal no vea la plataforma, aunque se ha demostrado que esto no es necesario, ya que el animal nada con la cabeza por encima del agua, lo que le impide ver la plataforma.

En la versión tradicional del laberinto, los sujetos experimentales nadan desde diferentes puntos de salida, situados en el perímetro de la piscina, hasta encontrar la plataforma escondida bajo el agua. Para localizar la plataforma, el sujeto depende de unos puntos de referencia, lo cual implica un amplio rango de posibilidades tales como pequeños objetos localizados inmediatamente alrededor de la circunferencia de la piscina.

Imagínese que se quiere llevar a cabo un experimento para evaluar si las lesiones bilaterales del hipocampo deterioran el aprendizaje espacial en ratas utilizando esta tarea. Para ello, se diseña un procedimiento con dos condiciones experimentales: (A) intervención quirúrgica sin lesión hipocampal, (B) lesión bilateral del hipocampo. En este tipo de diseño, no podemos utilizar una estrategia de comparación intrasujeto, ya que la manipulación de la VI hace que la condición experimental sea irreversible. Si se utiliza el contrabalanceo como técnica de aleatorización, únicamente podría llevarse a cabo el orden de presentación de los niveles de la VI AB, pero no el orden BA (ya que la lesión del hipocampo hace la situación irreversible). Para llevar a cabo este experimento, necesitaríamos utilizar una estrategia de comparación intersujeto y comparar grupos independientes. Si la muestra es suficientemente grande y se utiliza un procedimiento probadamente aleatorio para asignar los sujetos a las condiciones experimentales, podemos asumir que las variables extrañas se equilibrarán formando grupos equivalentes.

Figura 21. Ejemplo de contrabalanceo: estudio del hipocampo.

En definitiva, los diseños intrasujeto minimizan las amenazas a la validez interna debidas a las diferencias individuales, pero aparecen otras amenazas a la validez interna debidas a la administración de diferentes tratamientos a todos los sujetos de la muestra: efecto del periodo y efecto de la persistencia.

De todo lo visto hasta el momento, podemos resumir que el diseño experimental presenta tres formas de aleatorización que son específicas del mismo:

•Asignación aleatoria sin restricciones.

•Asignación aleatoria con restricciones (bloqueo).

•Contrabalanceo.

Figura 22. Esquema de los diseños experimentales en función del número de variables dependientes, el número de variables independientes, la estrategia de comparación utilizada y el procedimiento de aleatorización implementado. En negrita, puede verse el diseño unifactorial intrasujeto. (Reproducida de Portell, Vives i Boixadós (2010). Mètodes, Dissenys i Tècniques d’Investigació. Col·lecció d’esquemes. Bellaterra: UAB.

Las dos primeras son características de la estrategia de comparación intersujeto, mientras que el contrabalanceo es característica de la estrategia de comparación intrasujeto. Por otro lado, hay una serie de técnicas de control que no resultan específicas de la metodología experimental y que podrán aparecer en otro tipo de diseños.

3.5.3.Diseños factoriales

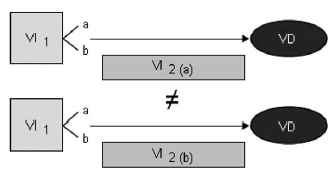

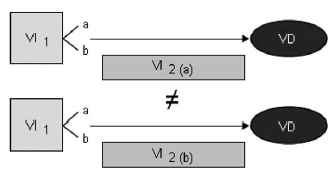

Los diseños factoriales se caracterizan por estudiar simultáneamente dos o más VI. Para ello, los niveles de las VI se tienen que presentar combinados.

Figura 23. El diseño experimental presenta tres formas de aleatorización que son específicas del mismo: asignación aleatoria sin restricciones, asignación aleatoria con restricciones (bloqueo) y el contrabalanceo. Las dos primeras son características de la estrategia de comparación intersujeto, mientras que el contrabalanceo es característica de la estrategia de comparación intrasujeto. Por otro lado, hay una serie de técnicas de control que no resultan específicas de la metodología experimental y que podrán aparecer en otro tipo de diseños. (Reproducida de Portell y col., 2003).

Ejemplo de diseño factorial

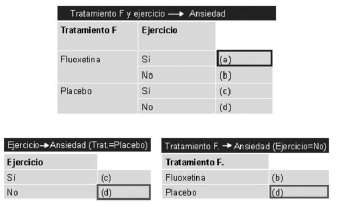

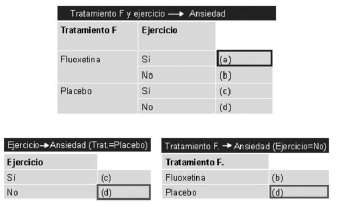

Existen evidencias previas que sugieren que un programa de ejercicio físico regular puede ayudar a reducir el nivel de ansiedad generalizado. Por otro lado, la fluoxetina (un inhibidor selectivo de la recaptación de serotonina) se ha utilizado ampliamente en el ámbito clínico para reducir diferentes trastornos de tipo depresivo. No obstante, evidencias recientes parecen poner de manifiesto que este fármaco podría utilizarse también para el tratamiento de la ansiedad. Si se pretende estudiar el efecto que tienen dos VI (ejercicio físico regular y tratamiento farmacológico: administración de fluoxetina) sobre el nivel de ansiedad que tiene una persona, podríamos utilizar dos diseños unifactoriales, uno para cada una de las VI. No obstante, si lo que se pretende es estudiar de forma simultánea el efecto que tienen las dos VI sobre la VD, utilizaremos un diseño factorial, presentando los niveles de las VI combinados. Con un diseño factorial, se puede evaluar la presencia de interacción entre las VI, para analizar si el efecto que tiene una de las VI sobre la VD depende de la otra VI.

En los diseños factoriales, por tanto, todos los niveles de una variable independiente se combinan con todos los niveles del resto de variables. Esto se puede observar claramente si se representa en el esquema del diseño experimental. Estudiando dos variables de forma simultánea, podemos obtener más información que haciéndolo de forma separada.

Esquema de un diseño factorial y de dos diseños unifactoriales

¿Nos proporciona el mismo tipo de información dos diseños unifactoriales que uno factorial con las mismas variables? Imaginemos que queremos estudiar el efecto de la administración de un programa de ejercicio físico regular y el efecto de la administración de un tratamiento farmacológico (fluoxetina, un inhibidor selectivo de la recaptación de serotonina) sobre el nivel de ansiedad. Para ello, podemos llevar a cabo dos diseños unifactoriales (parte inferior de la figura 25). En el primer diseño, evaluaríamos el efecto del ejercicio sobre la ansiedad, y en el segundo experimento, el efecto de la fluoxetina sobre la misma VD. Si nos fijamos en las condiciones experimentales que se representan, podemos observar que la información es redundante, ya que la condición d (sujetos que no hacen ejercicio regular, ni se les administra fluoxetina) se repite. Si llevamos a cabo el estudio, pero analizando el efecto de las dos VI simultáneamente, combinando los niveles de ambas (diseño factorial), podemos observar que nos proporciona información extra que no quedaba plasmada en los dos diseños unifactoriales (condición a: sujetos que hacen ejercicio regular y se les administra fluoxetina).

Figura 24. Esquema de un diseño factorial y de dos diseños unifactoriales. (Reproducida de Portell, Vives i Boixadós (2010). Mètodes, Dissenys i Tècniques d’Investigació. Col·lecció d’esquemes. Bellaterra: UAB.

En un diseño factorial, la notación del diseño viene dada por:

N° nivelesVI-1 x N° nivelesVI-2 x …. x N° nivelesVI-j.

De tal forma que un diseño con dos VI, cada una de las cuales con dos niveles, tendría la notación de 2 x 2.

Un diseño factorial puede combinar variables con diferentes niveles, variables que sigan una estrategia de comparación intrasujeto con variables que sigan unaestrategia de comparación intersujeto y variables manipuladas con variables no manipuladas. No obstante, para hablar de un diseño experimental es necesario que, al menos, una de las VI sea experimental, es decir, que cumpla las dos características de la metodología experimental:

•Uso de un procedimiento de aleatorización (asignación aleatoria sin restricciones o bloqueo en el caso de la estrategia de comparación intersujeto y contrabalanceo en el caso de la estrategia de comparación intrasujeto).

•Manipulación de la variable.

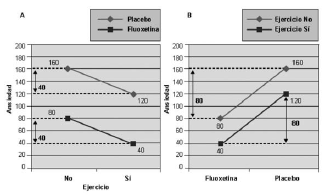

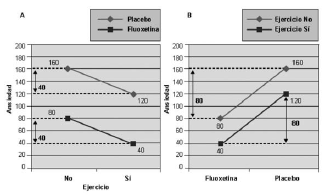

En definitiva, en un diseño factorial podemos estudiar el efecto conjunto de las VI (interacción). Para ello, se puede utilizar una representación gráfica de los resultados de una de las VI en el eje de abscisas agrupados bajo las condiciones de la otra V1.

Figura 25. Representación gráfica de un diseño factorial 2x2.

Ejemplo de diseño factorial

Se pretende estudiar (figura 26) de una forma simultánea el efecto de la administración de un programa de ejercicio físico regular (VI1) y el efecto de la administración de un tratamiento farmacológico (fluoxetina, un inhibidor selectivo de la recaptación de serotonina) (VI2) sobre el nivel de ansiedad (VD).

En la figura A, vemos representados en el eje de ordenadas los valores de la VD (nivel de ansiedad de los sujetos), y en el eje de abscisas los valores de la VI1 (administración de un programa de ejercicio físico regular, representados en función de los niveles de la VI2 (administración de un tratamiento farmacológico).

En la figura B, vemos representados en el eje de ordenadas los valores de la VD (nivel de ansiedad de los sujetos), y en el eje de abscisas los valores de la VI2 (administración de un tratamiento farmacológico), representados en función de los niveles de la VI1 (administración de un programa de ejercicio físico regular).

En relación a la gráfica A, tendríamos que preguntarnos si el efecto que tiene el ejercicio sobre el nivel de ansiedad depende de si administra fluoxetina o placebo. Tal como podemos observar, el efecto de la VI1 sobre la VD cuando se administra fluoxetina es de 40, y cuando se administra el placebo también es de 40. En la gráfica B, tendríamos que preguntarnos si el efecto del tratamiento farmacológico sobre el nivel de ansiedad depende de si la persona lleva a cabo el programa de ejercicio regular o no lo lleva a cabo. Tal como podemos observar, el efecto de la VI2 sobre la VD cuando se administra el programa de ejercicio es de 80, y cuando no se lleva a cabo también es de 80. En ambas gráficas, las líneas son paralelas. Esto nos indica que no hay interacción entre las VI. Dicho de otro modo, no se modifica el efecto de una VI al pasar de un nivel a otro de la otra VI. Si se hubiese modificado este efecto, diríamos que hay interacción y que el efecto de una VI depende de los niveles que toma la otra VI.

En un diseño factorial surgen dos preguntas esenciales:

1)¿Qué información puedo extraer de un diseño factorial?

2)De esta información, ¿cuál será útil a la hora de formular conclusiones?

La información que podemos extraer de un diseño factorial la podemos agrupar en dos bloques claramente diferenciados:

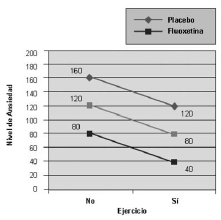

•Los efectos principales: se trata del efecto global de una VI sin tener presente (independientemente) los niveles de otra VI. Hay un efecto principal por cada VI.

•Los efectos simples: se trata del efecto de una VI dentro de los niveles de otra VI (fijando sus niveles). Hay un efecto simple por cada VI dentro de cada nivel de la otra VI.

Los efectos principales en un diseño factorial nos informan de la acción de una VI sobre la VD cuando prescindimos de los niveles de la/s otra/s VI con la/s que se encuentra combinada en el diseño. En este caso, la VI1 actúa de la misma forma, ya se combine con un nivel de la VI2, ya se combine con otro nivel de la VI2.

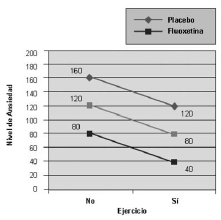

Ejemplo de efectos principales

Se pretende estudiar, de una forma simultánea, el efecto de la administración de un programa de ejercicio físico regular (VI1) y el efecto de la administración de un tratamiento farmacológico (fluoxetina, un inhibidor selectivo de la recaptación de serotonina) (VI2) sobre el nivel de ansiedad (VD). En la figura 27, vemos representados en el eje de ordenadas los valores de la VD (nivel de ansiedad de los sujetos) y en el eje de abscisas los valores de la VI1 (administración de un programa de ejercicio físico regular, representados en función de los niveles de la VI2 (administración de un tratamiento farmacológico). La línea del medio muestra los efectos principales de la administración de un programa de ejercicio físico regular (VI1) sobre los niveles de ansiedad sin tener presente los niveles de la VI2 (administración de un tratamiento farmacológico).

En un diseño factorial, los efectos simples derivan del resultado de descomponer una VI en función de los niveles de otra VI. De esta forma, se estudia cómo actúa la VI1 sobre la VD cuando su acción se divide según los niveles de la VI2. Se estudian, por tanto, los resultados producidos desde el punto de vista de la VI1 condicionados por los niveles de la VI2.

De toda la información analizada en un diseño factorial, solamente interpretaremos una parte en función de si hay o no interacción entre las VI:

•Si hay interacción, interpretaremos los efectos simples.

•Si no hay interacción, interpretaremos los efectos principales.

En definitiva, se detecta interacción en los resultados cuando los patrones de los efectos simples de una VI no son iguales. De esta forma, hablamos de la modificación de la acción de una VI sobre la VD, asociada al nivel de otra VI con la que se combina. Los efectos de VI1 sobre la VD se ven afectados por la presencia de VI2.

Figura 26. Ejemplo de efectos principales.

Análisis de la interacción de dos variables

Imaginemos que queremos estudiar el efecto que tienen dos variables (VI1 –con dos niveles a y b– y de VI2 –con dos niveles a y b–) sobre una VD. Para ello, decidimos estudiarlas de forma simultánea mediante un diseño factorial, combinando los niveles de estas variables. Supongamos que el efecto de la variable VI1 sobre la VD, cuando el nivel de la VI2 es a, es diferente a cuando el nivel de la VI2 es b. En este caso, podemos hablar de una interacción entre las variables, ya que se modifica el efecto de la VI al pasar de un nivel a otro de la VI2.

Figura 27. Análisis de la interacción de dos variables.

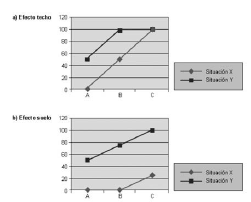

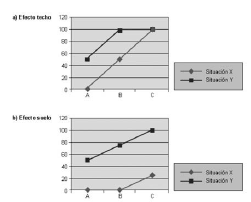

En algunas ocasiones, cuando se analizan gráficamente de manera simultánea dos variables, podemos llegar a la conclusión de que existe una interacción entre ellas. No obstante, puede tratarse de una falsa interacción:

•Efecto techo: al estudiar el efecto sobre la VD, a partir de un determinado valor no se pueden obtener valores más elevados.

•Efecto suelo: al estudiar el efecto sobre la VD, a partir de un determinado valor no se pueden obtener valores más bajos.

Análisis de la interacción de dos variables: efecto techo y efecto suelo

Imaginemos que queremos estudiar el efecto que tienen dos variables (VI1 –tratamiento con tres niveles: tratamiento A, tratamiento B y tratamiento C– y VI2 –situación con dos niveles: situación X y situación Y–) sobre una VD. Para ello, decidimos estudiarlas de forma simultánea mediante un diseño factorial, combinando los niveles de estas variables.

En el primer gráfico de la figura 29, se representa el efecto techo y, en en el segundo, el efecto suelo. Imagínese que el instrumento con el que contamos para medir la VD nos da un valor comprendido entre 0 y 100, de tal forma que no podemos obtener medidas por debajo de 0 ni medidas por encima de 100. Tal como podemos apreciar en los dos gráficos, parece que existe una interacción entre las VI. No obstante, en el caso del primer gráfico, una posible explicación sería que, al estudiar el efecto sobre la VD, a partir de 100 no se pueden obtener valores más elevados, manteniéndose constantes aunque se dé un cambio en los niveles de la VI (pasemos del tratamiento B al C).

En el caso del segundo gráfico, podría ser que, al estudiar el efecto sobre la VD, a partir de 0 no se pueden obtener valores más bajos, manteniéndose constantes aunque se dé un cambio en los niveles de la VI (tratamientos A y B).

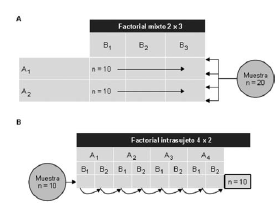

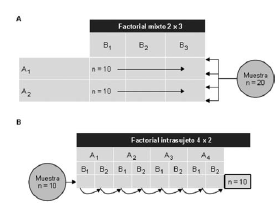

Podemos distinguir tres tipos fundamentales de diseños factoriales en fun ción de las estrategias de comparación utilizadas para las VI:

Figura 28. Efecto techo y efecto suelo.

1)Diseño intersujeto: todas las VI utilizan una estrategia de comparación intersujeto.

2)Diseño intrasujeto: todas las VI utilizan una estrategia de comparación intrasujeto.

3)Diseño mixto: en el diseño, se combinan VI que utilizan una estrategia de comparación intersujeto y VI que utilizan una estrategia de comparación intrasujeto.

Figura 29. Esquema de los diseños experimentales en función del número de variables dependientes, el número de variables independientes, la estrategia de comparación utilizada y el procedimiento de aleatorización implementado. En negrita, pueden verse los diseños fundamentales factoriales. (Reproducida de Portell, Vives i Boixadós (2010). Mètodes, Dissenys i Tècniques d’Investigació. Col·lecció d’esquemes. Bellaterra: UAB.

Ejemplo de tres tipos de diseños factoriales: intersujeto, intrasujeto y mixto Esquema de tres tipos de diseños: (A) diseño factorial intersujeto (2 x 3), (B) diseño factorial intrasujeto (2 x 3) y (C) diseño factorial mixto 2 x 3, intrasujeto en el segundo factor. Imaginemos que queremos estudiar el efecto que tienen dos variables (VI1 –tratamiento farmacológico con tres niveles: fluoxetina, venlafaxina y buspirona– y VI2 –administración de un programa de ejercicio físico con dos niveles: SÍ y NO–) sobre una VD (nivel de ansiedad).

Figura 30. Ejemplo de tres tipos de diseños factoriales.

Para ello, decidimos estudiarlas de forma simultánea mediante un diseño factorial, combinando los niveles de estas variables. Obsérvese las diferencias en cuanto a las condiciones experimentales y a los grupos diferentes de sujetos utilizados en función del tipo del diseño factorial. En el primer caso tendremos 6 grupos que pasarán por condiciones experimentales diferentes. En el segundo caso, 1 grupo (ya que los sujetospasan por todas las condiciones experimentales). En el último caso, tendremos 2 grupos que pasarán por condiciones experimentales (ya que en el caso del tratamiento farmacológico, los sujetos recibirán todos los tratamientos en 3 períodos diferentes). ).

Ejemplo de dos tipos de diseños factoriales: mixto e intrasujeto

Diseño A: imagínese que, en un diseño factorial 2 x 3, la primera VI sigue una estrategia de comparación intersujeto, y la segunda una estrategia de comparación intrasujeto. Si en cada condición experimental quisiéramos disponer de 10 datos diferentes, ¿con cuántos sujetos deberíamos contar?

Diseño B: imagínese que, en un diseño factorial 4 x 2, las dos variables siguen una estrategia de comparación intrasujeto. Si en cada condición experimental quisiéramos disponer de 10 datos diferentes, ¿con cuántos sujetos deberíamos contar?

Figura 31. Ejemplo de dos tipos de diseños factoriales: mixto e intrasujeto.

3.6.Metodología cuasi-experimental

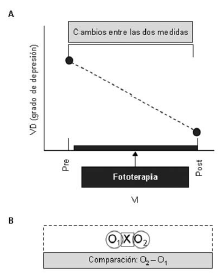

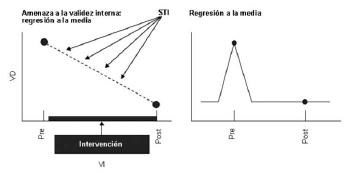

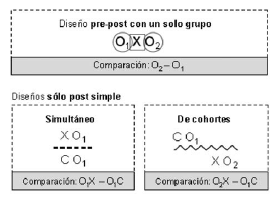

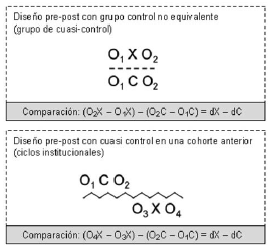

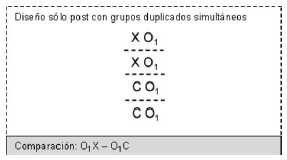

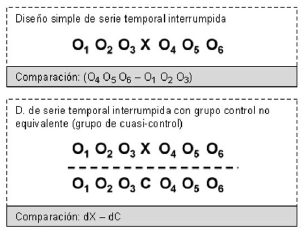

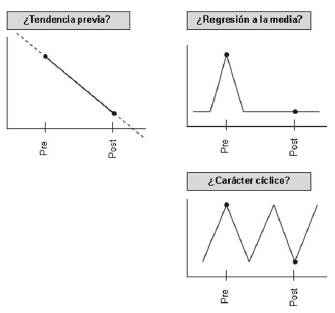

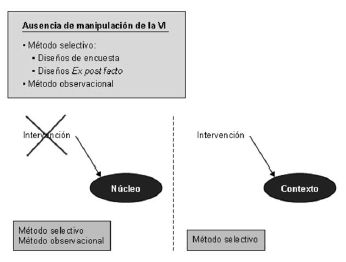

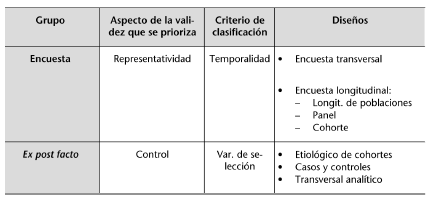

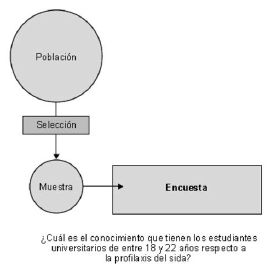

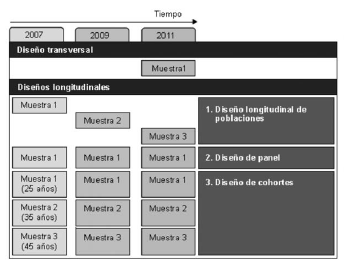

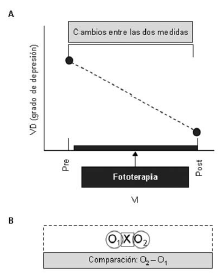

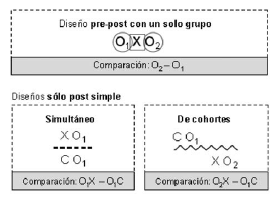

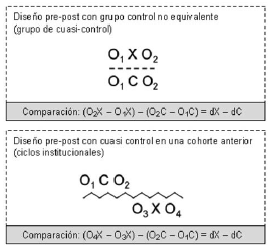

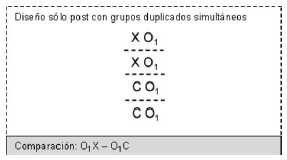

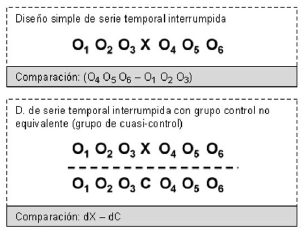

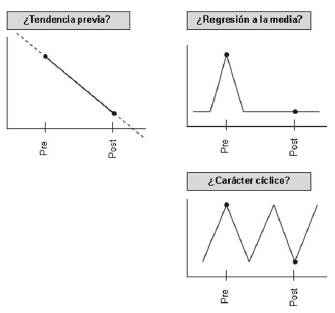

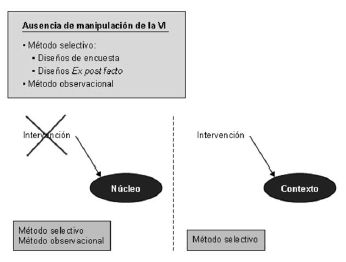

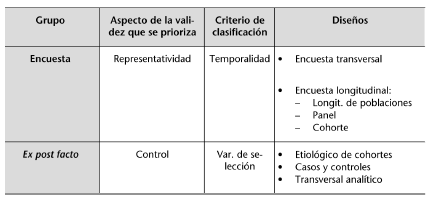

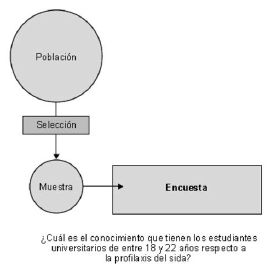

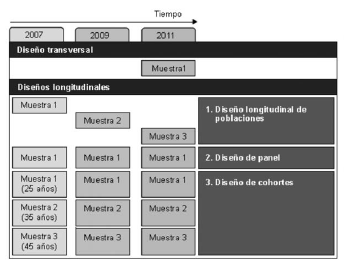

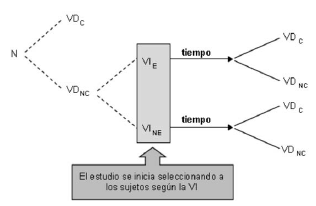

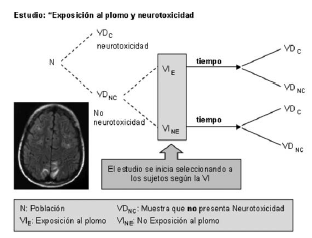

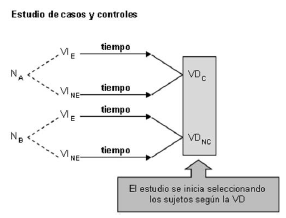

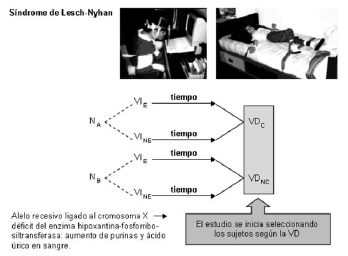

En ocasiones, a pesar de que la VI sea una condición manipulada, el investigador no puede establecer los mínimos controles en lo que se refiere a la utilización de un procedimiento probadamente aleatorio: asignación aleatoria sin restricciones, bloqueo o contrabalanceo. En estos casos, se incumple una de las características del diseño experimental: el uso de la aleatorización.