2

EL VUELO 173 DE UNITED AIRLINES

I

El vuelo 173 de United Airlines despegó del aeropuerto internacional JFK de Nueva York la tarde del 28 de diciembre de 1978 con destino a Portland, Oregón. El cielo estaba despejado y las condiciones de vuelo eran prácticamente perfectas.31 Malburn McBroom, un hombre de cincuenta y dos años, con el cabello plateado, era el comandante. Veterano de la Segunda Guerra Mundial, tenía más de veinticinco años de experiencia y vivía con su mujer en Boyd Lake, Colorado. La ambición de convertirse en piloto surgió cuando de niño vio las acrobacias de los aviones mientras caminaba con su madre. «De mayor pilotaré aviones, mamá», dijo.

Rodrick Beebe, un hombre de cuarenta y cinco años, que llevaba trabajando con United Airlines desde hacía trece años y tenía más de cinco mil horas de vuelo, era el copiloto de McBroom. La tercera persona en la cabina era el ingeniero de vuelo Forrest Mendenhall, de cuarenta y un años, once de los cuales había estado trabajando con la aerolínea. Tenía tres mil novecientas horas de experiencia de vuelo. Los pasajeros estaban en buenas manos.

Después de una breve escala en Denver, el United Airlines 173 despegó hacia Portland a las 14.47. Habían pasado tres días desde las Navidades y la mayoría de los 181 pasajeros volvían a casa después de las vacaciones. En la cabina de mando la tripulación charlaba animadamente mientras el avión alcanzaba la altura de crucero. La duración estimada del vuelo era de 2 horas y 26 minutos.

Hacia las 17.10, cuando el avión obtuvo el permiso del Control de Tráfico Aéreo (CTA) de Portland para descender, McBroom accionó la palanca para abrir el tren de aterrizaje. Normalmente, después de esto las ruedas debían desplegarse suavemente y debía oírse un click cuando se encajaran en su posición final. No obstante, aquella vez se oyó un batacazo que resonó en todo el avión y al que siguió un temblor.

En la cabina de pasajeros la gente empezó a mirarse con ansiedad y a especular sobre el origen del ruido. En la cabina de mando la tripulación también estaba intranquila. ¿El tren de aterrizaje se había desplegado bien? Si era así, ¿qué había ocasionado aquel golpetazo? Una de las luces que debía de haberse encendido si el tren de aterrizaje hubiera estado bien colocado permanecía apagada. ¿Qué significaba aquello?

El capitán no tenía otra opción. Contactó por radio con el Control de Tráfico Aéreo y pidió un tiempo adicional para resolver el problema. El centro de control de Portland respondió de inmediato y aconsejó al United Airlines 173 que «virara a la izquierda hacia uno cero cero». Habían colocado el avión en un patrón de espera hacia el sur del aeropuerto, sobre los suburbios de Portland.

El personal hizo varias comprobaciones. No podían ver la parte inferior del avión para determinar si el tren de aterrizaje estaba en su lugar, así que hicieron algunas verificaciones sustitutivas. Mandaron al ingeniero de vuelo que fuera a la cabina de pasajeros para cerciorarse de si el par de pernos, que sobresalían de las puntas de las alas cuando se desplegaba el tren de aterrizaje, eran visibles. Ahí estaban. También contactaron con el Centro de Control de Mantenimiento de la Línea de Sistemas de United Airlines en San Francisco, California. Todo parecía indicar que el tren de aterrizaje se había desplegado correctamente.

No obstante, el capitán seguía preocupado. No podía tener la certeza de que todo estuviera en orden. Sabía que tomar tierra sin el tren de aterrizaje desplegado comportaba un riesgo alto. Las estadísticas afirmaban que intentar aterrizar sin las ruedas desplegadas no solía acarrear muertes, pero seguía siendo peligroso. McBroom, un piloto responsable, quería estar seguro.

Mientras el avión volaba sobre Portland trató de buscar una respuesta. Se preguntaba por qué una de las luces del tren de aterrizaje no se había puesto en verde. Pensó en cómo hacer una comprobación del cableado y no dejó de buscar otras formas de resolver el problema.

Sin embargo, a este se le sumó otro. Al principio no supuso un inconveniente inmediato, pero a medida que el United Airlines 173 continuaba volando en el patrón de espera, se hizo cada vez más real. Al despegar de Denver, el avión tenía 5.500 litros de combustible, más que suficiente para llegar a su destino. Pero un DC8 consume unos 25 litros por minuto, así que no podían seguir trazando círculos indefinidamente. En algún momento, McBroom tendría que aterrizar.

A las 17.46, hora local, el nivel de combustible cayó a 5 en el indicador. La situación seguía bajo control, pero el margen de error cada vez era menor porque el tiempo no dejaba de correr. El ingeniero de vuelo empezó a ponerse nervioso. Informó al piloto de que las reservas se estaban acabando, como marcaba la luz intermitente de la bomba de combustible. En la transcripción de la grabación de la cabina se podía notar cómo crecía la angustia.

Pero McBroom no reaccionó como esperaba el ingeniero. Y el piloto era quien está a cargo del vuelo, el principal responsable de los 189 pasajeros y del personal. Estaban bajo su protección. Conocía los riesgos de aterrizar sin el tren de aterrizaje. No iba a permitirlo de ninguna manera. Tenía que saber cuál era el problema, tenía que estar seguro.

Siguió concentrado en el tren de aterrizaje. ¿Se había desplegado? ¿Había otra forma de comprobarlo? ¿Qué más podían hacer?

A las 17.50 el ingeniero Mendenhall intentó advertir de nuevo al comandante de que las reservas de combustible se estaban terminando. Este respondió que todavía tenían «quince minutos» de combustible en el tanque, pero estaba equivocado. Parecía haber perdido la noción del tiempo. «¿Quince minutos?», contestó el ingeniero con un tono de incredulidad. «No es suficiente… En quince minutos no nos quedará ni una gota de combustible.»

El tanque de combustible se iba vaciando con cada segundo que pasaba. El patrón de espera se había convertido en una catástrofe potencial, no solo para los pasajeros, sino también para todos los habitantes del sur de Portland. Un avión de 90 toneladas sobrevolaba la ciudad y se estaba quedando sin combustible.

El copiloto y el ingeniero no podían comprender por qué el piloto no se dirigía directamente hacia el aeropuerto. El mayor peligro en aquel momento era quedarse sin combustible. El tren de aterrizaje ya no importaba. Pero McBroom era la persona con más autoridad. Era el jefe, el más veterano, quien tenía mayor experiencia. Lo llamaban «señor».

A las 18.06 había tan poco combustible que el motor número cuatro se apagó. «Me parece que acabamos de perder el número cuatro, señor, creo que…» Treinta segundos después repitió la advertencia. «Señor, vamos a perder un motor.»

Incluso en ese momento el piloto parecía no darse cuenta de la situación catastrófica en la que se encontraban. Su noción del tiempo había desaparecido. «¿Por qué?», preguntó, sin creerse aún que hubieran podido perder un motor. «Combustible», respondió con énfasis el ingeniero.

El United Airlines 173 podía aterrizar perfectamente. El tren de aterrizaje, como se supo más tarde, se había desplegado y era seguro. Pero, aunque no hubiera sido así, un piloto experimentado podía haber aterrizado sin causar ninguna muerte. La noche tenía una visibilidad perfecta y, después de abortar el primer aterrizaje, el aeropuerto había estado a la vista continuamente.

Pero en aquel momento ya estaban a 13 kilómetros de la pista de aterrizaje, sobrevolando una gran ciudad, y el combustible había desaparecido. El personal de vuelo se aterrorizó.

Era demasiado tarde. Cuando el resto de los motores se apagó, desapareció toda esperanza. El avión perdía altura a una velocidad de 1.000 metros por minuto y no iban a lograr llegar al aeropuerto.

McBroom aguzó la vista buscando desesperadamente un campo o un espacio abierto entre la maraña de casas y bloques de apartamentos que se extendían por la planicie. Incluso en aquel momento no comprendía lo que había pasado. ¿El combustible se había desvanecido en el éter? ¿Qué había ocurrido con el tiempo?

Los últimos momentos de la transcripción muestran su desesperación mientras el avión iba cayendo sobre los suburbios de Portland.

1813:38 COMANDANTE: Se nos van todos [es decir, se han apagado los motores]

1813:41 COMANDANTE: No llegamos a Troutdale [otro aeropuerto de Portland]

1813:43 COPILOTO: No llegamos a ninguna parte

1813:46 COMANDANTE: De acuerdo, manda un SOS

1813:50 COPILOTO (a la torre de control): Torre de Portland, United uno siete tres, SOS, los motores se han apagado, estamos cayendo, no podremos llegar al aeropuerto

1813:58 TORRE: United uno…

1814:35 (impacto con unas líneas de transmisión)

(final de la cinta)

Hemos escogido el vuelo United Airlines 173 como paradigma para estudiar los sistemas de aviación por dos razones. En primer lugar, fue un punto de inflexión en la seguridad aeronáutica. Es algo aceptado de manera mayoritaria. Pero, para nuestro propósito, tiene un significado adicional: refleja, de manera intrigante, la tragedia de Emily Bromiley. Aunque un accidente tuvo lugar en el cielo y el otro en un quirófano, comparten una misma señal.

Incluso con un análisis somero las similitudes son sorprendentes. Igual que el comandante McBroom, que se obsesionó con el problema del tren de aterrizaje, el doctor Anderton se obsesionó tratando de acceder a la vía respiratoria por la boca. Su percepción se había estrechado. McBroom no fue capaz de darse cuenta de que se acababa el combustible; los médicos de Elaine Bromiley no se percataron de que le faltaba oxígeno. Mientras McBroom intentaba resolver el problema del tren de aterrizaje y los médicos trataban de colocar el tubo endotraqueal en la vía respiratoria, ninguno advirtió cuál era la verdadera catástrofe.

Igual que el ingeniero de vuelo Mendenhall, que avisó al comandante, pero no obtuvo respuesta, Jane, la enfermera, alertó al doctor Anderton. Ambos se expresaron de manera clara, pero se mordieron la lengua para no exponer sus preocupaciones más explícitamente y les intimidó la estructura jerárquica. La presión social y la inhibición que provoca la autoridad desarticularon por completo un trabajo en equipo efectivo.

Pero lo que nos importa a nosotros no son las similitudes entre los dos accidentes, sino lo que los diferencia: la reacción. Hemos comprobado que en la sanidad lo que prima son las evasivas. Se describen los accidentes como «casos únicos», o como «cosas que pasan». Los médicos afirman: «Hicimos todo lo que pudimos». Esta es la respuesta más común al fracaso que se da hoy en día.

En la aviación, en cambio, es totalmente diferente: aprender del fracaso es la médula del sistema.

Todos los aviones llevan dos cajas negras, una de la cuales registra todas las instrucciones que se mandan a los sistemas electrónicos de a bordo. La otra es una grabadora de voz de la cabina de mando, la cual permite a los investigadores comprender el razonamiento de los pilotos en los momentos previos al accidente. En lugar de ocultar el fracaso, o soslayarlo, la aviación tiene un sistema en el que el fracaso es una fuente de datos.

En caso de accidente, los investigadores, que son independientes de las aerolíneas, el sindicato de pilotos y los reguladores tienen vía libre para analizar los restos y examinar todas las pruebas. No se estigmatizan los errores, sino que se consideran una oportunidad para aprender. Las partes interesadas no tienen razón para no cooperar, puesto que las pruebas que recoja la investigación no se admiten en los procedimientos judiciales. Esto aumenta las probabilidades de que se aclaren todos los hechos.

Al acabar la investigación el informe está disponible para todos. Las aerolíneas tienen la responsabilidad legal de aplicar las recomendaciones. Cualquier piloto del mundo tiene acceso a los datos. De este modo, todos pueden aprender de los errores, no solo un equipo, aerolínea o país. Esto multiplica el potencial de aprendizaje. Eleanor Roosevelt lo expresó de la siguiente manera: «Aprende de los errores de los demás. No hay vida suficiente para que puedas cometerlos todos tú mismo».

Y no solo los accidentes pueden enseñar. También de los errores «leves» se puede aprender. Cuando un piloto está a punto de colisionar con otro avión, o cuando ha volado a una altitud equivocada, elabora un informe. Mientras lo hagan diez días después del incidente, los pilotos tienen inmunidad. Muchos aviones también van equipados con sistemas de datos que envían informes de manera automática cuando se exceden algunos parámetros. De nuevo, estos informes se agregan a los ficheros y lo hacen de manera anónima.*

Por ejemplo, en 2005 aparecieron varios informes en un periodo de tiempo corto que alertaron a los investigadores sobre un problema en las inmediaciones del aeropuerto de Lexington, Kentucky. Las autoridades locales habían montado un gran mural en una extensa parcela de tierra para embellecerla. En la parte superior, instalaron una serie de lámparas para iluminarlo.

Pero estas luces estaban haciendo estragos en la percepción de los pilotos, porque las confundían con las luces de la pista de aterrizaje. La cuestión es que empezaban a descender mucho antes. Por fortuna, nadie tuvo un accidente gracias a los informes anónimos que pusieron sobre la mesa el problema antes de que se tuvieran que lamentar las consecuencias. Shawn Pruchnicki, un experto en seguridad aeronáutica que formó parte de la comisión, me dijo: «En una sola semana tuvimos un montón de informes. Nos dimos cuenta enseguida de que había un problema y que teníamos que actuar».

Pocos minutos después se envió un correo electrónico a todos los vuelos que debían aterrizar en Lexington advirtiéndoles de la distracción potencial que había en las inmediaciones. Unos días después retiraron el mural y las luces (lo cual habría ocurrido antes si el terreno hubiera estado bajo jurisdicción del aeropuerto). De este modo, se evitaron futuros accidentes.

Hoy en día las aerolíneas más importantes han ido todavía más lejos al crear un supervisor en tiempo real de decenas de miles de parámetros, como errores de altitud y exceso de peso, de modo que se pueden comparar continuamente el comportamiento de los aviones para diagnosticar patrones problemáticos. Según la Royal Aeronautical Society: «Es la manera más efectiva de mejorar ostensiblemente la seguridad de los vuelos».32 El objetivo actual es aumentar la cantidad de datos en tiempo real para acabar sustituyendo las cajas negras, puesto que toda la información ya se habrá transmitido a la base de datos central.

Por lo tanto, la aviación se toma en serio los fracasos. Cualquier dato que indique que los procedimientos son defectuosos, o que el diseño de la cabina de mando es mejorable, o que no se ha formado adecuadamente a los pilotos, se estudia minuciosamente. Son la base para que la industria mejore la seguridad y los individuos no teman reconocer sus errores porque saben lo valiosos que son.

II

¿Qué significó todo esto para el vuelo 173 de United Airlines? Pocos minutos después del accidente la Junta Nacional de Seguridad en el Transporte asignó un equipo de investigación, en el que se encontraban Alan Diehl, un psicólogo, y Dennis Grossi, un investigador experimentado. La mañana siguiente llegaron a los suburbios de Portland para examinar las pruebas a fondo.

Una muestra de la extraordinaria habilidad de McBroom es que mantuvo el avión bajo control durante todo el tiempo posible. Mientras caía, avistó una zona entre las casas y los bloques de apartamentos que parecía un espacio abierto, posiblemente un campo, y se dirigió hacia él. Al acercarse, se dio cuenta de que era, de hecho, una zona arbolada. Trató de esquivar los árboles, colisionó con uno, luego topó con una casa y acabó cayendo encima de otra, al otro lado de la calle.

La primera casa quedó destruida. Piezas del ala izquierda del avión se hallaron más tarde en otras zonas del suburbio. La parte inferior izquierda del fuselaje, entre las filas cuarta y sexta de los pasajeros, estaba completamente pulverizada. Milagrosamente, no había cadáveres en el suelo. Murieron ocho pasajeros y dos miembros de la tripulación. Uno de ellos, el ingeniero de vuelo Mendenhall, que intentó en vano advertir al comandante de la falta de combustible. McBroom sobrevivió a pesar de romperse una pierna, un hombro y algunas costillas.

Cuando los investigadores estudiaron las pruebas del vuelo 173 de United Airlines, pudieron observar un patrón. No se trataba solo de lo que habían descubierto entre los restos del accidente, sino la comparación con otros accidentes previos. Un año antes, un DC8 había tenido un accidente en circunstancias casi idénticas. El avión, con destino a San Francisco desde Chicago, inició un patrón de espera por la noche debido a un problema con el tren de aterrizaje, siguió volando con la esperanza de arreglarlo y acabó estrellándose contra una montaña sin dejar ningún superviviente.33

Pocos años antes, el vuelo 401 de Eastern Airlines sufrió un accidente similar cuando trataba de aterrizar en el aeropuerto internacional de Miami. Una de las luces de la cabina de mando no se iluminó y la tripulación creyó que el tren de aterrizaje no se había desplegado. Cuando intentaron resolver el problema (resultó ser una bombilla fundida), no se dieron cuenta de que estaban perdiendo altitud a pesar de las alertas del sistema de seguridad. Se estrelló en los Everglades y murieron 101 personas.34

En todos estos casos, los investigadores observaron que la tripulación había perdido la noción del tiempo. Parece ser que la atención es un recurso escaso: si te concentras en una cosa, pierdes de vista las demás.

Esto se pudo comprobar en un experimento en que se asignaban diversas tareas a unos estudiantes. Una de ellas era fácil: leer en voz alta. Otra era más complicada: definir palabras difíciles. Después de finalizarlas, les pidieron que calcularan cuánto tiempo había pasado. Los que habían hecho la tarea fácil se acercaron más al tiempo exacto, mientras que el otro grupo subestimó los minutos pasados en un cuarenta por ciento. El tiempo había volado.

Ahora piensa en McBroom. No solo tenía que concentrarse en palabras difíciles, sino que además debía resolver el problema del tren de aterrizaje, escuchar al copiloto y al ingeniero de vuelo y prever un aterrizaje en condiciones de emergencia. Recuerda también a los médicos de Elaine Bromiley. Estaban absortos intentado entubarla, intentado desesperadamente salvar su vida. Perdieron la noción del tiempo no porque no estuvieran lo bastante concentrados, sino porque estaban demasiado concentrados.* En Portland, Diehl se dio cuenta de que otro de los problemas fundamentales tenía que ver con la comunicación. El ingeniero de vuelo Mendenhall vio con claridad que las reservas de combustible se estaban acabando. Se lo insinuó varias veces al comandante y, cuando la situación fue grave, se lo repitió de manera más directa. Diehl, al escuchar de nuevo la grabación, notó el tono alterado del ingeniero. Cuando el peligro era inminente alertó desesperadamente a McBroom, pero no llegó a desafiar su autoridad.

Hoy en día, este es un aspecto bien estudiado en psicología. La jerarquía social inhibe la asertividad. Nos dirigimos a aquellos que representan la autoridad en lo que se llama «lenguaje atenuado». Si hablas con tu jefe, no le dirás: «Tendremos una reunión el lunes por la mañana», sino: «Si está ocupado no se preocupe, pero sería una buena idea que pudiéramos hablar media hora el lunes».35 Esta deferencia tiene sentido en la mayoría de situaciones, pero puede ser nefasta cuando un avión de 90 toneladas se está quedando sin combustible al sobrevolar una gran ciudad.

Existe el mismo factor jerárquico en los quirófanos. Jane, la enfermera, se percató de la solución. Fue a buscar el kit de traqueotomía. ¿Tenía que haber alzado más la voz? ¿No le dio la suficiente importancia? En situaciones de seguridad críticas, esta es precisamente la forma equivocada de pensar. Recuerda que el ingeniero de vuelo Mendenhall pagó con su vida el no imponer su punto de vista. El problema no fue una falta de diligencia o de motivación, sino un sistema insensible a las limitaciones de la psicología humana.

Ahora comparemos las perspectivas de primera y tercera persona. A los médicos del hospital cerca de North Marston el accidente les pareció un «caso único». Después de todo, no fueron conscientes de que se habían pasado ocho minutos intentando vanamente entubar a Elaine. Según su percepción, habían dedicado solo una porción de ese tiempo. Su noción subjetiva del tiempo se había deformado con el pánico. El problema, según su opinión, era del paciente: murió mucho más rápido de lo que podían prever. Si no había investigación alguna, ¿cómo podían saber en qué se habían equivocado?

La historia del vuelo 173 de United Airlines es casi idéntica. Cuando el investigador Diehl, pocos días después del accidente, fue a visitar a McBroom al hospital, el comandante le dijo que las reservas de combustible se habían agotado «increíblemente rápido». Sugirió la posibilidad de que hubiera una pérdida en el tanque. Desde su perspectiva, siendo consciente de cómo se había esfumado el tiempo durante la crisis, se trataba de una observación racional. Para él, que se hubiera acabado el combustible sencillamente no tenía sentido.

Pero Diehl y su equipo se tomaron la molestia de revisar dos veces los datos de la caja negra. Comprobaron las reservas cuando el avión adoptó el patrón de espera, verificaron a qué velocidad consumía combustible el DC8 y luego observaron en qué momento exactamente se había quedado vacío. Todo encajaba. El avión no había perdido combustible con mayor rapidez de la habitual. La pérdida no estaba en el tanque, sino en la noción del tiempo de McBroom.

Solo gracias a una investigación independiente la verdad salió a la luz. En la sanidad nadie percibió el problema subyacente porque, desde la perspectiva de la primera persona, no existía. Esta es una de las maneras en que se perpetúan los ciclos cerrados: cuando no nos preguntamos por los errores, a veces ni siquiera sabemos que hemos cometido uno (aunque sospechemos que podamos haberlo hecho).

Cuando Diehl y el resto de investigadores publicaron el informe del vuelo 173 de United Airlines en junio de 1979, fue un hito en la aviación. En la página trece, con el lenguaje aséptico habitual de estos informes, hacía la siguiente recomendación: «Enviar un boletín a todos los inspectores de operaciones aéreos para que urjan a sus operadores asignados a que formen a las tripulaciones de vuelo con los principios de gestión de recursos del puente de mando, con un énfasis particular en el mérito de la gestión participativa para los comandantes y una formación en asertividad para el resto de la tripulación en la cabina de mando».

Pocas semanas después la NASA organizó una junta para investigar los beneficios de un nuevo tipo de formación: la Gestión de Recursos de la Tripulación. El punto principal fue la comunicación. A los copilotos les enseñaron procedimientos de asertividad. El acrónimo que se utiliza para mejorar la asertividad de los miembros de la tripulación es P.A.C.E, por sus siglas en inglés: Probe (Sondea), Alert (Alerta), Challenge (Desafía), Emergency (Emergencia).* Los comandantes, que durante años se habían considerado las personas al mando, tuvieron que aprender a escuchar, aceptar las instrucciones y aclarar las ambigüedades. El problema de la percepción del tiempo se abordó con una división de responsabilidades más estructurada.

Las listas de verificación, que ya se utilizaban, se ampliaron y se mejoraron. Se habían implementado para evitar descuidos en situaciones complejas. Pero también suavizan la jerarquía. Cuando el comandante y el copiloto hablan entre ellos, se presentan y repasan la lista de verificación, se abren canales de comunicación. Hay más posibilidades de que el oficial de menor rango dé su opinión en caso de emergencia, lo cual resuelve el llamado «problema de activación».

Varias versiones de los nuevos métodos de formación se pusieron a prueba inmediatamente con los simuladores. En cada fase se comprobaba si funcionaban las nuevas ideas, se examinaban con rigor y se perfilaban sus límites. Las propuestas más efectivas se integraron rápidamente en todas las aerolíneas del mundo. Después de una serie de accidentes terribles durante la década de 1970, el índice de siniestros empezó a caer.

«El accidente del vuelo 173 de United Airlines fue traumático, pero también supuso un gran paso adelante —afirma el experto en seguridad aeronáutica Shawn Pruchnicki—. Se sigue considerando un punto de inflexión el momento en que comprendimos que los “errores humanos” a menudo están causados por sistemas mal diseñados. Cambió la forma de pensar de la industria.»

Murieron diez personas en el vuelo 173 de United Airlines, pero todo lo que se aprendió salvó miles de vidas más.

Esto, por lo tanto, es lo que llamaremos «Pensamiento Caja Negra».* Para aquellas organizaciones que no pertenecen al sector de la aviación no se trata de crear literalmente una caja negra, sino de tener la voluntad y la tenacidad de investigar las razones que a menudo provocan un fracaso, pero a las que rara vez prestamos atención. Se trata de crear un sistema y una cultura que permita a las organizaciones aprender de los errores en lugar de sentirse amenazadas por ellos.

El fracaso nos da la oportunidad de aprender por muchas razones: en muchos aspectos es la frustración de una expectativa.36 De alguna forma nos enseña que el mundo no es como lo imaginábamos. La muerte de Elaine Bromiley, por ejemplo, reveló que los procedimientos en las operaciones no tienen en cuenta las limitaciones de la psicología humana. El desastre del vuelo 173 de United Airlines puso sobre la mesa problemas similares en la cabina de vuelo.

Estos fracasos son inevitables porque el mundo es complejo y nunca comprendemos todas sus sutilezas. El modelo, como nos recuerdan los científicos sociales, no es el sistema. El fracaso, por lo tanto, es una señal. Arroja luz sobre un aspecto del mundo que se escapa a nuestro entendimiento y nos proporciona pistas esenciales para actualizar los modelos, las estrategias y las conductas. Desde esta perspectiva, la pregunta que suele hacerse después de un acontecimiento adverso, es decir, «¿podemos permitirnos el tiempo para investigar este fracaso?» debería ser al revés. La pregunta pertinente es: «¿podemos permitirnos no hacerlo?»

Lo cual nos lleva a otra conclusión importante. A veces se afirma que la diferencia esencial entre la aviación y la sanidad son los recursos disponibles: dado que la aeronáutica tiene más dinero puede llevar a cabo investigaciones y aprender de los errores. Si la sanidad tuviera más recursos, ¿no haría lo mismo? No obstante, ahora sabemos que no es así. Puede que la sanidad no tenga suficientes recursos, pero se ahorraría dinero si aprendiera de los errores. El coste de los errores médicos se ha estimado, de forma conservadora, en más de 17.000 millones de dólares solo en Estados Unidos.37 En marzo de 2015, la Autoridad de Litigación del Servicio de Sanidad Nacional asignó 26.100 millones de libras para cubrir las responsabilidades por negligencia. Aprender de los errores no saquea los recursos, sino que es la forma más efectiva de conservarlos y de salvar vidas.*

Los psicólogos suelen diferenciar los errores de los que sabemos la solución de aquellos que no la sabemos. Un error de medicación, por ejemplo, pertenece al primer tipo: la enfermera sabía que debía administrar el medicamento A pero, sin querer, administró el medicamento B, tal vez por confundir las etiquetas debido a una falta de tiempo.

Pero a veces los errores se cometen conscientemente como parte de un proceso de descubrimiento. Las empresas farmacológicas prueban diferentes combinaciones de productos químicos para comprobar cuáles son eficaces y cuáles no. Nadie sabe previamente qué funcionará y qué no, pero precisamente por esta razón se prueban en muchos experimentos, y fracasan a menudo. Es una parte esencial del proceso.

De forma general, nos centraremos en el primer tipo de fracaso en las páginas iniciales del libro y en el segundo en las finales. Pero la cuestión crucial es que en ambos casos el error es necesario para llegar a descubrir algo. En sectores como la sanidad los errores nos indican qué se debe reformar para evitar errores futuros. En este último caso, los errores nos llevan a descubrir nuevas medicinas.

Una distinción que en cierta forma se solapa es la de los errores que tienen lugar en un entorno experimental y aquellos que tienen lugar en un entorno de acción. Los patinadores sobre hielo, por ejemplo, se caen mucho cuando entrenan. Al exigirse más intentando hacer saltos complicados y cayéndose de vez en cuando en el hielo, mejoran sus habilidades y progresan porque aumentan su capacidad de juzgar y de ser más precisos. Esto es lo que les permite patinar casi sin cometer errores cuando llega el día del campeonato.

En efecto, la práctica consiste en obtener los beneficios de aprender de los errores y reducir los costes. Es mejor caerse al preparar la competición que caerse en la competición misma. Esto también vale para las organizaciones que llevan a cabo pruebas piloto (y en el caso de la aviación y otros sectores en que la seguridad es esencial ponen a prueba sus ideas con simuladores) para aprender antes de implementar nuevas ideas o procedimientos. Cuanto más fracasemos en la práctica, más aprenderemos para tener éxito en el momento en que de verdad sea importante.

Pero, incluso si practicamos diligentemente, en un momento u otro fracasaremos en el mundo real. Y a menudo es en estas circunstancias, cuando el fracaso amenaza más a nuestro ego, que necesitamos aprender más que nunca. La práctica no es un sustituto del aprendizaje de los fracasos en el mundo real, sino que es complementaria. Son, en muchos aspectos, las dos caras de una misma moneda.

Con esto presente, pongamos un último ejemplo del «estilo de investigación caja negra». Se trata de la pérdida de un bombardero durante la Segunda Guerra Mundial del que se ocupó uno de los matemáticos más brillantes del siglo XX: Abraham Wald.

Su análisis no solo fue un momento determinante en el contexto del conflicto, sino también un ejemplo importante en el contexto de este libro. Aprender de acontecimientos adversos puede parecer fácil en retrospectiva. ¿Las lecciones del vuelo 173 United Airlines no son, por ejemplo, obvias? ¿Los datos no las hacían evidentes?

Sin embargo, en el momento de la investigación los datos pueden parecer mucho más ambiguos. Los investigadores con más éxito no solo tienen la voluntad de comprender el accidente, sino la capacidad analítica y la creatividad para extraer lecciones clave. De hecho, muchos expertos en aviación citan la mejora en la calidad y sofisticación de las investigaciones como uno de los acicates más importantes para mejorar la seguridad en los últimos años.38

Pero pocas investigaciones han sido tan ingeniosas como la que llevó a cabo Wald. Su trabajo estuvo clasificado durante décadas, pero hace poco se ha revelado la historia completa y cómo contribuyó a derrotar al nazismo. Por encima de todo, sus investigaciones ponen de relieve que para aprender del fracaso se deben tener en cuenta no solo los datos que pueden verse, sino también aquellos que son invisibles.

III

Abraham Wald, hijo de un panadero judío, nació en Hungría en 1902. Su hermano mayor, Martin, que era un ingeniero cualificado, lo educó en casa. Desde muy pronto sintió un profundo amor por las matemáticas y, desde los catorce años, por la geometría. Según aquellos que lo conocieron, el pequeño Abraham siempre estaba creando y resolviendo rompecabezas.

Wald se fue de su casa en 1927 para estudiar en la Universidad de Viena. Tenía un rostro inquisitivo, cabello oscuro, ojos brillantes y una mente aguda que fue reconocida inmediatamente por los profesores y estudiantes. Un compañero lo expresó del siguiente modo: «Me cautivó su capacidad esplendorosa, su amabilidad y la fuerza extraordinaria con la que se enfrentaba a los problemas».39

En la universidad, Karl Menger, uno de los mejores matemáticos de su generación, invitó a Wald a unirse al Colloquium, un grupo de académicos que se reunían de manera informal para discutir sobre matemáticas y filosofía, y entre quienes estaban personas que luego se convertirían en leyenda, como Kurt Gödel y Alfred Tarski. Wald continuó ampliando sus estudios y escribió una serie de ensayos sobre geometría que Menger calificó de «profundos, hermosos y de una importancia fundamental».40

Pero aun así no pudo obtener un puesto de profesor en Viena: su origen judío lo hacía políticamente imposible. «En aquel tiempo de inquietud económica, que pronto se iba a contagiar a la política, estaba fuera de cuestión lograr un trabajo en la Universidad de Viena, aunque sin duda habría sido tan beneficioso para la institución como para él —escribió más tarde Menger—. Con su modestia característica, Wald me dijo que estaría completamente satisfecho con cualquier intrascendente empleo privado que le permitiera seguir colaborando con el Colloquium matemático.»41

Sin embargo, incluso este papel insignificante sería problemático en una Europa que se encaminaba a la guerra. En 1937, la presencia de Wald en el Colloquium fue criticada por algunos simpatizantes nazis. Un año después, cuando Hitler marchó sobre la capital austríaca, echaron a Wald. Aún se quedó en Viena unas semanas después de la ocupación, pero cuando los nazis intensificaron la persecución de los judíos, Menger, que ya había huido a Estados Unidos, le consiguió un trabajo allí.

Wald era renuente a irse de Viena, una ciudad de la que se había enamorado (en una carta a un amigo, escribió que se había convertido en su «segundo hogar»), pero la decisión de emigrar casi con seguridad le salvó la vida. Ocho de los nueve miembros de su familia murieron a manos de los nazis. Sus padres y sus hermanas fueron gaseados en Auschwitz y su querido hermano mayor, Martin, que le introdujo a las matemáticas, murió prisionero en un campo de trabajo del oeste de Alemania. Wald no supo que habían muerto hasta el final de la guerra.

En Estados Unidos fue un gran alivio poder continuar trabajando como matemático. Logró un puesto en un equipo con un nombre aparentemente banal: Comité de Matemáticas Aplicadas. Empezó a trabajar en un bloque de apartamentos de cuatro pisos pocas calles más allá del centro de Harlem. Resultó ser un punto de inflexión en la guerra.42

El Comité estaba formado por un grupo de matemáticos brillantes. Trabajaban para las fuerzas armadas y debían analizar un amplio abanico de materias, como el patrón más efectivo para el lanzamiento de torpedos o la eficiencia aerodinámica de los misiles. Como afirmó el escritor David McRaney: «Quienes en aquel tiempo entraban en el bloque no tenían ni idea de que, cuatro pisos más arriba, parte de los descubrimientos más importantes de las matemáticas aplicadas estaban inclinando la balanza del conflicto global».43

Gran parte de aquella labor era altamente confidencial y los informes que generaron han estado clasificados durante décadas. Pero en los últimos años los investigadores han empezado a reconstruir la contribución de estos «soldados matemáticos» y han descubierto que fue determinante en el resultado de la guerra. El papel de Wald, que solo ha salido a la luz años después, fue tal vez el más extraordinario de todos.

Los militares le pidieron que les ayudara en una cuestión crucial. Los bombarderos en Europa debían asumir riesgos muy altos. Durante ciertos periodos del conflicto, la probabilidad de que un piloto sobreviviera a una misión era poco más del cincuenta por ciento. Kevin Wilson, historiador militar, describió a estos hombres valientes y excepcionales como si ya fueran «espectros».44

Los jefes militares se dieron cuenta de que necesitaban blindar los aviones para protegerlos de los disparos desde tierra y aire. El problema era que no podían blindar toda la superficie porque entonces serían demasiado pesados para volar y perderían maniobrabilidad. La labor de Wald fue priorizar qué zonas necesitaban más protección.

Disponía de muchos datos con los que trabajar. Las fuerzas aéreas se habían tomado la molestia de examinar los aviones que habían vuelto para determinar los daños y cómo evitarlos. Era un estilo de «conducta caja negra». Analizaban los datos de acontecimientos adversos para mejorar la seguridad de los aviones.

Para alivio de la comandancia de las fuerzas aéreas, el patrón parecía claro. La mayoría de los aviones había sufrido daños en las alas y el fuselaje, pero no recibían impactos en la cabina de mando ni en la cola. Cuantos más informes tenían, más evidente parecía el patrón.

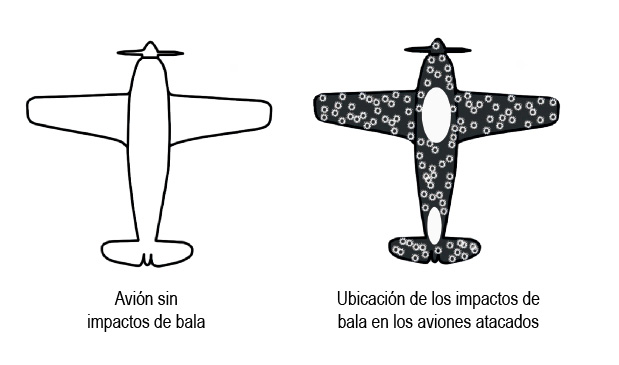

Puedes observar el patrón en el diagrama inferior.

La comandancia militar pergeñó lo que parecía el plan perfecto: blindarían todas las zonas donde había impactos de bala, puesto que era allí donde los aviones necesitaban una protección adicional. Es de puro sentido común. Para quienes dirigían el ejército, era la mejor forma de salvaguardar a sus pilotos del fuego enemigo.

Pero Wald no estaba de acuerdo. Se percató de que los jefes habían pasado por alto datos clave. Solo estaban teniendo en cuenta los aviones que lograban volver, y no aquellos que no habían vuelto (es decir, los que habían caído). Los agujeros de bala sugerían que las zonas cerca de la cabina de mando no necesitaban refuerzo porque nunca recibían impactos. De hecho, los aviones que eran alcanzados en estas zonas se estrellaban porque era su punto más vulnerable.

En efecto, los agujeros de los aviones que volvían representaban las áreas donde el bombardero podía sufrir daños y, aun así, volver sano y salvo. Habían sobrevivido precisamente por no recibir impactos en la cabina o en la cola. El patrón de los agujeros, en lugar de indicar dónde se debía blindar al avión, revelaba las áreas donde no se debía hacer.

Este descubrimiento resultó ser de una importancia capital, no solo para los bombarderos, sino para todos los aspectos de la guerra.

Es un ejemplo fundamental que evidencia dos cuestiones clave. La primera es que si queremos aprender de los accidentes debemos tener en cuenta todos los datos, incluso aquellos que no podemos ver de manera inmediata. Pero también pone de manifiesto que aprender de los errores no siempre es fácil, incluso en términos conceptuales, por no hablar de los emocionales. Son precisos un razonamiento minucioso y una voluntad de ir más allá de las suposiciones superficiales. A menudo, significa sobrepasar los datos obvios para sonsacar las lecciones subyacentes. Y esto es cierto tanto para la aviación como para las empresas, la política y muchas cosas más.

En palabras de Amy Edmondson, de la Facultad de Empresariales de Harvard: «Aprender de los fracasos no es nada fácil. La actitud y las actividades que se requieren para detectar y analizar efectivamente los errores no son habituales en la mayoría de las empresas, y la necesidad de estrategias de aprendizaje específicas para cada contexto se subestima. Las empresas necesitan procesos nuevos y mejores para aprender lecciones que no sean superficiales».45

El análisis de Wald sobre los impactos de bala en los aviones de la Segunda Guerra Mundial salvó la vida de docenas de valientes pilotos. Su informe crucial no se desclasificó hasta julio de 1980, pero hoy en día se puede encontrar fácilmente buscándolo en Google. Se titula: «A Method of Estimating Plane Vulnerability Based on Damage of Survivors» («Un método para estimar la vulnerabilidad de los aviones basado en el daño a los supervivientes»).46

No fue hasta el final de la guerra cuando Wald supo que ocho de sus nueve familiares habían muerto en manos de los nazis. Según aquellos que lo conocieron mejor, nunca superó el dolor de la pérdida. Uno de sus amigos más íntimos, escribió: «Incluso este golpe cruel no le amargó la vida, pero un halo de tristeza le marcó para el resto de sus días».47

Al final de la década de 1940, logró traer a Estados Unidos a su hermano mayor, Hermann, el único miembro de su familia que sobrevivió al Holocausto. Sus amigos recuerdan que supuso un «gran alivio» estar en compañía de él, así como poder continuar trabajando en el departamento de matemáticas de la Universidad de Columbia.

Uno espera que este hombre extraordinario y amable también sintiera satisfacción por el hecho de que sus descubrimientos analíticos desempeñaran un papel crucial para derrotar a la ideología malvada que asesinó a sus seres queridos.

Fue un «pensador caja negra» par excellence.

* Tener conocimiento de los errores leves es de importancia capital también para las empresas. Como afirma Amy Edmondson, profesora de la Facultad de Empresariales de Harvard: «La mayoría de los grandes fracasos tienen causas múltiples, y algunas de ellas están enquistadas en las empresas […]. Los errores leves son las advertencias previas indispensables para evitar fracasos catastróficos en el futuro».

* En muchas circunstancias, concentrarse en lo que haces es la mejor manera de hacerlo bien. El problema aparece cuando esta concentración limita la comprensión global. Una concentración excesiva perjudica el rendimiento y, en el caso de la aviación, la seguridad.

* Podemos ver cómo sería en la práctica aplicado a una situación del mundo real. Esto es lo que Jane, la enfermera en jefe, debería haber dicho si hubiera utilizado esta técnica durante la operación de Elaine Bromiley:

SONDEA: «Doctor, ¿qué otras opciones está considerando si no logramos entubarla?»

ALERTA: «Doctor, el oxígeno ha caído al 40 por ciento y sigue bajando. No podemos insertar el tubo. ¿Traigo el kit de traqueotomía?»

DESAFÍA: «Doctor, o hacemos una traqueotomía ahora o perderemos a la paciente».

EMERGENCIA: «Voy a buscar al equipo de reanimación para hacer la traqueotomía».

* A veces, «caja negra» tiene la connotación de un proceso desconocido y tal vez inescrutable entre una causa y su resultado. Aquí lo utilizamos en un sentido levemente diferente pero relacionado con el registro de datos en la investigación de un accidente.

* Como lo expresó un informe de una comisión parlamentaria británica en 2015: «Los recursos para investigar y aprender cómo mejorar la seguridad clínica ahorrarían gastos innecesarios al reducir el daño evitable a los pacientes».