2.1 Las tres olas de la interactividad

2

En este capítulo presentamos una contextualización del documental interactivo recorriendo los procesos de su aparición y emergencia, analizando algunos de sus precedentes y un periodo muy intenso de experimentación. Para elaborar esta propuesta original, hemos partido de algunas teorías y modelos que a continuación enumeramos y describimos. Inicialmente hemos partido del estudio efectuado por Sandra Gaudenzi14, en el que propone un planteamiento centrado en la descripción de algunos hitos importantes en la evolución del documental interactivo digital. Momentos importantes que, según su punto de vista, coinciden también con cambios importantes en la noción de interactividad. Selecciona a tal fin un conjunto limitado de ejemplos que muestran cómo la evolución de los llamados nuevos medios ha creado nuevas oportunidades y lógicas de representación de la realidad. Gaudenzi propone diferentes modos de interacción para ilustrar las formas interactivas a través de las cuales los autores se comunican con su público mediante el documental interactivo. Para analizar las diferentes lógicas de negociación con la realidad, establece un paralelo entre el modo en que la interactividad se ha entendido y utilizado en los documentales interactivos existentes y las relaciones que se han impuesto entre el autor, el usuario y los medios de comunicación.

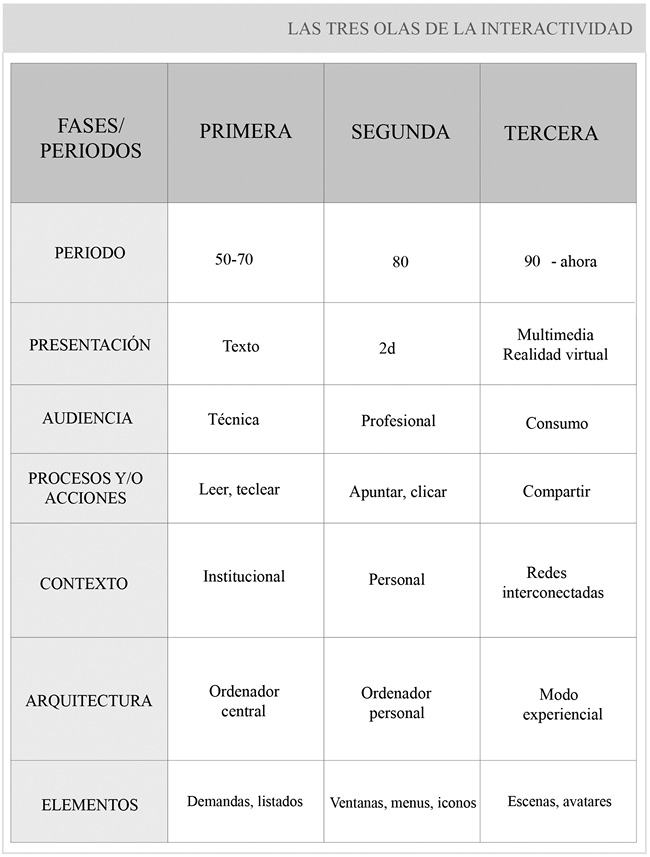

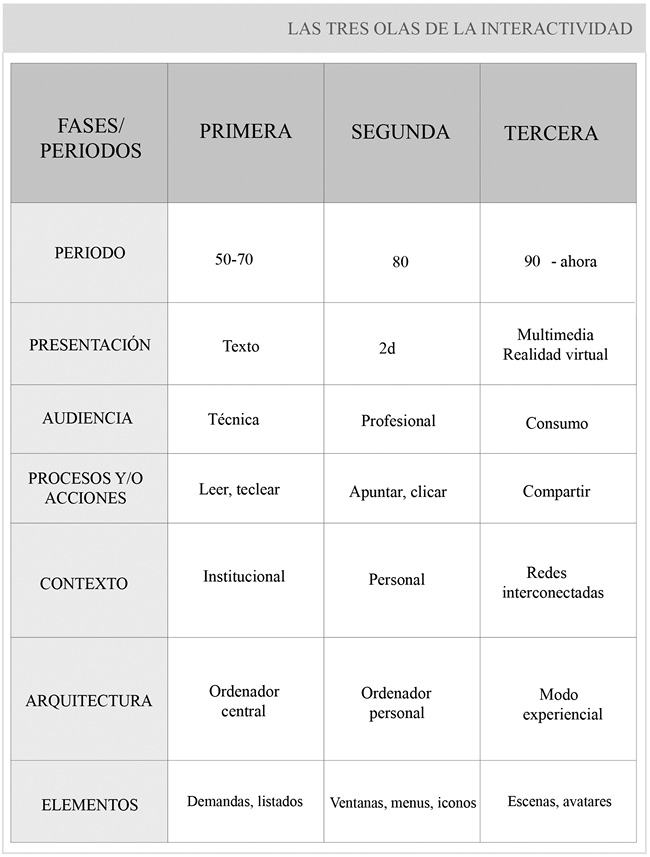

Como regla general, toda la investigación y literatura sobre películas comienza con una referencia a los hermanos Lumière y su cinematógrafo de 1895, pero cuando se trata de documental interactivo, ¿debe comenzar con el invento de los Lumière o bien con la Máquina Analítica de Babbage de 1830, el punto de partida del ordenador moderno? Probablemente las dos cosas, y como plantean Almeida y Alvelos15, podemos utilizar esta cuestión como un pretexto para iniciar un recorrido que nos llevará hasta la posibilidad técnica y narrativa de un nuevo tipo de documental que se establece entre el cine y la interacción: el documental interactivo. Antes de empezar a desglosar su aparición y evolución por etapas, ofrecemos un cuadro sinóptico para ubicar al lector con relación a cómo se ha desarrollado y ha ido evolucionando la interactividad hasta el momento presente, cuestión de especial interés en esta investigación para llegar a comprender en profundidad el objeto de estudio.

2.1 Las tres olas de la interactividad

Para reseguir la historia del documental interactivo, hemos partido de la teoría del doble nacimiento elaborada por André Gaudreault y Philippe Marion (2002 y 2005), pero antes veremos cómo ha funcionado esta teoría en los medios clásicos, como el cine o los soportes fuera de línea. Aplicaremos, para empezar a familiarizarnos con ella, la teoría del doble nacimiento al medio cinematográfico. En la teoría de Altman16, al estudiar el advenimiento del sonido en la industria cinematográfica de Estados Unidos, este autor muestra que para que un nuevo medio se libere del estadio intermediático inicial, se requieren tres operaciones sucesivas: la citación, la explotación y la separación. El nuevo medio, que al inicio no es sino una nueva tecnología, empieza por citar los demás medios, no solo para hacerse aceptar sino para mostrar, a través de sus imitaciones, que es capaz de desarrollar capacidades análogas a los medios ya existentes. Resulta necesario, rápidamente, y con el objetivo de afirmar sus propias posibilidades, explotar los medios antiguos y probar que es capaz de realizar proezas que superen las capacidades de los otros medios. Finalmente, para establecer su especificidad y estabilizar su identidad, necesita desmarcarse de los otros medios, separarse, mostrándose en todo caso capaz, a partir de su formación, de integrar a los demás medios en su propio marco. Sin embargo, la estabilidad y legitimidad institucional de un medio no se consigue de forma definitiva para siempre ya que, como señala Altman, una nueva intermedialidad se encuentra siempre latente17.

Las primeras obras cinematográficas plantean un interrogante, ya que, por un lado, la toma era fija, y en consecuencia, el plan era espacial y formalmente inmóvil, y por otro, el aparato de tomar vistas se confundía con el aparato de proyección, dotado de un tiempo uniforme abstracto. Siguiendo este razonamiento lógico, la evolución del cine, la conquista de su propia esencia u originalidad fue efectuada, entonces, por el montaje, la cámara móvil y la emancipación de una presa que se separó de la proyección. Entonces el plano dejó de ser una categoría espacial para convertirse en temporal, y el corte se convirtió en un corte móvil en vez de inmóvil18. Gilles Deleuze se anticipó entonces a la idea de André Gaudreault y Philippe Marion sobre el doble nacimiento de los medios: según este autor, en un primer momento el cine opera como la prolongación de formas ya conocidas de espectáculo y entretenimiento, y en el segundo nacimiento adquiere legitimidad institucional y despliega su especificidad. Este modelo del doble nacimiento del cine puede ser desglosado en tres fases: la primera sería la de la aparición de un proceso técnico de la mano de los trabajos de numerosos investigadores, la segunda nos remitiría a la emergencia de unas obras y de unos procedimientos (donde los agentes principales serían los directores u operadores), y finalmente, se llegaría a la constitución de una institución medial, con los primeros directores y estudios en un sentido estricto19.

Gaudreault20, sin embargo, rechaza el uso de términos como “cine de los inicios”, “cine primitivo” y “cine de los primeros tiempos”, planteando un argumento que parte de una premisa radical: las imágenes en movimiento realizadas antes de la constitución del cine como institución medial no eran cine, sino otra cosa. A esta otra cosa lo denomina “cinematografía-atracción”. Su propuesta reta la manera como se han considerado tradicionalmente las imágenes animadas, ya que ha partido de considerar que lo que viene antes explica lo que viene después. De esta manera, los aproximadamente veinte años que siguen a la primera proyección pública realizada por los hermanos Lumière, más que el inicio del cine, fue un espacio fronterizo entre el tiempo en que el cinematógrafo no existía todavía, antes de 1895, y el tiempo en que el cine de los inicios, habiendo cedido ante el cine institucional, concluiría alrededor de 191521. Esto se podría ilustrar, según este autor, con los trabajos de los hermanos Lumière y de Georges Méliès. Las vistas de los primeros serían sobre todo fotografías animadas y, por tanto, formarían más parte de la historia de la fotografía que del cine, mientras que el segundo se convertiría en el introductor del cinematógrafo en el teatro, más que quien introdujo el teatro al cine.

Cine o no cine, la verdad es que el surgimiento mismo de la cinematografía es objeto de polémicas. Aunque Émile Reynaud, Louis Le Prince, Thomas Alva Edison e incluso Etienne-Jules Marey han tenido sus defensores como inventores del cine, son los hermanos Lumière los que se han llevado generalmente el reconocimiento por la invención. Jacques Aumont resume bien la situación, al referirse a Louis Lumière como el “más inventor del cine”, al “imaginar una técnica, concebir el dispositivo en el que esta sea eficaz, y percibir la finalidad para la que se ejerce esta eficacia22”.

Habitualmente, los primeros discursos en los nuevos medios imitan las formas de los medios anteriores más cercanos. La primera televisión se llamaba “radio visual” y el cine narrativo primitivo, que en Estados Unidos se llamaba “foto-teatro”, no era más que un teatro fotografiado. Hasta el desarrollo del montaje como medio de generación de expectativas o de asociación de ideas, el encuadre, el punto de vista o de la iluminación expresiva, el cine no fue un medio adulto, dueño de sus propias características. Hay un paso enormemente significativo desde el “sumar” características, a la “emergencia” de características propias. Como apunta Janet Murray: “Una de las lecciones que podemos aprender de la historia del cine es que las fórmulas aditivas como el “foto-teatro”, o el término moderno que sirve para todo, “multimedia”, son una señal de que el medio se encuentra en un estadio temprano de su desarrollo, y que aún depende de los formatos derivados de las tecnologías más antiguas en lugar de explotar su propio poder expresivo23”.

Si consideramos que el ordenador es la tecnología de soporte de un gran medio, el digital, sus orígenes atípicos señalan ya diferencias respecto a los anteriores en aspectos sustanciales. Siguiendo el análisis efectuado por Ribas24, vamos a aplicar al medio digital y la difusión cultural interactiva la teoría que sobre la genealogía de los medios han desarrollado André Gaudreault y Philippe Marion a partir del análisis detallado de la del cine. Aunque este modelo surja del estudio de un medio de gran alcance como es el cine, estos autores25 sugieren que se puede intentar aplicar a diversas escalas expresivas y parece claro que es así en el caso de los interactivos fuera de línea.

En el caso de los primeros ejemplos de ensayos de documentales interactivos para soporte CD ROM y/o DVD ROM, si bien es cierto que los autores empezaron a encontrar formas expresivas nuevas, características del discurso interactivo, falló el proceso de institucionalización, la construcción de una “cultura” propia a su alrededor. Actualmente, parece que las aplicaciones para tabletas podrían tener unas mejores condiciones de institucionalización. Su no consolidación ni institucionalización se debió a que eran tecnológicamente sistemas muy complejos, difíciles de instalar y mantener y necesitaban un ordenador multimedia no siempre estándar y de compatibilidad no garantizada completamente. Pedían usuarios con buenos conocimientos de informática aplicada, los cuales no eran un público general, y por tanto no se consolidó una “cultura” propia. Este factor clave y la materialidad del soporte hacen muy difícil un modelo de negocio viable. Esto se compensó circunstancialmente con aportaciones públicas como las de la RMN en Francia, pero la producción inicial centrada en la difusión cultural en CD-ROM fue desprestigiada definitivamente por estrategias editoriales mal planificadas, como productos a muy bajo precio de mala calidad y de nula innovación discursiva. Internet desplazó el centro de atención en las opciones de acceso a la información y conectividad extrema26.

Podemos razonablemente postular que en el caso del ordenador se da una fase previa a las tres fases que describe el modelo del doble nacimiento que no se da en otros medios: toda nueva tecnología o disposición nueva de la tecnología comienza su andadura expresiva de forma inmediata y relacionándose con los medios y procesos asociados que le son más cercanos. Así pues, y de acuerdo con Ribas27, antes de llegar a este punto el ordenador tuvo que atravesar una fase previa de “toma de conciencia” como medio expresivo y de comunicación, una fase de “concienciación”. El final de este proceso se hace evidente en los CD-ROM de difusión cultural: los primeros productos, realizados aproximadamente entre los años 1990 y 1994, se ejecutaban en una ventana más del sistema operativo, estaban rodeados de su escritorio, las carpetas y su papelera, y situaban en consecuencia al usuario en un entorno de trabajo en el que utilizaba una herramienta. La riquísima proliferación de CD-ROM de difusión cultural en este momento nos permite también asistir al paso siguiente de la aparición del medio, la búsqueda de sus formas de expresión características.

Este apoyarse en las formas anteriores para construir el discurso en el nuevo medio se observa de manera paradigmática en los primeros CD-ROM de difusión cultural. En efecto, los dos accesos principales de la primera edición del Louvre no son más que un catálogo para escuelas pictóricas, derivado directamente de los numerosísimos antecedentes canónicos en papel y una “visita”, transposición fotográfica del paseo real por las salas del museo. CD-ROM posteriores, como el del museo de Orsay (Montparnasse Multimedia, 1996), mantendrán la misma estructura, incorporando, eso sí, tecnologías más inmersivas, como la primera versión de QuickTime VR para incrementar el realismo en la representación de la visita28.

La fase de aparición en la teoría del doble nacimiento se caracteriza por esta repetición de formas anteriores. Esta repetición va derivando poco a poco (y a medida que los que utilizan el medio lo conocen mejor) hacia una situación expresiva propia, autónoma, acompañada de un proceso de institucionalización, como destaca Gaudreault29:

“ [...] despite the ‘attraction’ of the new apparatus, despite its status as a technological novelty, the medium was nevertheless used back then to do the same old things. (../..) It wasn’t until cinema’s practitioners arrived at a reflexive understanding of the medium and until the cinema achieved a certain degree of institutionalisation that the medium became autonomous”30.

Los CD-ROM de la segunda mitad de la década de 1990 empezaron a desarrollar formas expresivas intrínsecas del medio interactivo. Como propiedad común, todos estos casos se caracterizan por utilizar creativamente las formas intrínsecas del medio, formas nuevas de relacionar los diferentes medios entre sí y con la gestión de la acción. Así pues, parece fuera de toda duda que una de las condiciones para la consolidación de un medio, la que “sus practicantes llegaran a una comprensión reflexiva” se dio con creces en estos escasos 4 o 5 años. Creemos razonable sostener que la no consolidación se dio a causa del fallo de la segunda condición, el hecho de “lograr cierto grado de institucionalización”. En efecto, en la fase de constitución, una vez que la desafección posterior a la subordinación respecto a los medios anteriores ha llevado a una insubordinación, el medio comienza a revelar algunas de sus prácticas expresivas propias y, si estos reclamos identitarios y de autonomía tienen una respuesta institucional y económica, el medio, su cultura propia, se consolida: “Its second birth, or constitution, will appear when its quest for identity and autonomy coincides with institutional recognition and a decisive improvement in the economic resources devoted to its production31”.

La ausencia de este reconocimiento institucional, social y económico impidió la consolidación de esta forma de construir discursos de difusión cultural en los interactivos de uso personal. La incipiente cultura generada a su alrededor no llegó a consolidarse. Las causas más decisivas de este no reconocimiento se derivaban directamente de la complejidad de la propia tecnología de los CD-ROM, pues su adecuado funcionamiento requería un ordenador multimedia no siempre estándar, el uso de programas específicos y la realización de procesos de instalación complicados. Todo ello les hacía extraordinariamente susceptibles a todo tipo de errores, incluso después de las primeras sesiones de funcionamiento. Solo usuarios muy convencidos y con destreza informática podían finalmente acceder al disfrute del discurso interactivo contenido en el CD-ROM. Si ya es difícil en cualquier propuesta de tipo cultural llegar a interesar a la cantidad suficiente de personas para poder establecer una “cultura” propia, en este caso la dificultad se multiplicaba hasta la frontera de la imposibilidad 32.

Esta grave circunstancia, unida a la materialidad del soporte, hacía que fuera difícil establecer sobre estas bases un modelo de negocio viable. Solo la aportación de entidades públicas como la RMN pudo compensar este hecho durante algún tiempo. Por otra parte, la distribución inmaterial era mucho más sencilla y económica. Estas dos circunstancias comportaban el acceso a una cantidad de personas mucho mayor y con menores exigencias previas. Indudablemente, internet ofrece una base humana suficientemente grande para la consolidación de cualquier “cultura” específica. Pero no fue este el caso de la difusión cultural interactiva. Por un lado, el traspaso a internet implicaba un cambio obligado y difícilmente rentable en un modelo de negocio ya de por sí complejo. Por otro, el cambio implicó inevitablemente modificaciones radicales en el discurso que implicaron una desnaturalización de las nuevas formas experimentadas hasta entonces.

En primer lugar, el funcionamiento obligado dentro de la ventana del navegador supuso un retorno paradójico a la situación “informática” de la fase de concienciación del medio. La otra, la reducción drástica del ancho de banda desde el CD-ROM a la del primer internet, unida a la inicial invisibilidad en los buscadores de lo que no fuera texto, conllevó una reducción generalizada en aplicaciones basadas exclusivamente en texto e imagen o realizadas a base de pequeños fragmentos. Más importante probablemente que todas estas causas concretas es el efecto que la explosión de internet ha tenido en la percepción social de las posibilidades del medio interactivo. El centro de atención se ha desplazado hacia las opciones de conectividad extrema, por lo que se ha producido una reducción notable del propio concepto de interactividad, que se confunde hoy en día con las posibilidades del ordenador como gestor de la comunicación entre personas, dejando prácticamente de lado todas sus opciones como generador de discurso interactivo33.

Dedicarse a hacer o tratar producciones relacionadas con la cultura implica alejarse de los mercados tipo “mainstream”. Esto fue una de las causas del fracaso de formatos anteriores, digitales o predigitales. Las tabletas, sin embargo, abarcan hoy un mercado mundial, quizás con bastante tamaño incluso para la cultura y la educación al haber comenzado sobre un mercado consolidado, de uso sencillo y comprensible para la gente. El dispositivo físico tableta o derivados podría ser el primer dispositivo físico digital “permanente”. Pero, una vez más, no será nada fácil consolidar un submercado cultural coherente, estable y fiable. Habrá que integrar desde el principio estrategias transmediales, pues una aplicación sola es invisible34.

A pesar de este optimismo inicial, en el análisis de Ribas35 se desprende que también se palpan claros síntomas de inestabilidad, quizás inherente, incluso en formatos relativamente estables como los “libros ampliados”, sistemas de acceso a páginas, composición, etc. Pero el entorno se mueve, cambia y aparecen soluciones diferentes. Sí se detecta una continua citación de los medios del entorno. En este sentido, lo más cercano es el libro (y aún más el cuento infantil, seguramente por razones físicas tanto del soporte como de la interacción táctil), la “pantalla” con todas sus variantes y la gestión del sonido. En general se mantienen las formas de los medios anteriores y meras yuxtaposiciones y/o acumulaciones sin estructura discursiva propia. También es importante la gran dificultad de encontrar un lenguaje de la interacción táctil tan intuitivo como el del sistema ratón y/o cursor. Quizá por eso muchas aplicaciones derivan hacia acumulaciones de juegos muy simples basados en las formas de tocar la pantalla.

Como hemos reseguido anteriormente, el documental interactivo nace fruto del medio digital, cuando este, tras su fase de concienciación, se da cuenta de que puede contener géneros audiovisuales tradicionales pero con la interactividad como factor clave, novedosa y emergente. También la voluntad de tratar la información más como divulgación cultural que como medio informativo hace que los creadores o autores de interactivos empiecen a “ensayar y experimentar” con obras básicamente financiadas por la museística y de otros ámbitos de la cultura y el espectáculo.

Siguiendo a Gaudreault36, la aparición de la tecnología vendría representada por el medio digital, y sobre todo caracterizada por los soportes fuera de línea ópticos y la red internet; la emergencia de un dispositivo concreto se manifestaría en el momento en que el documental interactivo se desmarca de su homónimo audiovisual lineal y ofrece la alternativa y/o posibilidad de contar historias de otra manera, unido a la explosión de formatos, soportes y plataformas de principios del siglo actual, y finalmente, el advenimiento de una institución se inició a partir de la segunda década del presente siglo con un conjunto de organismos e instituciones dedicadas a su estudio, análisis y producción. Ejemplos a nivel concreto o micro serían el grupo “i-docs “, con sus actividades generadas como la “i-docs Conference” o el “i-docs Lab”, las iniciativas “Docshift” (Institute, Summit, Index, etc.), el departamento “Highrise” del NFB, el proyecto “Living Docs” de Mozilla, el laboratorio del MIT (Open Documentary Lab), la plataforma interDOC, las ayudas para financiar este tipo de producciones (Tribeca, Sundance, Sheffield docFest, Cross Video Days, Sunny side of the Doc, etc.), y a nivel más genérico y macro, las alianzas entre actores de diferentes países tales como productoras, radiodifusores, gobiernos y desarrolladores tecnológicos, las ayudas de importantes festivales; numerosos portales y páginas web dedicadas al estudio del género, las primeras publicaciones, artículos y tesis doctorales sobre el género, etc.

Según la teoría del doble nacimiento, el proceso entre la aparición de la tecnología y la constitución del medio podría ubicarse entre 1980 y principios del siglo xxi, mientras que actualmente nos encontramos inmersos en el proceso comprendido entre su segundo nacimiento, que coincide con la explosión de la forma durante los años 2008-2009, y su verdadera consolidación, que aún debe producirse. En esta transición es donde se observan las tres fases principales que utilizamos para elaborar nuestra propuesta de división por periodos o etapas, como “aparición”, “emergencia” y “constitución”, incluyendo la de “diversificación/institucionalización”.

En la fase de aparición o nuevo uso de la tecnología, el documental interactivo quedó claramente subordinado a las convenciones (medios, géneros, etc.) preexistentes. En esta fase, el nuevo medio “citaba” otros medios para ocultar su “bastardía” o falta de identidad, como lo demuestra el hecho de que nadie lo llamaba como tal ni consideraba el hecho de que el documental podía trasladarse a los medios digitales interactivos. Esta fase equivaldría a la de “citación” según Altman37. Durante la fase de emergencia aparecieron un conjunto de procedimientos o prácticas discursivas que se diferenciaron de las anteriores, como se observa en el análisis extenso que hace Ribas38, aunque él lo considere como un ensayo y nosotros creamos que en muchos casos los proyectos se encuentran en un punto medio indeterminado entre la ensayística y el documental. En cualquier caso, a partir de la experimentación, hay una “explotación” de ciertos aspectos del discurso interactivo que enriquecen y diferencian el nuevo género de su progenitor, el medio digital. El medio sigue evocando los demás medios, pero a menudo para mostrar, de forma más o menos escondida, su superioridad: el documental interactivo comenzaba a esbozar su idoneidad para contar historias de manera original y divertida, diferente a la de los hipertextos que entonces conformaban una web rígida y de difícil acceso y comprensión. La fase de constitución del medio se produce cuando las prácticas se insubordinan, los discursos son claramente diferenciados de los otros medios y el medio adquiere su identidad, como empieza a suceder en la actualidad. Nos encontraríamos, siguiendo a Altman, en la fase de “separación”, que nosotros llamamos “diversificación”. Pero la consolidación del medio necesita que se produzca una institucionalización, resultado de la relación de todos los agentes y factores implicados, que lleve el medio a la autonomía y a la identidad que Gaudreault llama “segundo nacimiento” o consolidación, y eso solo ocurrirá si se consigue generar un sólido y rentable modelo de negocio, lo que fue determinante en el fracaso de su antecesor en soporte óptico.

Para elaborar nuestra propuesta original en este capítulo, y partiendo de las teorías y modelos descritos anteriormente, hemos detectado un conjunto de proyectos que marcaron tendencia por su impacto e innovación temática y formal, hemos analizado la época en que se concibieron, acabando por delimitar cuatro etapas o décadas clave, las cuales se constituyen como la breve historia y/o recorrido cronológico que presenta, a nuestro entender, este formato específico. La justificación de esta estructuración responde a parámetros de producción: es decir, a finales del año 1979 se produce la primera simulación que representa claramente un precedente del formato estudiado, así como algunos juegos desarrollados durante los años 80. A finales de los 80 se creó la primera aplicación que se llama como tal, y durante la siguiente década se experimenta con formatos para más de un soporte, mayoritariamente para fuera de línea –CD-ROM y DVD-ROM–, en línea y para instalación interactiva. Toda esta innovación se consolida con la producción de principios y sobre todo finales de la primera década del siglo xxi, hasta el punto actual, donde las nuevas tendencias se diversifican y donde empiezan a abundar los diferentes ejemplos de cada categoría existente. Aunque la delimitación de los años pueda ser discutible, hemos intentado ofrecer un despliegue cronológico lineal y sencillo para facilitar su descripción, selección y clasificación de los ejemplos comentados a lo largo del estudio. Cada etapa se denomina de una forma determinada siguiendo la teoría del doble nacimiento de Gaudrealt y Marion: aparición, emergencia y experimentación, constitución y consolidación, y una última etapa que hemos denominado “diversificación”, próxima a la fase de institucionalización que precede al segundo nacimiento.

Durante los años 1980-1990 se produjeron un conjunto reducido de precedentes y antecedentes, situación que comportó, a finales de esta década, el nacimiento del documental interactivo, es decir, su aparición en el panorama audiovisual, eso sí, unos años después de una etapa previa de concienciación del propio nuevo medio digital y el ordenador.

Durante la última década del siglo xx se inició un segundo periodo muy intenso de experimentación del documental interactivo para diferentes soportes, aprovechando la aparición de la web, que conllevó una fase emergente hasta llegar a su constitución en el tercer periodo como forma autónoma, y consolidación como formato audiovisual interactivo durante los siguientes diez años aproximadamente (2000-2010).

Actualmente nos encontramos inmersos en la cuarta etapa de desarrollo, unos años donde la producción ha aumentado considerablemente y ya podemos empezar a hablar, con precaución, de una cierta diversificación de proyectos, plataformas, practicantes, empresas y en general de constitución del formato como género y metagénero con características propias y específicas, situación ideal para experimentar el segundo nacimiento, ahora en una esfera institucional que empieza a ser sólida y estable.

Dentro de cada etapa y/o periodo destacamos el desarrollo de la tecnología, factor clave para la expansión de este género, y citamos los ejemplos más representativos. A continuación ofrecemos un esquema inicial de la propuesta de evolución cronològica39 que presentamos en este capítulo:

En nuestra justificación de la división con relación a la breve historia del documental interactivo hemos partido de varias teorías, como la “Genealogía de los medios”, el concepto de “intermedialidad”40, la teoría del “doble nacimiento de los medios”41 y el modelo de Altman42 aplicado al caso del cine43.

Aplicaremos específicamente a nuestro objeto de estudio el modelo del “doble nacimiento” desarrollado por André Gaudreault y Philippe Marion a partir del análisis detallado de la consolidación del cine, y aplicado, entre otras, a la fotografía y al cómic. Para realizar esta aproximación, hemos partido del cine y los soportes fuera de línea (CD ROM), que en cierto modo son dos de los pilares básicos sobre los que se erige el documental interactivo, para ejemplificar cómo funciona y se adapta el modelo. Nos interesa especialmente la relación del nuevo medio con los preexistentes en las tres fases del modelo que expondremos, pues puede dar indicios de la situación de un medio o forma emergente nueva.

Ideado por Jürgen E. Müller en el año 1987, el concepto de “intermedialidad” se refiere a una problemática específica: la de la identidad de los medios y, en consecuencia, de su desarrollo histórico con sus interferencias recíprocas. Müller creaba la hipótesis de que la televisión debía ser concebida como un dispositivo híbrido e intermediático, que se encontraba con interacciones complejas con otros dispositivos. Al abordarse los medios en términos de identidad más que de especificidad, el enfoque los considera como procesos44. El concepto de intermedialidad ha sido retomado actualmente por los estudiosos del cine con el objetivo de proponer un modelo que pueda demostrar que la identidad del cine como nuevo medio fue de larga constitución. Siguiendo la definición de Rick Altman45, la intermedialidad designa una etapa histórica, un estado transitorio en el curso del cual una forma en camino de convertirse en un medio aparte se encuentra todavía dividida entre varios medios existentes, en un punto tal que su propia identidad queda en suspenso.

La teoría de Andre Gaudreault y Philippe Marion del “doble nacimiento de los medios” afirma que un medio nace una primera vez como prolongación de prácticas anteriores a su aparición y a los que estaba integrado en su etapa primaria. Y vuelve a nacer una segunda vez en el momento en que adquiere una vía propia, a través de la cual los medios que ha desarrollado han adquirido esa legitimidad institucional que reconoce su especificidad. Esta hipótesis de partida conduce a Gaudreault y Marion46 a sustituir el término ambivalente del nacimiento por tres otros términos de gestación y desarrollo de un medio: la aparición (de una tecnología), la emergencia (de un dispositivo) y el advenimiento (de una institución). El modelo recibe el nombre de “doble nacimiento”, ya que se centra en dos fases y/o procesos: el proceso entre la aparición de la tecnología y la constitución del medio, y el proceso entre su segundo nacimiento y su verdadera consolidación. Esta transición se divide en tres fases, “aparición”, “emergencia” y “constitución”, y se caracteriza de diferentes modos a partir de los agentes implicados en cada momento.

En el caso de los inicios del medio cinematográfico, en su análisis, Altman47 incorpora el papel de los agentes implicados en cada fase (por ejemplo, inventores, operadores de cámara y directores en el caso del cine), los procesos de producción, o de la relación con el entorno institucional y con los medios cercanos ya establecidos. En la fase de aparición o nuevo uso de la tecnología, el medio queda subordinado a las convenciones (medios, géneros, etc.) preexistentes. En esta fase, el nuevo medio “cita” otros medios para ocultar su “bastardía” o falta de identidad. Durante la fase de emergencia aparecen un conjunto de procedimientos o prácticas discursivas que se diferencian de las anteriores. El medio sigue evocando los demás medios, pero a menudo para mostrar, de forma más o menos escondida, su superioridad. La fase de constitución del medio se produce cuando las prácticas se insubordinan, los discursos son claramente diferenciados de los otros medios y el medio adquiere su identidad.

Pero la consolidación del medio necesita que se produzca una institucionalización, resultado de la relación de todos los agentes y factores implicados, que lleve el medio a la autonomía y a la identidad que Gaudreault llama “segundo nacimiento” o consolidación: “Its second birth, or constitution, will appear when its quest for identity and autonomy coincides with institutional recognition and a decisive improvement in the economic resources devoted to its production”48. Vamos a analizar en los siguientes apartados las distintas etapas citadas, el desarrollo tecnológico implícito que permite desarrollar el discurso, y algunos ejemplos representativos.

Los primeros precedentes, antecedentes y documentales interactivos eran soportados por unas tecnologías iniciales, como los laserdic y las memorias ópticas. A continuación las listamos con cierto detalle.

El disco fue durante muchos años el único formato de referencia de las aplicaciones auditivas o visuales y no fue hasta que se necesitaron contenedores de gran volumen de información cuando se desarrollaron los sistemas magnéticos en cinta que ofrecían una mayor capacidad de almacenamiento a cambio de forzar la secuencialidad del acceso49. La idea de disponer la información de imagen junto a la del sonido en un soporte de forma circular era tan antigua casi como la invención del gramófono por Emile Berliner en 1888. De hecho, en 1923 John Logie Baird con su Phonovision adaptó esta misma tecnología “de contacto” para meter en un disco unas pocas imágenes de escasas 30 líneas de resolución, que se movían a 12 fotogramas por segundo. El problema, naturalmente, era la pequeña superficie de un disco de dimensiones razonables, que hacía que se pudieran colocar muy pocas imágenes. Unas décadas más tarde, estas tecnologías de contacto habían logrado surcos estrechísimos y los primeros discos de vídeo (TED, CED, VHD) empleaban tecnologías piezoeléctricas que “rozaban” la superficie del disco50. El laserdisc o LD fue el primer sistema de almacenamiento en disco óptico comercializado, y fue usado principalmente para reproducir películas. Comercializado inicialmente como Discovision en 1978, la tecnología fue licenciada y vendida como Reflective Optical Videodisc, Laser videodisco, LaserVision, Disco-Vision, DiscoVision y MCA DiscoVision, hasta que Pioneer Electronics compró la participación mayoritaria en el formato y lo comercializó como LaserDisc durante la segunda mitad de los 80.

Actualmente, el laserdisc ha sido totalmente reemplazado por el DVD en el mercado, ya que ni los reproductores ni el software son producidos en este formato. Ha conservado su popularidad entre los coleccionistas estadounidenses y, en un mayor grado, en Japón, donde el formato fue mejor soportado y más habitual en la vida cotidiana. En Europa, el laserdisc ha sido siempre un formato débil. En España muchas de sus ventas iban ligadas a las primeras versiones de enciclopedias multimedia y colecciones de documentales, mayoritariamente comercializadas por el canal de venta de libros a domicilio. Donde hubo una producción muy grande de videodiscos fue en el mercado americano. Se empleó mucho en puntos de información y catálogos de grandes empresas y almacenes, o en aplicaciones de formación en habilidades que se beneficiaban especialmente de la posibilidad única de incluir imagen en movimiento realista: simuladores de vuelo, de reparaciones costosas o peligrosas, etc. También tuvo un mercado educativo muy importante, nuevamente en Estados Unidos. Y también fue en este formato en el que se hicieron las primeras aplicaciones de difusión cultural.

El tratamiento de la mayoría se basaba en la superior calidad de la imagen respecto a una cinta doméstica y en la posibilidad de realizar una pausa perfecta para mostrar obras de arte visual con posibilidades de personalización nuevas. Naturalmente, ante la imposibilidad de tener en casa un sistema informático de gestión del videodisco, todos estos primeros productos editoriales estaban pensados básicamente para trabajar el nivel básico de interactividad. Por tanto, todos iban acompañados de un texto o libreto donde se explicaba la situación de las imágenes o fragmentos de vídeo, su distribución por capítulos y se podían sugerir posibles trayectorias diferentes para la información audiovisual, con finalidades diversas, didácticas o de entretenimiento51. Fue especialmente importante el papel de la productora norteamericana Voyager en el mercado de la difusión cultural en general y del arte en particular a través del videodisco. Excelentes productos sobre artistas como Van Gogh o Muybridge, o sobre museos como The Art Institute of Chicago o The National Gallery of Art de Washington, entre muchos otros, supusieron un primer cambio conceptual importante en las formas de divulgar la cultura. También vale la pena mencionar el caso de la Société ODA, de París, que produjo unos excelentes videodiscos sobre los museos del Louvre y Orsay, precedentes de la magnífica línea de productos interactivos culturales franceses actual52. En los últimos años de utilización de los videodiscos, a finales de los 80, algunas producciones comenzaron a incorporar programas informáticos de control del videodisco y ampliación y gestión de la información almacenada.

La digitalización aporta una serie de ventajas fundamentales respecto a la situación en la época del videodisco. Todas provienen del tratamiento uniforme de los diversos medios propio del entorno digital: toda la información se despliega en archivos que el sistema gestiona de la misma manera. Esto hace que la integración informática sea sencilla y homogénea y que, por ejemplo, los lenguajes de desarrollo de aplicaciones no tengan que hacer distinciones fundamentales en función del medio a incorporar. Naturalmente el hardware necesario se simplifica y se convierte en un solo ordenador con capacidades de gestión multimedia y, a nivel de aplicaciones, el contenido y su estructuración pasan a estar en el mismo medio, el medio digital. Esto tendrá importantes consecuencias a nivel teórico y permitirá que las reflexiones incipientes sobre el concepto de hipertexto incorporen de forma natural la información audiovisual en una extensión terminológica y conceptual que la homogeneidad del digital suaviza. Y es que, a pesar de los graves inconvenientes que presentaba, el videodisco interactivo había movido por primera vez una serie de voluntades e iniciativas de todo tipo en torno a las posibilidades de la comunicación interactiva. Personas provenientes de la producción de vídeo lineal, de la comunicación empresarial, de la enseñanza asistida por ordenador, de la informática documental, artistas, escritores, etc., confluyeron y se acercaron por primera vez a la comunicación interactiva a través del videodisco. A finales de los 80 y principios de los 90, el momento en que la digitalización multimedia comienza a ser una evidencia de inmediato futuro, todas las ideas e iniciativas del campo del hipertexto y del videodisco interactivo empiezan a confluir. Es la época de los primeros congresos y asociaciones sobre el tema y del surgimiento de las ideas más importantes sobre las que se construye la teoría de la comunicación interactiva actual53.

Las primeras aplicaciones audiovisuales verdaderamente interactivas fueron realizadas en el formato de videodisco óptico LaserVision durante la década de los años 80. Este sistema había sido desarrollado por la empresa Philips durante la década de los 70. Se trataba de un formato analógico y de difícil gestión, pero propició el acercamiento de personas de ámbitos diversos a la comunicación interactiva. Ya en el año 1929 existió una patente de Reginald T. Friebus para registrar sonido e imágenes en color, en un disco para sistemas ópticos, pero no fue hasta la invención del láser, con su extraordinaria capacidad de concentrar el rayo de luz, cuando fue posible que en una cara de un disco se pudiera almacenar una cantidad razonable de programa audiovisual54. De todos los sistemas ópticos que compitieron durante la década de los 70 y 80 (más de 25, en 1976), el LaserVision se acabó imponiendo por su resistencia y facilidad de uso. Su formato CLV, concebido para ver películas de forma bastante lineal, no llegó nunca a prosperar, en competencia con los magnetoscopios domésticos en cinta registrable y borrable. El formato CAV (Constant Angular Velocity) posibilitó las primeras aplicaciones audiovisuales interactivas. El secreto del formato CAV estaba en la disposición de una sola imagen en cada vuelta del disco. De esta manera, y girando a velocidad constante de 25 vueltas por segundo –en el sistema PAL– mientras el cabezal lector láser hacía un pequeño movimiento en dirección radial en cada vuelta, se podía reproducir vídeo en movimiento. Pero también se podía hacer una pausa perfecta y de duración ilimitada, con el sencillo procedimiento de detener este cabezal para reproducir 25 veces por segundo la misma imagen. O se podía dar marcha rápida o lenta, adelante o atrás, con el control de la velocidad y el sentido de desplazamiento de este cabezal en la dirección del radio del disco. Y lo que era más importante, todas las imágenes se podían numerar –del 1 al 54.000, en una cara–, con un código digital mezclado con la imagen, y se podía hacer llegar el cabezal a cualquiera en pocas décimas de segundo. La combinación de este acceso aleatorio y la pausa perfecta e ilimitada convirtieron el formato CAV del LaserVision en el paradigma de las primeras aplicaciones audiovisuales interactivas. Las 54.000 vueltas de una cara se podían emplear para tener este mismo número de imágenes diferentes, para tener 36 minutos de vídeo PAL o para cualquier combinación de imagen fija y en movimiento dentro de estos límites, con el añadido de dos canales de sonido conmutables. Todas las funciones que permitía el formato CAV se podían controlar con el mando a distancia, era el nivel I de interactividad, o con un ordenador externo –en el nivel III–. Como destaca Ribas 55, un programa que funcionara en este ordenador podía añadir a sus intrínsecas capacidades interactivas fragmentos de vídeo y sonido o imágenes fijas de calidad videográfica, eso sí, en un monitor diferente al del ordenador, ya que la imagen y el sonido almacenados en el LaserVision eran todavía analógicos. El sistema era ciertamente mastodóntico, difícil de gestionar e impensable de distribuir entre el público en general: un ordenador con su monitor, un lector de videodisco con su televisor y una conexión entre ambos, formada por un cable especial y un programa para gestionarla. Y si se quería tener la salida del ordenador en la misma pantalla videográfica, había una tarjeta especial de sincronización, cara, difícil de gestionar y no estandarizada. Otro inconveniente importante fue la incompatibilidad entre los sistemas de televisión NTSC y PAL, que impidió la extensión del videodisco.

Las diferentes clases de memorias ópticas permiten abrir una nueva era con relación al almacenamiento y recuperación de la información. Entendemos por memorias ópticas aquellos sistemas que utilizan el rayo láser para grabar y reproducir información. La idea de utilizar un rayo de luz para leer la información almacenada en un determinado soporte es muy antigua: en 1929, un ingeniero de la Columbia, Reginald T. Friebus, presentaba la patente de un disco capaz de almacenar imágenes en colores y sonido. La información se codificaba en forma digital y la lectura debía hacerse mediante un delgado rayo de luz. La invención del iconoscopio o tubo de televisión con su resolución superior hicieron inviables esta y otras ideas, y no llegó, por tanto, a construirse nunca un prototipo del visionario invento de Friebus.

También empleaban tecnología óptica los primeros intentos serios, ya en la década de los 60, de desarrollar un sistema de videodisco. Usaban como soporte una placa fotográfica circular de alta resolución. La idea pasó por varias compañías, desde 3M a MCA, a través de la cual llegó a influir en el actual estándar Laservision. Fue la posibilidad de aplicar la tecnología láser lo que dio el impulso definitivo a la vía óptica de almacenamiento de la información. Con la luz del láser es posible, en efecto, realizar una acción selectiva sobre zonas muy pequeñas de superficie. El tamaño de estas zonas es del orden de la propia longitud de onda de la luz, es decir, del orden de la millonésima de metro.

No es extraño, pues, que se haya pensado en utilizar procedimientos ópticos para almacenar cualquier tipo de información: textos, archivos informáticos, audio, vídeo, etc. En efecto, su densidad de almacenamiento (10.000 bits o elementos de información por mm2) es 30 veces superior a la de los soportes magnéticos usuales en informática. Esto significa que un disco óptico puede contener 30 veces más información que un disco magnético del mismo tamaño. La otra ventaja tradicional de las memorias ópticas sobre las magnéticas es su muy superior perdurabilidad. Al no existir contacto físico entre el disco y un instrumento de lectura (esta se hace a través del láser), no se produce ningún desgaste del soporte. Se calcula que cada copia de videodisco Laservision puede durar más de 100 años, que se convierten en 10.000 para el disco matriz. En comparación, la vida media de una cinta magnética de vídeo se estima en 15 años en unas condiciones de conservación, además, mucho más estrictas.

El inconveniente clásico de las memorias ópticas es que, en principio, no pueden grabar y borrar. Esto ha hecho que el mercado se decantara hacia los soportes magnéticos en todas aquellas aplicaciones en las que es importante la provisión de información por parte del usuario sin que sea vital la cantidad y perdurabilidad del almacenado. La coexistencia de estas con otras aplicaciones en las que se puede trabajar sobre una información ya “cerrada” es la situación actual del mercado de los soportes de información. Existen muchos tipos de memorias ópticas que sí pueden ser manipuladas por el usuario. Unas pueden ser grabadas pero no borradas y se llaman WORM (Write Once Read Many), mientras que otras pueden ser regrabadas tantas veces como sea necesario: son las EDRAW (Erasable Direct Read After Write).

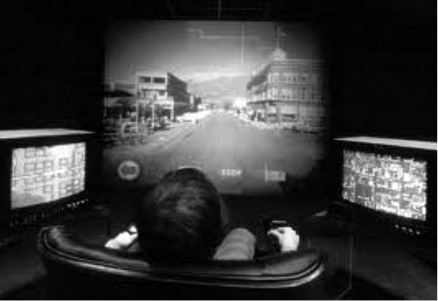

Como se ha explicado previamente, la invención de la óptica del videodisco fue el elemento clave que permitió almacenar y acceder hasta media hora de vídeo analógico a través de un ordenador. El Media Lab del MIT (Cambridge)56, a finales de los años 70 y dirigido por Nicholas Negroponte, decidió experimentar con la creación de un espacio virtual de viaje llamado Aspen Movie Map. El objetivo era permitir que un usuario condujera a través de toda la ciudad de Aspen, Colorado. En “la habitación de los medios” un usuario podía controlar la velocidad y la dirección de transporte dentro de la ciudad interactuando con una interfaz de pantalla. Andy Lippman, director del proyecto, concebía su visión de la interactividad como una “mutua y simultánea actividad por parte de los dos participantes, generalmente trabajando hacia una meta conjunta, pero no necesariamente”. Gaudenzi señala, con relación a la visión personal de Lippman:

“For him (Lippman), to be interesting a conversation needs to be interruptable (interruptibility), an unanswerable request should lead into a smooth transition (gracefull degradation), sentences -or moves- should be decided on the fly (limited look-ahead), sentences needs to feel unpredictable (no-default) and the conversation needs to feel potentially endless (impression of infinite database)57”.

El modelo de inspiración de Lippmann en referencia al modelo centrado en la interacción persona-ordenador (HCI) es el de una conversación, a diferencia de una clase. Para que un participante obtenga éxito y a la vez experimente satisfacción en una conversación, tiene que haber un intercambio más que una escucha pasiva. Obviamente, en el caso del Aspen Movie Map, la tecnología no fue capaz de crear un espacio computacional realmente abierto (esto sigue siendo un reto hoy en día), pero el modelo de inspiración para la interacción entre el Aspen Movie Map y el usuario es el de una conversación: se intenta que el usuario se sienta libre para improvisar movimientos en cualquier momento y que el software responda sin problemas a estas decisiones58.

2.2 “Habitación de los medios” en el proyecto Aspen Movie Map

El Aspen Movie Map no fue llamado ni considerado como un documental interactivo: era visto como una conducción virtual interactiva por una ciudad. Gaudenzi59 lo considera como una experiencia clave, ya que le mostró las esperanzas iniciales de un nuevo formato: lo “real”. La ciudad de Aspen no se explica al usuario, sino que se simula para el usuario. La idea de la documentación pasa de la explicación de la realidad a la simulación de la realidad. El usuario necesita sentirse libre de hacer y explorar sin necesidad del sistema ni la sensación de sus limitaciones. El autor, en este caso el Architecture Machine Group del MIT, utilizó el ordenador como un simulador de la realidad, determinando lo que puede ser hecho a partir de esta “realidad” (girar, parar, tocar la pared, etc.).

2.3 Interacción táctil en el proyecto Aspen Movie Map

Aunque el disco de vídeo ha limitado la capacidad de almacenamiento y la interacción, durante esta época se empezó a concebir la experiencia sin límites: el usuario no se siente atrapado en un sistema predefinido y basado en las reglas del autor. El modo de conversación apunta a un sistema que realmente parece vivo. La visión de Lippmann de una conversación libre con el equipo es todavía técnicamente imposible, pero su simulación se está volviendo más y más convincente a medida que la velocidad y la memoria del ordenador se van ampliando. Gaudenzi resalta el hecho de la creación de los sistemas vivos y cita, del teórico de la computación Michael Murtaugh, la siguiente idea: ‘interactivity always involves simultaneity, as computations occurs iteratively through feedback to a shared and changing environment’60. El tema de la creación de sistemas vivos es considerado por la autora como la clave (the Holy Grail of Liveness) de la interactividad y lo ejemplifica a través de dos ejemplos concretos: el uso de la Inteligencia Artificial en los juegos y la extensión del entorno de interacción de la pantalla al espacio físico en proyectos locativos61. La suposición básica es que interactuar con un mundo es como conversar con él: la interacción se encuentra abierta a un sinfín de posibilidades (impresión de la base de datos infinita), y por tanto, el usuario y el medio reaccionan en tiempo real el uno con el otro. La inteligencia artificial se aplicó primero a los juegos y luego a la narrativa interactiva, pero recientemente han surgido formas híbridas que mezclan documental y juego, borrando sus supuestas fronteras.

2.4 Ejemplo de la interfaz de navegación del proyecto Aspen Movie Map

El primer relato interactivo que se reconoció claramente como algo más que un juego fue SimCity. Este juego, basado en la simulación de Will Wright (editado por primera vez en 1989), se basa en la generación de diferentes eventos en función de las decisiones que el usuario ha tomado en la construcción de una ciudad virtual. SimCity es un videojuego de construcción de ciudades donde el interactor es el alcalde y debe ir construyendo una ciudad poco a poco. La meta de este juego es llegar a edificar una ciudad donde todos los ciudadanos estén contentos al observar el progreso de la misma, porque si no lo están, se mudarán a otras ciudades. Pero, por otra parte, si las acciones son las acertadas, la ciudad prosperará y los ciudadanos la amarán y querrán vivir en ella. Este juego es uno de los que tienen más características realistas, ya que se deben cuidar los impuestos, las ganancias, la seguridad, la educación, el tráfico, la sanidad y el medio ambiente, entre otros.

SimCity se ha convertido, con el tiempo, en una serie de videojuegos de construcción de ciudades desarrollada y publicada por Maxis (actualmente una división de Electronic Arts) y una de sus primeras grandes apuestas en el ámbito de los juegos. La temática de los juegos de la saga se enfoca en la creación, gestión y evolución de ciudades. El juego consiste exactamente en crear para proveer. El jugador comienza el juego con un mapa en blanco, y debe iniciar y expandir una ciudad con el presupuesto de que dispone. La ciudad debe ofrecer a sus ciudadanos los servicios básicos que requieran, como acueductos, energía eléctrica, provisiones, servicios básicos, etc., e incluso, a partir de SimCity 3000, la gestión de residuos urbanos. Además de los servicios elementales, los ciudadanos deben tener acceso a salud, educación, seguridad y lugares de esparcimiento, representados todos ellos mediante diferentes edificios. La fuente principal de ingresos monetarios de la ciudad son los impuestos, que pueden alterarse con diferentes resultados. Algunas otras formas de obtener ingresos son la venta de servicios a ciudades vecinas, y la ubicación de edificios especiales dentro de la ciudad (casinos, bases militares, etc.).

Los juegos de la saga SimCity son diseñados principalmente para un solo jugador, a excepción de una edición de SimCity 2000 para jugar en red, y un puerto Unix del SimCity original. SimCity 4 permite el intercambio entre jugadores de mapas regionales y ciudades, pero no permite el juego simultáneo en tiempo real. Will Wright, su creador, obtuvo la inspiración para SimCity a partir de una característica del juego Raid on Bungeling Bay62, que le permitía crear sus propios mapas durante el desarrollo, notando que disfrutaba más a la hora de crear mapas que al jugar formalmente. Adicionalmente, Wright se inspiró en la lectura de The Seventh Sally (1974), una corta historia de Stanislaw Lem en la que un ingeniero encuentra un tirano destituido y crea una ciudad en miniatura con ciudadanos artificiales para que el tirano les oprima. La primera versión del juego fue desarrollada para el Commodore 64 en 1985, pero sería publicada cuatro años después. El título original de SimCity fue Micropolis. El juego representó un paradigma inusual en videojuegos: debido a que el jugador no podía ganar ni perder, los distribuidores no creían que fuera posible vender un juego de este estilo satisfactoriamente. La compañía Broderbund rechazó publicar el título cuando Wright se lo propuso. Finalmente, Jeff Braun, fundador de la entonces naciente Maxis, aceptó y publicó SimCity63 como uno de los dos títulos iniciales de la compañía.

2.5 Portada y ejemplos de interfaz de SimCity

Luego, años más tarde, con The Sims, la misma lógica se aplicó a los personajes de una familia, de modo que el juego y la narrativa se acercaron más que nunca. The Sims (2000) es, según Manovich (1994), una “simulación dinámica que se ejecuta en tiempo real”, donde el “universo social ya no debe ser incluido en la muestra, pero puede ser modelado como un proceso continuo”64. En The Sims, el jugador crea una familia y luego los ve en plena evolución, hasta el punto de que los personajes virtuales están “vivos” incluso cuando el jugador no está activo.

Diez años después de la aparición del Aspen Movie Map en escena, en 1989, la tecnología se perfeccionó y la introducción de los ordenadores personales como objeto de consumo de masas permitió que un proyecto como Moss Landing fuera posible. Moss Landing es probablemente la primera pieza producida digitalmente que se llamó oficialmente “documental interactivo”.

En 1989, el Apple Multimedia Lab65 organizó una sesión de un día en el pequeño pueblo americano de Moss Landing. Ese día, varias cámaras grabaron al mismo tiempo la vida de las personas en el puerto de Moss Landing. El usuario, en el aplicativo, podía pulsar sobre ciertos objetos o lugares de una hyper picture postcard shot66 y esta iniciaba un vídeo que mostraba el punto de vista de la persona o la posición desde la cual se había pulsado. Según uno de los entrevistados, la metáfora es la de autostop: “uno empieza un viaje con alguien y continúa con otro”.

2.6 Ejemplo de interfaz hipertextual en Moss Landing

El interactivo se alimenta de una base de datos de material de vídeo que está cerrado (preestablecido por el autor), opera con vínculos definidos por algoritmos que permiten saltar de un vídeo a otro (los vídeos son limitados en número y la duración fijada por la memoria del ordenador) y con un punto de partida –posición– para el usuario que se encuentra predefinido (hyper picture postcard shot). El equipo fue construido para hacer cálculos algorítmicos, y, por tanto, lo que hace mejor es la vinculación, la resolución de problemas, el cálculo, la búsqueda, etc. Moss Landing es uno de los primeros ejemplos de “hipertexto multimedia”, destinado a saltar entre las modalidades de diferentes tipos de media (de texto en el vídeo, de foto a mapa, de vídeo a vídeo, etc.) dentro de un marco narrativo. Enlazando con Turing, y en referencia a lo que postularon Eberbach, Goldin y Wegner (2004), los ordenadores inspirados por la máquina de Turing cuentan con tres propiedades principales:

En esta lógica algorítmica de la computación interactiva no hay espacio para lo inesperado, ya que no hay ninguna apertura al que es externo al sistema (no es generativo, sino predefinido, prerrenderizado). Esta es probablemente la razón por la que esta lógica de interacción ha sido reiteradamente aplicada no solo a los contenidos informativos, sino también al contenido narrativo. La mayoría de documentales interactivos en CD-ROM y DVD-ROM se basan en el modelo hipertextual. El hipertexto de ficción se empezó a aplicar en la narrativa durante la década de 1980: una serie de textos que estaban vinculados a través de hipervínculos utilizando un software llamado Storyspace, y el lector podía navegar en red por los textos (llamados lexias) haciendo clic en los hipervínculos. Ejemplos clásicos son Afternoon (1987), de Michael Joyce, y Victory Garden (1995), de Stuart Multhrop. Los hipertextos estaban originalmente basados en el texto, pero su lógica se puede aplicar al vídeo o a las imágenes. La interactividad no es, como en el ejemplo anterior, una conversación más: su fluidez se ha perdido, se ha convertido en una exploración a través de rutas preestablecidas. La realidad que se puede expresar con esta lógica es navegable, pero predeterminada. El autor puede mantener un control razonable sobre la descripción de lo que se quiere comunicar y el nivel de control dependerá del grado de ramificación de la estructura que contienen las diferentes piezas de la historia. Y todo ello, a efectos prácticos, se traduce en hacer clic en una palabra, mover el ratón, seleccionar dentro de un menú que el usuario navega entre una serie de opciones preestablecidas, etc. El medio no es imprevisibe, sino explorable. La lógica imperante se articula en función de la elección del usuario. El autor crea escenarios, el software, enlaces activos de una base de datos y el usuario elige rutas. En este caso, la realidad no es una co-creación que se establece a partir de la conversación mutua entre el usuario y el autor a través de los medios, sino un conjunto de posibilidades donde el usuario es un invitado en vez de un participante.

Como ejemplos que ilustran el modo que define como el de autostop (o predefinido, calculado o prerrenderizado), Gaudenzi propone los siguientes:

“I would tend to put in this mode a very varied array of interactive documentaries. From artistic projects such as Inmemory of Chris Marker (CD-Rom, 1997) to more educational DVDs such as Bleeding Through Layers of Los Angeles, 1920-1986 by Norman Klein and the Labyrinth Project (2003). Although those projects are very different in terms of design style and depth of video storage, they both mediate a layered reality (Chris Markers memories and Los Angeles evolution in time) putting the user in the role of an explorer67.”

Y después de ofrecer este conjunto de ejemplos, lo justifica de la siguiente manera:

“Although the user is described as ‘active’ by most multimedia hypertexts authors (Simones, Rothuizen, Klein, Thalthofer et al.) one might question what ‘activity’ means for them. Followers of Michel de Certau’s Practice of Everyday Life will see in our daily choices an act of subjectivation and freedom but I am not sure that the choices given in a branching narrative have the same liberating effect that the one we do in a daily basis68.”

Según la autora, cuando uno explora una narrativa hipertextual, una gran parte de la motivación es la curiosidad de ver de qué trata todo esto. La hipótesis de la autora radica en este incentivo de mantener al usuario en el placer de la exploración, la curiosidad sobre los puntos de vista diferentes, o quizá, en un contexto documental, el deseo de aprender. Gaudenzi opina69 que las narrativas de ramificación son muy eficaces en un entorno de aprendizaje (cuando el usuario tiene una fuerte motivación para explorar el contenido), pero menos eficaces en un entorno narrativo (donde el usuario aún espera el liderazgo narrativo del autor y no lo encuentra en la lógica de las opciones). Todos estos proyectos tienen en común el intento de retratar una realidad de los hechos a través de un archivo de búsqueda o base de datos. La condición es que esta base de datos está cerrada, y no es ampliable por el autor ni por el usuario. La forma de explorar la base de datos es la forma hipertextual: a través de una palabra, un dibujo, una fotografía o una imagen en movimiento. La cineasta brasileña Nina Simoes llama a este tipo de documental interactivo “docufragmentary”70, definiéndolo como una base de datos de segmentos de vídeo controlados por un software que “invita a un espectador activo a reflexionar y a crear su propia red de conexiones”. El rol del autor es, pues, imaginar las ramificaciones narrativas y las normas de la vinculación dentro de una base de datos de un conjunto de textos (lexias, vídeos, fotos, etc.). El autor no es un facilitador como en el modo de conversación, sino un narrador que experimenta con niveles de opciones dentro de un marco narrativo controlado. Como acaba concluyendo Gaudenzi71, el modo de autostop no da ninguna garantía de llegar a su destino, ni de tener un viaje interesante, sino que la asunción básica se encuentra en el supuesto de que el viaje es la parte más importante de la experiencia, estimulada por el hecho de que el usuario disfruta de la construcción de su itinerario y su propia interpretación de la realidad.

A principios de los 90 una nueva tecnología se consolida de manera definitiva en el entorno interactivo, el World Wide Web. Conviene examinar la evolución experimentada por la red de internet y sus múltiples potencialidades de cara a las aplicaciones interactivas. Intentamos delimitar en este apartado el contexto en que se enmarca este nuevo formato interactivo, por lo que haremos una primera aproximación, desde los inicios de la red hasta el momento actual, del que destacaremos como factor clave la convergencia tecnológica. El documental interactivo es un formato que utiliza diferentes soportes para su exhibición y navegación: por un lado, los soportes fuera de línea y, por otro, el soporte por excelencia en línea, la red o internet. Pero tampoco hay que olvidar otros soportes, como las instalaciones interactivas, las tecnologías móviles o la televisión. Hay que remarcar que, sobre todo hacia el final del siglo pasado, los soportes fuera de línea, como el CD-ROM o el DVD-ROM, dejaron casi de utilizarse, ya que la red incorporaba algunos factores clave que permitieron este abandono progresivo de los soportes fuera de línea y una masiva migración hacia la red como soporte único. Una parte de estos factores clave fueron la conexión de banda ancha, la tarifa plana o los nuevos programas que permitían animar y programar a la vez (como Flash, de la compañía Macromedia entonces y de Adobe ahora). Este apartado pretende exponer el contexto sobre el que se desarrolla la mayor parte de documentales interactivos existentes, que no es otro que la red actual o internet, y el modelo colaborativo actual o la Web 2.0.

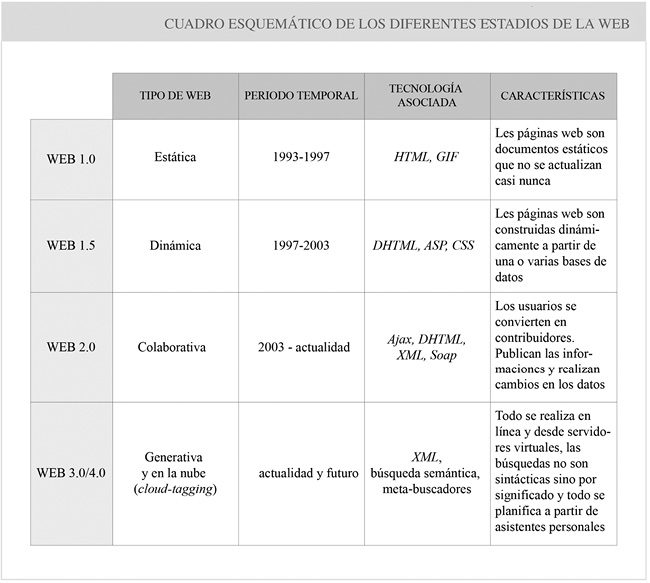

En el informe llamado De la Web 2.0 a la Web 3.0: nuevos modelos de negocio y oportunidades empresariales en la red del futuro (2009), elaborado por la Unidad de Análisis y Prospectiva del Observatorio de Mercados Exteriores, se menciona que internet se ha convertido actualmente en el medio más importante para acceder a la información y al conocimiento. Se prevé que en el año 2017 haya siete mil millones de aparatos con acceso a internet y, a medida que las economías emergentes comprueben el impacto positivo que internet tiene en todos los sectores económicos, se añadirán aún más usuarios y servicios. A continuación se ofrece una división de cuatro etapas o estadios por los que ha pasado o se espera que transite internet desde su creación:

En general, cuando citamos el término Web 2.0, nos referimos a una serie de aplicaciones que se encuentran incluidas en un tipo de páginas web que utilizan una inteligencia colectiva, con el fin de proporcionar servicios interactivos en red y dotar al usuario de un control sobre la circulación de sus datos. La primera y la evolución más importante de la Web 2.0 es la redifusión del contenido de una página web a partir de protocolos estandarizados, que permiten que los usuarios utilicen el contenido de la web en otros contextos, ya sea en otra web, en una aplicación de escritorio o a través de una conexión del navegador. Como comenta Codina (2009), “la Web 1.0 era más bien de lectura y las páginas eran estáticas, y en la 2.0 son de lectura y escritura y con páginas dinámicas con contenidos abiertos”. En la Web 2.0 cualquiera puede crear contenido, por eso es evidente que la democratización de la información en la edición queda más patente que en el paradigma de web anterior. En la versión 2.0 hay una cierta apropiación social de internet.

De las características citadas más propias de la web, como el acceso a los contenidos y la información en diferentes formatos, la recopilación y su almacenamiento, la interconexión de uno a los otros (a través del hipertexto) y la posibilidad de creación, la que se ve más potenciada precisamente es esta última. Aunque esta característica no se encontraba completamente excluida en la Web 1.0, sí se encontraba limitada a ciertos sectores. Los contenidos, la información y la creación fluyen de una forma más sustancial en los formatos 2.0, sobre todo en cantidad, porque en la versión 1.0 estos contenidos y su creación se encuentran en buena medida condicionados a la disposición y al deseo de los administradores del sitio web. En suma, en la Web 1.0 hay participación como consumidores, mientras que en la Web 2.0 esta tendencia inicial se consolida y añadimos la de productores y creadores. Como comenta Hugo Pardo en su libro Planeta Web 2.0. Inteligencia colectiva o medios fast food (2007):

“En esta nueva web la red digital deja de ser una simple vidriera de contenidos multimedia para convertirse en una plataforma abierta, construida sobre una arquitectura basada en la participación de los usuarios. Alrededor del concepto Web 2.0 giran una serie de términos-satélite que retroalimentan su evolución. Software social, arquitectura de la participación, contenidos generados por el usuario, rich internet applications, etiquetas, sindicación de contenidos y redes sociales, son solo algunos en la larga lista de conceptos que enriquecen este fenómeno73”.

Según Cobo y Pardo74, el término Web 2.0 se puede considerar como uno más de los conceptos en un escenario caracterizado por una obsolescencia terminológica ya planificada. Su virtud, de acuerdo con los autores citados, es su capacidad para describir con precisión y síntesis un tipo de tecnología y sus productos derivados. En cuanto a la utilización de otras posibles terminologías, comentan:

“Al hacer el ejercicio práctico de buscar sinónimos que engloben los principios constitutivos de las recientes aplicaciones web, sucede que muchos quedan relegados por no ser inclusivos de todas sus propiedades. Si se habla de “redes sociales”, vemos que se trata de un conjunto mayor a las aplicaciones web y que existen cientos de ellas que no respetan todos los principios recién mencionados (cualquier intranet, por ejemplo). De hecho, la propia internet es la madre de todas las redes sociales en línea y las aplicaciones Web 2.0 son solo un pequeño subconjunto de ese mundo virtual. Algo similar sucede con la idea de escritura colaborativa y content management system: ambas características son propiedades esenciales, pero no representan a la totalidad de principios constitutivos75”.

Con el objetivo de dar cierta entidad teórica al nuevo término y acabar con la confusión del momento en que surgió, Tim O’Reilly publicó en septiembre del 2005 lo que hasta hoy ha sido la referencia bibliográfica principal del concepto. Nos referimos al artículo“What Is Web 2.0. Design Patterns and Business Models for the Next Generation of Software”. En este artículo, O’Reilly presenta una fundamentación teórica consistente en el desarrollo de un conjunto de ideas que habían tomado forma unos años atrás. La entrada en escena de Napster, en 1999, el lanzamiento de las primeras aplicaciones para la publicación de blogs (ese mismo año aparece blogger, y a principios del 2001, Movable Type, su principal competidor), y la creación de Wikipedia, a principios del año 2001, se erigieron como los paradigmas de esta transformación, y al tiempo generaron las bases de la escritura colaborativa y otros principios de la Web 2.0. Según el mismo O’Reilly, la caída del índice Nasdaq, en el año 2000, fue el detonante que marcó el inicio de la transición de la tecnología Web 1.0 a la 2.0. En cuanto al el momento de transición de una tecnología a otra, Pardo comenta:

“No obstante, al margen de debates semióticos, es evidente que el World Wide Web actual no es igual a la web que existía en el 2000, y que aplicaciones de diferente calado y capacidad de relación usuario-herramienta conviven entre sí para darle mayor riqueza a la web. En ese momento, escasas aplicaciones ofrecían espacios abiertos de acceso, escritura y producción de contenidos de valor añadido en forma gratuita. La base de participación de los anteriores productos era muy limitada: correos del staff, formularios de contacto y poco más. Hoy existe un entorno virtual de convivencia entre aplicaciones estándares con escasa interactividad y otras de escritura colaborativa. Pero la web en su conjunto empieza a dibujar un nuevo escenario de contenidos y metainformación en plena transformación hacia los principios de la Web 2.076”.

En síntesis, el concepto de Web 2.0 se refiere a una segunda generación de páginas webs basadas en comunidades de usuarios y una gama especial de servicios, como las redes sociales, los blogs, las wikis o las folcsonomías, que fomentan la colaboración, elaboración y el intercambio ágil de información entre los usuarios, donde el estatismo de las páginas pasa a transformarse en una matriz de interacción del usuario con la red, lo que le permite introducir su información en el sistema. En general, cuando nos referimos a la Web 2.0, nos referimos a un conjunto de aplicaciones y páginas de internet que utilizan la inteligencia colectiva para proporcionar servicios interactivos en red que otorgan el control de los datos al propio usuario. Tal como argumenta Wade Roush77, periodista especializado en las tecnologías de la información y miembro del Technology Review del MIT78, un organismo considerado una autoridad en el futuro de la tecnología, el término 2.0 se refiere principalmente a tres aspectos:

Para profundizar sobre el fenómeno global llamado Web 2.0, es muy interesante el libro de Paul Anderson What is Web 2.0? Ideas, technologies and implications for education (2007), donde plantea las ideas y los conceptos clave para entender qué representa la Web 2.0. El autor lo entiende como una consecuencia lógica de la primera etapa (Web 1.0), y no tanto como un concepto superior. Lo justifica argumentando que Tim Berners-Lee, el padre del World Wide Web, había planteado la navegación en internet de manera que los usuarios pudieran editar los contenidos, como pasará más adelante con el fenómeno Wiki, por ejemplo. Debido a los problemas de velocidad y conexión que ello suponía, renunció a ello, y de manera natural se convirtió en la gran revolución de internet unos años más tarde.

La Web 4.0 se empieza a plantear como una realidad futura, en que los sistemas operativos y los programas locales dejarán de existir o coexistirán con los programas en los servidores. Si tenemos en cuenta los parámetros de la ley de Moore81, la velocidad de acceso será mucho más rápida, los componentes mucho más pequeños y los gadgets personales digitales tendrán una inteligencia casi humana82. Para cerrar este contexto, exponemos dos cuadros esquemáticos: el primero resume los diferentes tipos de web, el periodo temporal que abarcan, la tecnología asociada y las características de cada tipo. El segundo ofrece una distribución dividida en cuatro cuadrantes, referentes a la evolución de internet hasta el 2020 (web, web social, web semántica y web ubicua).

2.7 Cuadro esquemático que resume los diferentes tipos de web, el periodo temporal que comprenden, la tecnología asociada y las características

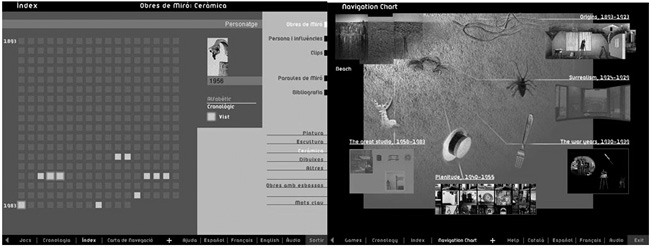

En el ámbito concreto de la difusión cultural interactiva de este tipo de productos, se ha dado ya una experiencia de exploración de las posibilidades del discurso interactivo de un interés extraordinario, y en muchos casos nos encontramos con productos que ya podemos incluir dentro de la familia de los documentales interactivos. Durante la década de 1990 se fue desarrollando un tipo de discurso que cada vez utilizaba de manera más audaz las características del medio interactivo para documentar una situación concreta. El soporte en ese momento eran los CD-ROM, y los productos más significativos se produjeron en Estados Unidos y en varios países europeos, muy especialmente en Francia, donde las iniciativas de la Réunion des Musées Nationaux (RMN) propiciaron la aparición de varias empresas (Voyager, Montparnasse Multimedia, Index+, Hyptique, etc.) que fueron desarrollando productos cada vez más interesantes.

La opinión mayoritaria optimista en las primeras décadas de desarrollo de los ordenadores giraba alrededor de las utopías de la inteligencia artificial. Pensadores ilustres como Turing o Minsk la sostenían. Frente a ellos, unos pocos visionarios, como Nelson y Engelbart, empezaban a apuntar las posibilidades del ordenador como soporte de un nuevo y extraordinario medio de comunicación83. Es especialmente interesante la clarividente opinión de Alan Kay en 1977, mientras dirigía en el Xerox Park el desarrollo del Dynabook, un “medio personal dinámico”, verdadero prototipo del ordenador personal. Kay tenía ya una clara idea de que la principal función del ordenador sería la de sostener un nuevo medio de comunicación:

“Although digital computers were originally designed to do Arithmetic Computation, the ability to simulated the details of any descriptive model, means that the computer, viewed as a medium itself, can be all other media if the embedding and viewing methods are sufficiently well provided84”.

El trabajo y las ideas de estos líderes penetraron en la sociedad a partir de los primeros ordenadores Macintosh, en los que influyeron por contacto directo y, en general, a través del desarrollo de las interfaces gráficas de usuario. Durante la década de los años 1990, al final de la cual los ordenadores personales eran capaces de reproducir vídeos de calidad razonable, la conciencia del ordenador como medio de comunicación había penetrado ya en el inconsciente colectivo. Los primeros productos de los CD-ROM de difusión cultural, realizados aproximadamente entre los años 1990 y 1994, se ejecutaban en una ventana más del sistema operativo, estaban rodeados de su escritorio, las carpetas y su papelera, ofrecían a menudo recursos del sistema (Copy, Print, etc.) y situaban en consecuencia al usuario en un entorno de trabajo en el que utilizaba una herramienta. Un buen ejemplo de esta aproximación es Microsoft Art Gallery85, una aplicación desarrollada en 1991 para la National Gallery londinense y distribuida en 1994.

A mediados de los años 90, el paradigma informático fue sustituido por el cinematográfico, la herramienta por el medio, la ventana por la pantalla y el recurso por la atracción. La primera edición del CD-ROM del Louvre, Le Louvre86, controlaba todo el sistema, ponía la pantalla en negro y comenzaba con unos inmersivos títulos de crédito acompañados de música. Esta sería la norma en la mayor parte de productos de este tipo a partir de entonces. Los CD-ROM de la segunda mitad de la década de 1990 empezaron a desarrollar formas expresivas intrínsecas del medio interactivo. Como propiedad común, todos estos casos se caracterizaban por utilizar creativamente las formas intrínsecas del medio, todos ellos aportaban nuevas formas de relacionar los diferentes medios entre sí y con la gestión de la acción. Algunas de las causas más decisivas de este no reconocimiento se derivaron directamente de la complejidad de la propia tecnología de los CD-ROM. Su adecuado funcionamiento requería un ordenador multimedia no siempre estándar, el uso de programas específicos y la realización de procesos de instalación complicados. Todo ello les hacía extraordinariamente susceptibles a todo tipo de errores, incluso con posterioridad a las primeras sesiones de funcionamiento. Solo usuarios muy convencidos y con destreza informática podían finalmente acceder al disfrute del discurso interactivo contenido en el CD-ROM. Si ya es difícil en cualquier propuesta de tipo cultural llegar a interesar a una cantidad suficiente de personas para poder establecer una “cultura” propia, en este caso la dificultad se multiplicaba hasta la frontera de la imposibilidad.

The Criterion Collection87 es una empresa de vídeo-distribución de venta de “películas clásicas y contemporáneas importantes” para los aficionados al cine, fundada en 1984 por Robert Stein, Aleena Stein y Joe Medjuck, a los que más tarde se unió Roger Smith. En 1985, los hermanos Stein, William Becker, y Jonathan B. Turell fundaron la Voyager Company, sección encargada de publicar educativos multimedia en CD-ROM (1989-2000). Durante su existencia, el Criterion Collection se convirtió en una división subordinada de la Compañía Voyager. Durante la primera mitad de los 90, y coincidiendo con el auge de la producción comercial del CD-ROM interactivo, algunos de los títulos más ampliamente elogiados y de mayor venta fueron lanzados por la empresa Voyager, la cual los produjo desde 1984 hasta 1997. Con un buen puñado de títulos líderes, mostraron un nivel constante de innovación en el diseño creativo, combinado con lo que el formato tecnológicamente podía ofrecer. Por estas razones, la producción de la Voyager es de especial valor para los historiadores y conservadores de los medios digitales. Sin embargo, al igual que todos los medios digitales, la compañía Voyager se ha enfrentado a desafíos grandes debido a la rápida evolución de los sistemas operativos y el software.

La primera gran sensación de Voyager la causó a mediados del decenio de 1980 con sus discos láser Criterion Collection: se trataba de transferencias de alta calidad de películas clásicas en las que generalmente se incluían extras como pistas de comentarios, galerías, etc., es decir, todas las características que más tarde serían de uso obligado en los productos audiovisuales de consumo, y factores clásicos que complementan los documentales tradicionales a partir de la interactividad hoy en día.