Cómo el rendimiento de las unidades de disco satisface las necesidades del mercado

por Joseph L. Bower7 y Clayton M. Christensen8

Uno de los fenómenos más repetidos en el mundo de los negocios es el fracaso de las empresas líderes para mantenerse en la cima de sus industrias cuando las tecnologías o los mercados cambian. Goodyear y Firestone entraron muy tarde en el mercado de los neumáticos radiales. Xerox dejó que Canon creara el mercado de las fotocopiadoras pequeñas. Bucyrus-Erie permitió que Caterpillar y Deere se hicieran con el mercado de las excavadoras mecánicas. Sears dio paso a Walmart. El patrón de fracaso ha sido especialmente llamativo en la industria informática. IBM dominó el mercado de los ordenadores centrales, pero se perdió durante años la aparición de los miniordenadores, que eran tecnológicamente mucho más simples que los centrales. Digital Equipment dominó el mercado de los miniordenadores con innovaciones como su arquitectura VAX, pero perdió el mercado de los ordenadores personales casi por completo. Apple Computer lideró el mundo de la informática personal y estableció el estándar de la informática de fácil uso, pero se quedó cinco años atrás respecto a los líderes en la introducción de sus ordenadores portátiles en el mercado.

¿Por qué empresas como estas invierten agresivamente —y con éxito— en las tecnologías necesarias para retener a sus clientes actuales, pero luego no realizan otras inversiones tecnológicas que exigirán los clientes del futuro? Sin duda, la burocracia, la arrogancia, el cansancio de los ejecutivos, la mala planificación y los horizontes de inversión a corto plazo han desempeñado un papel. Pero una razón más fundamental se encuentra en el corazón de la paradoja: las empresas líderes sucumben a uno de los dogmas de gestión más populares y valiosos. Se mantienen aferradas a sus clientes.

Aunque a la mayoría de los directivos les gusta pensar que tienen el control, los clientes ejercen un poder extraordinario a la hora de dirigir las inversiones de una empresa. Antes de que los directivos decidan lanzar una tecnología, desarrollar un producto, construir una planta o establecer nuevos canales de distribución, deben mirar primero a sus clientes: ¿Lo quieren sus clientes? ¿Qué tamaño tendrá el mercado? ¿Será rentable la inversión? Cuanto más astutamente se planteen y respondan los directivos a estas preguntas, más se ajustarán sus inversiones a las necesidades de sus clientes.

Así es como debería funcionar una empresa bien gestionada. ¿No es así? Pero, ¿qué ocurre cuando los clientes rechazan una nueva tecnología, un concepto de producto o una forma de hacer negocios porque no responde a sus necesidades con la misma eficacia que el enfoque actual de la empresa? Los grandes centros de fotocopiado que representaban el núcleo de la base de clientes de Xerox al principio no tenían ninguna utilidad para las pequeñas y lentas fotocopiadoras de mesa. Los contratistas de excavación que habían confiado en las palas de cable de vapor y diésel de Bucyrus-Erie no querían excavadoras hidráulicas porque inicialmente eran pequeñas y débiles. Los grandes clientes comerciales, gubernamentales e industriales de IBM no vieron ninguna utilidad inmediata a los miniordenadores. En todos los casos, las empresas escucharon a sus clientes, les dieron el rendimiento del producto que buscaban y, al final, se vieron perjudicadas por las mismas tecnologías que sus clientes les hicieron ignorar.

Hemos observado este patrón repetidamente en un estudio de empresas líderes en una diversidad de industrias que se han enfrentado al cambio tecnológico. La investigación muestra que la mayoría de las empresas bien gestionadas y establecidas están constantemente a la cabeza de sus sectores en el desarrollo y la comercialización de nuevas tecnologías —desde mejoras incrementales hasta enfoques radicalmente nuevos— siempre que esas tecnologías respondan a las necesidades de rendimiento de la próxima generación de sus clientes. Sin embargo, estas mismas empresas rara vez están en la vanguardia de la comercialización de nuevas tecnologías que no satisfacen inicialmente las necesidades de los clientes principales y solo atraen a los mercados pequeños o emergentes.

Utilizando los procesos de inversión racionales y analíticos que la mayoría de las empresas bien gestionadas han desarrollado, es casi imposible construir un argumento convincente para desviar recursos de las necesidades conocidas de los clientes en mercados establecidos a mercados y clientes que parecen insignificantes o que todavía no existen. Al fin y al cabo, satisfacer las necesidades de los clientes establecidos y defenderse de los competidores requiere todos los recursos de los que dispone una empresa, y más. En las empresas bien gestionadas, los procesos utilizados para identificar las necesidades de los clientes, prever las tendencias tecnológicas, evaluar la rentabilidad, asignar los recursos entre las propuestas de inversión que compiten entre sí y sacar nuevos productos al mercado se centran —por todas las razones correctas— en los clientes y mercados actuales. Estos procesos están diseñados para descartar las propuestas de productos y tecnologías que no responden a las necesidades de los clientes.

De hecho, los procesos e incentivos que las empresas utilizan para mantenerse centradas en sus clientes principales funcionan tan bien que les impiden ver nuevas tecnologías importantes en los mercados emergentes. Muchas empresas han aprendido «por las malas» el peligro de ignorar las nuevas tecnologías que no satisfacen inicialmente las necesidades de los clientes principales. Por ejemplo, aunque los ordenadores personales no satisfacían las necesidades de los usuarios habituales de miniordenadores a principios de los años 80, la potencia de cálculo de las máquinas de sobremesa mejoró a un ritmo mucho más rápido que las demandas de potencia de cálculo de los usuarios de miniordenadores. Como resultado, los ordenadores personales se pusieron a la altura de las necesidades informáticas de muchos de los clientes de Wang, Prime, Nixdorf, Data General y Digital Equipment. Hoy en día compiten en rendimiento con los miniordenadores en muchas aplicaciones. Para los fabricantes de miniordenadores, mantenerse cerca de los clientes principales e ignorar lo que inicialmente eran tecnologías de escritorio de bajo rendimiento utilizadas por clientes aparentemente insignificantes en los mercados emergentes fue una decisión racional, pero que resultó desastrosa.

Los cambios tecnológicos que perjudican a las empresas establecidas no suelen ser radicalmente nuevos ni difíciles desde el punto de vista tecnológico. Sin embargo, tienen dos características importantes. En primer lugar, suelen presentar un paquete diferente de atributos de rendimiento que, al menos al principio, no son valorados por los clientes existentes. En segundo lugar, los atributos de rendimiento que los clientes existentes sí valoran mejoran a un ritmo tan rápido que la nueva tecnología puede invadir posteriormente esos mercados establecidos. Solo en ese momento los clientes habituales querrán la tecnología. Por desgracia, para los proveedores establecidos, a menudo es demasiado tarde: los pioneros de la nueva tecnología dominan el mercado.

De ello se deduce que los altos ejecutivos deben, en primer lugar, ser capaces de detectar las tecnologías que parecen entrar en esta categoría. A continuación, para comercializar y desarrollar las nuevas tecnologías, los directivos deben protegerlas de los procesos e incentivos orientados a servir a los clientes establecidos. Y la única manera de protegerlas es crear organizaciones completamente independientes de la empresa principal.

Ninguna industria demuestra de forma más dramática el peligro de permanecer demasiado cerca de los clientes que la industria de los discos duros. Entre 1976 y 1992, el rendimiento de las unidades de disco mejoró a un ritmo asombroso: el tamaño físico de un sistema de 100 megabytes (MB) se redujo de 5.400 a 8 pulgadas cúbicas, y el coste por MB bajó de 560 a 5 dólares. Aproximadamente la mitad de la mejora provino de una serie de avances radicales que fueron fundamentales para la mejora continua del rendimiento de las unidades de disco; la otra mitad provino de avances incrementales.

El modelo de la industria de las unidades de disco se ha repetido en muchas otras industrias. Las empresas líderes y establecidas han liderado constantemente la industria en el desarrollo y adopción de nuevas tecnologías que sus clientes demandaban, incluso cuando esas tecnologías requerían competencias tecnológicas y capacidades de fabricación completamente diferentes a las que tenían esas empresas. A pesar de esta agresiva postura tecnológica, ningún fabricante de unidades de disco ha sido capaz de dominar la industria durante más de unos pocos años. Una serie de empresas se han introducido en el negocio y han alcanzado el liderazgo, y luego han sido derribadas por los recién llegados que perseguían tecnologías que al principio no satisfacían las necesidades de los clientes mayoritarios. El resultado es que ninguna de las empresas independientes de discos que existían en 1976 sobrevive en la actualidad.

Para explicar las diferencias en el impacto de ciertos tipos de innovaciones tecnológicas en una industria determinada, el concepto de trayectorias de rendimiento —el ritmo al que el rendimiento de un producto ha mejorado, y se espera que mejore, con el tiempo— puede ser útil. Casi todos los sectores tienen una trayectoria crítica de rendimiento. En las excavadoras mecánicas, la trayectoria crítica es la mejora anual en metros cúbicos de tierra movidos por minuto. En las fotocopiadoras, una trayectoria de rendimiento importante es la mejora en el número de copias por minuto. En las unidades de disco, una medida crucial del rendimiento es la capacidad de almacenamiento, que ha avanzado de media un 50 % cada año para un tamaño determinado de unidad.

Los distintos tipos de innovaciones tecnológicas afectan a las trayectorias de rendimiento de diferentes maneras. Por un lado, las tecnologías sustentadoras tienden a mantener un ritmo de mejora; es decir, dan a los clientes algo más o mejor en los atributos que ya valoran. Por ejemplo, los componentes de película fina en las unidades de disco, que sustituyeron a los cabezales convencionales de ferrita y a los discos de óxido entre 1982 y 1990, permitieron grabar la información con mayor densidad en los discos. Los ingenieros habían estado ampliando los límites del rendimiento que podían obtener de los cabezales de ferrita y los discos de óxido, pero las unidades que empleaban estas tecnologías parecían haber alcanzado los límites naturales de una curva S. En ese momento, surgieron nuevas tecnologías de película fina que restablecieron —o mantuvieron— la trayectoria histórica de mejora del rendimiento.

Por otro lado, las tecnologías disruptivas introducen un paquete de atributos muy diferente al que los clientes convencionales valoran históricamente, y a menudo funcionan mucho peor en una o dos dimensiones que son particularmente importantes para esos clientes. Por lo general, los clientes convencionales no están dispuestos a utilizar un producto disruptivo en aplicaciones que conocen y comprenden. Por tanto, al principio, las tecnologías disruptivas tienden a ser utilizadas y valoradas solo en nuevos mercados o nuevas aplicaciones; de hecho, suelen hacer posible la aparición de nuevos mercados. Por ejemplo, las primeras radios de transistores de Sony sacrificaban la fidelidad del sonido, pero crearon un mercado de radios portátiles al ofrecer un paquete nuevo y diferente de atributos: tamaño pequeño, peso ligero y portabilidad.

En la historia de la industria de los discos duros, los líderes tropezaron en cada momento de cambio tecnológico disruptivo: cuando el diámetro de las unidades de disco se redujo de las 14 pulgadas originales a 8 pulgadas, luego a 5,25 pulgadas y finalmente a 3,5 pulgadas. Cada una de estas nuevas arquitecturas ofrecía inicialmente al mercado una capacidad de almacenamiento sustancialmente inferior a la que necesitaba el usuario típico del mercado establecido. Por ejemplo, la unidad de 8 pulgadas ofrecía 20 MB cuando se introdujo, mientras que el principal mercado de unidades de disco en ese momento —los mainframes— requería 200 MB de media. No es de extrañar que los principales fabricantes de ordenadores rechazaran al principio la arquitectura de 8 pulgadas. En consecuencia, sus proveedores, cuyos productos principales consistían en unidades de 14 pulgadas con más de 200 MB de capacidad, no se dedicaron a los productos disruptivos de forma agresiva. El patrón se repitió cuando aparecieron las unidades de 5,25 y 3,5 pulgadas: los fabricantes de ordenadores establecidos rechazaron las unidades por considerarlas inadecuadas y, a su vez, sus proveedores de unidades de disco también las ignoraron.

Pero, aunque ofrecían menos capacidad de almacenamiento, las arquitecturas disruptivas crearon otros atributos importantes: fuentes de alimentación internas y menor tamaño (unidades de 8 pulgadas); tamaño aún más pequeño y motores paso a paso de bajo coste (unidades de 5,25 pulgadas); y robustez, peso ligero y bajo consumo de energía (unidades de 3,5 pulgadas). Desde finales de la década de 1970 hasta mediados de la de 1980, la disponibilidad de las tres unidades hizo posible el desarrollo de nuevos mercados para los miniordenadores, los PC de sobremesa y los ordenadores portátiles, respectivamente.

Aunque las unidades más pequeñas representaban un cambio tecnológico disruptivo, cada una de ellas era tecnológicamente sencilla. De hecho, hubo ingenieros en muchas empresas líderes que defendieron las nuevas tecnologías y construyeron prototipos de trabajo antes de que la dirección diera el visto bueno formal. Aun así, las empresas líderes no pudieron trasladar los productos a través de sus organizaciones y al mercado de manera oportuna. Cada vez que surgía una tecnología disruptiva, entre la mitad y las dos terceras partes de los fabricantes establecidos no introducían modelos con la nueva arquitectura, lo que contrastaba con la puntualidad con la que lanzaban las tecnologías de mantenimiento críticas. Las empresas que finalmente lanzaron nuevos modelos solían ir dos años por detrás de las empresas entrantes, lo que supone una eternidad en una industria cuyos ciclos de vida de los productos suelen ser de dos años. Tres olas de empresas entrantes lideraron estas revoluciones; primero capturaron los nuevos mercados y luego destronaron a las empresas líderes en los mercados principales.

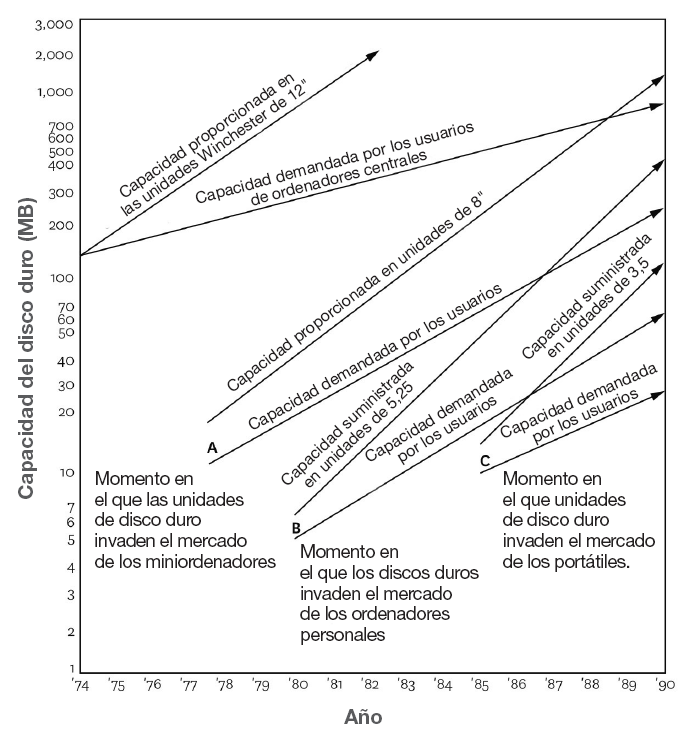

¿Cómo es posible que tecnologías inicialmente inferiores y útiles solo para los nuevos mercados acaben amenazando a las empresas líderes en los mercados establecidos? Una vez que las arquitecturas disruptivas se establecieron en sus nuevos mercados, las innovaciones de apoyo aumentaron el rendimiento de cada arquitectura a lo largo de trayectorias ascendentes, tan ascendentes que el rendimiento disponible de cada arquitectura pronto satisfizo las necesidades de los clientes en los mercados establecidos. Por ejemplo, la unidad de 5,25 pulgadas, cuya capacidad inicial de 5 MB en 1980 era solo una fracción de la capacidad que necesitaba el mercado de los miniordenadores, llegó a ser totalmente competitiva en rendimiento en el mercado de los miniordenadores en 1986 y en el mercado de los mainframes en 1991. (Véase la figura 3.1.)

Las estructuras de ingresos y costes de una empresa desempeñan un papel fundamental en la forma de evaluar las innovaciones tecnológicas propuestas. Por lo general, las tecnologías disruptivas parecen poco atractivas desde el punto de vista financiero para las empresas establecidas. Los ingresos potenciales de los mercados discernibles son pequeños y suele ser difícil proyectar el tamaño de los mercados de la tecnología a largo plazo. En consecuencia, los directivos suelen concluir que la tecnología no puede contribuir de forma significativa al crecimiento de la empresa y, por tanto, que no merece la pena el esfuerzo de gestión necesario para desarrollarla. Además, las empresas consolidadas suelen haber instalado estructuras de costes más elevadas para atender a las tecnologías sostenibles que las requeridas por las tecnologías disruptivas. En consecuencia, los directivos suelen considerar que tienen dos opciones a la hora de decidir si persiguen las tecnologías disruptivas. Una es ir a la baja y aceptar los menores márgenes de beneficio de los mercados emergentes a los que las tecnologías disruptivas servirán inicialmente. La otra es ir hacia arriba con tecnologías de mantenimiento y entrar en segmentos de mercado cuyos márgenes de beneficio son muy atractivos. (Por ejemplo, los márgenes de los mainframes de IBM siguen siendo superiores a los de los ordenadores personales.) Cualquier proceso racional de asignación de recursos en las empresas que sirven a los mercados establecidos elegirá ir hacia arriba en lugar de ir hacia abajo.

Los directivos de las empresas que han defendido las tecnologías disruptivas en los mercados emergentes ven el mundo de forma muy diferente. Sin las elevadas estructuras de costes de sus homólogas establecidas, estas empresas encuentran atractivos los mercados emergentes. Una vez que las empresas se han afianzado en los mercados y han mejorado el rendimiento de sus tecnologías, los mercados establecidos por encima de ellas, atendidos por proveedores de alto coste, parecen apetecibles. Cuando atacan, las empresas entrantes se encuentran con que los actores establecidos son oponentes fáciles y poco preparados, porque han estado mirando hacia arriba, descartando la amenaza desde abajo.

Es tentador detenerse en este punto y concluir que se ha aprendido una valiosa lección: los directivos pueden evitar perderse la próxima ola prestando mucha atención a las tecnologías potencialmente disruptivas que no satisfacen las necesidades de los clientes actuales. Pero reconocer el patrón y averiguar cómo romperlo son dos cosas diferentes. Aunque los entrantes invadieron los mercados establecidos con nuevas tecnologías tres veces seguidas, ninguno de los líderes establecidos en la industria de los discos duros pareció aprender de las experiencias de los que cayeron antes que ellos. La miopía de los directivos o la falta de previsión no pueden explicar estos fracasos. El problema es que los directivos siguen haciendo lo que ha funcionado en el pasado: servir a las necesidades en rápido crecimiento de sus clientes actuales. Los procesos que las empresas exitosas y bien gestionadas han desarrollado para asignar recursos entre las inversiones propuestas son incapaces de canalizar recursos hacia programas que los clientes actuales no quieren explícitamente y cuyos márgenes de beneficio parecen poco atractivos.

La gestión del desarrollo de nuevas tecnologías está estrechamente vinculada a los procesos de inversión de una empresa. La mayoría de las propuestas estratégicas —para aumentar la capacidad o desarrollar nuevos productos o procesos— toman forma en los niveles inferiores de las organizaciones, en grupos de ingeniería o equipos de proyectos. A continuación, las empresas utilizan sistemas analíticos de planificación y presupuestación para seleccionar entre los candidatos que compiten. Las propuestas de creación de nuevas empresas en mercados emergentes son especialmente difíciles de evaluar porque dependen de estimaciones notoriamente poco fiables del tamaño del mercado. Dado que los directivos son evaluados por su capacidad para hacer las apuestas correctas, no es de extrañar que en las empresas bien gestionadas los directivos de nivel medio y alto respalden proyectos en los que el mercado parece asegurado. Al mantenerse cerca de los clientes principales, como han sido entrenados para hacerlo, los directivos centran los recursos en cumplir los requisitos de aquellos clientes fiables a los que se puede servir de forma rentable. El riesgo se reduce —y las carreras se salvaguardan— al dar a los clientes conocidos lo que quieren.

La experiencia de Seagate Technology ilustra las consecuencias de confiar en estos procesos de asignación de recursos para evaluar tecnologías disruptivas. Desde cualquier punto de vista, Seagate, con sede en Scotts Valley (California), fue una de las empresas más exitosas y mejor gestionadas de la historia de la industria microelectrónica. Desde su creación en 1980, los ingresos de Seagate habían crecido hasta superar los 700 millones de dólares en 1986. Fue pionera en la fabricación de discos duros de 5,25 pulgadas y el principal proveedor de IBM y de los fabricantes de ordenadores personales compatibles con IBM. La empresa era el principal fabricante de discos de 5,25 pulgadas en el momento en que surgieron las disruptivas unidades de 3,5 pulgadas a mediados de la década de 1980.

Los ingenieros de Seagate fueron los segundos de la industria en desarrollar prototipos de unidades de 3,5 pulgadas. A principios de 1985, habían fabricado más de 80 modelos de este tipo con un bajo nivel de financiación de la empresa. Los ingenieros enviaron los nuevos modelos a los principales ejecutivos de marketing y la prensa especializada informó de que Seagate estaba desarrollando activamente unidades de 3,5 pulgadas. Pero los principales clientes de Seagate —IBM y otros fabricantes de ordenadores personales de clase AT— no mostraron interés en las nuevas unidades. Querían incorporar unidades de 40 y 60 MB en sus modelos de próxima generación, y los primeros prototipos de 3,5 pulgadas de Seagate solo contenían 10 MB. En respuesta, los ejecutivos de marketing de Seagate redujeron sus previsiones de ventas de las nuevas unidades de disco.

Los directivos financieros y de fabricación de la empresa señalaron otro inconveniente de las unidades de 3,5 pulgadas. Según su análisis, las nuevas unidades nunca serían competitivas con la arquitectura de 5,25 pulgadas en términos de coste por megabyte, una métrica importante que los clientes de Seagate utilizaban para evaluar las unidades de disco. Dada la estructura de costes de Seagate, los márgenes de los modelos de 5,25 pulgadas de mayor capacidad prometían ser mucho mayores que los de los productos más pequeños.

Los altos directivos decidieron de forma bastante racional que la unidad de 3,5 pulgadas no proporcionaría el volumen de ventas y los márgenes de beneficio que Seagate necesitaba de un nuevo producto. Un antiguo ejecutivo de marketing de Seagate recordaba: «Necesitábamos un nuevo modelo que pudiera convertirse en el siguiente ST412 [una unidad de 5,25 pulgadas que generaba más de 300 millones de dólares en ventas anuales y que se acercaba al final de su ciclo de vida]. En ese momento, todo el mercado de las unidades de 3,5 pulgadas era inferior a 50 millones de dólares. La unidad de 3,5 pulgadas simplemente no encajaba en el mercado, ni en ventas ni en beneficios».

El estancamiento de la unidad de 3,5 pulgadas fue una señal de que Seagate no estaba satisfecha con la innovación. Posteriormente, Seagate introdujo nuevos modelos de unidades de 5,25 pulgadas a un ritmo acelerado y, al hacerlo, introdujo una impresionante serie de mejoras tecnológicas sostenibles, a pesar de que su introducción dejó obsoleta una parte importante de su capacidad de fabricación.

Mientras la atención de Seagate se centraba en el mercado de los ordenadores personales, los antiguos empleados de Seagate y de otros fabricantes de discos de 5,25 pulgadas, frustrados por los retrasos de sus empleadores en el lanzamiento de discos de 3,5 pulgadas, fundaron una nueva empresa, Conner Peripherals. Conner se centró en la venta de sus unidades de 3,5 pulgadas a empresas de mercados emergentes de ordenadores portátiles y productos de sobremesa de tamaño reducido (PC que ocupan menos espacio en un escritorio). El principal cliente de Conner era Compaq Computer, un cliente al que Seagate nunca había servido. La propia prosperidad de Seagate, junto con el enfoque de Conner en clientes que valoraban diferentes atributos de las unidades de disco (robustez, volumen físico y peso), minimizaron la amenaza que Seagate veía en Conner y sus unidades de 3,5 pulgadas. Sin embargo, Conner, desde su posición de cabeza en el emergente mercado de los ordenadores portátiles, mejoró la capacidad de almacenamiento de sus unidades en un 50 % al año. A finales de 1987, las unidades de 3,5 pulgadas tenían la capacidad que exigía el mercado general de los ordenadores personales. En ese momento, los ejecutivos de Seagate lanzaron la unidad de 3,5 pulgadas, introduciéndola en el mercado como respuesta defensiva al ataque de empresas entrantes como Conner y Quantum Corporation, la otra pionera de las unidades de 3,5 pulgadas. Pero era demasiado tarde.

Para entonces, Seagate se enfrentaba a una fuerte competencia. Durante un tiempo, la empresa pudo defender su mercado actual vendiendo unidades de 3,5 pulgadas a su base de clientes establecida: fabricantes y distribuidores de ordenadores personales de tamaño normal. De hecho, gran parte de sus productos de 3,5 pulgadas siguieron enviándose en marcos que permitían a sus clientes montar las unidades en ordenadores diseñados para alojar unidades de 5,25 pulgadas. Pero, al final, Seagate solo pudo luchar para convertirse en un proveedor de segundo nivel en el nuevo mercado de los ordenadores portátiles.

Por el contrario, Conner y Quantum obtuvieron una posición dominante en el nuevo mercado de ordenadores portátiles y luego utilizaron su escala y experiencia en el diseño y fabricación de productos de 3,5 pulgadas para expulsar a Seagate del mercado de ordenadores personales. En 1994, los ingresos combinados de Conner y Quantum superaron los 5.000 millones de dólares.

El mal momento de Seagate tipifica las respuestas de muchas empresas establecidas a la aparición de tecnologías disruptivas. Seagate estaba dispuesta a entrar en el mercado de las unidades de 3,5 pulgadas solo cuando fuera lo suficientemente grande como para satisfacer las necesidades financieras de la empresa, es decir, solo cuando los clientes existentes quisieran la nueva tecnología. Seagate ha sobrevivido gracias a su inteligente adquisición del negocio de unidades de disco de Control Data Corporation (CDC) en 1990. Con la base tecnológica de CDC y la experiencia de Seagate en la fabricación de volúmenes, la empresa se ha convertido en un poderoso actor en el negocio del suministro de unidades de gran capacidad para ordenadores de gama alta. Sin embargo, Seagate se ha reducido a una sombra de lo que fue en el mercado de los ordenadores personales.

No debería sorprender que pocas empresas, cuando se enfrentan a tecnologías disruptivas, hayan sido capaces de superar las desventajas del tamaño o del éxito. Pero se puede hacer. Hay un método para detectar y cultivar las tecnologías disruptivas.

El primer paso es decidir cuáles de las innumerables tecnologías que se vislumbran en el horizonte son disruptivas y, de entre ellas, cuáles son verdaderas amenazas. La mayoría de las empresas tienen procesos bien concebidos para identificar y seguir el progreso de las tecnologías potencialmente sostenibles, porque son importantes para atender y proteger a los clientes actuales. Pero pocas tienen procesos sistemáticos para identificar y seguir las tecnologías potencialmente disruptivas.

Un enfoque para identificar las tecnologías disruptivas es examinar los desacuerdos internos sobre el desarrollo de nuevos productos o tecnologías. ¿Quién apoya el proyecto y quién no? Los directores de marketing y financieros, debido a sus incentivos de gestión y financieros, rara vez apoyarán una tecnología disruptiva. Por otro lado, el personal técnico con un historial sobresaliente a menudo persistirá en argumentar que surgirá un nuevo mercado para la tecnología, incluso frente a la oposición de los clientes clave y del personal de marketing y financiero. El desacuerdo entre los dos grupos suele indicar que se trata de una tecnología disruptiva que los directivos de alto nivel deberían explorar.

El siguiente paso es formular a las personas adecuadas las preguntas correctas sobre la importancia estratégica de la tecnología disruptiva. Las tecnologías disruptivas tienden a estancarse en las primeras revisiones estratégicas porque los directivos hacen las preguntas equivocadas o hacen las preguntas correctas a las personas equivocadas. Por ejemplo, las empresas establecidas tienen procedimientos regulares para preguntar a los clientes principales —especialmente a las cuentas importantes donde se prueban realmente las nuevas ideas— para evaluar el valor de los productos innovadores. Por lo general, estos clientes se seleccionan porque son los que más se esfuerzan por adelantarse a sus competidores en el impulso de las prestaciones de sus productos. Por tanto, es muy probable que estos clientes exijan el máximo rendimiento a sus proveedores. Por esta razón, los clientes principales son fiablemente precisos cuando se trata de evaluar el potencial de las tecnologías sostenibles, pero son fiablemente inexactos cuando se trata de evaluar el potencial de las tecnologías disruptivas. Son las personas equivocadas a las que hay que preguntar.

Un sencillo gráfico en el que se representa en el eje vertical el rendimiento de los productos, tal y como se define en los mercados principales, y el tiempo, en el eje horizontal, puede ayudar a los directivos a identificar tanto las preguntas correctas como las personas adecuadas a las que preguntar. En primer lugar, dibuje una línea que represente el nivel de rendimiento y la trayectoria de mejora del rendimiento que los clientes han disfrutado históricamente y que probablemente esperen en el futuro. A continuación, localice el nivel de rendimiento inicial estimado de la nueva tecnología. Si la tecnología es disruptiva, el punto estará muy por debajo del rendimiento exigido por los clientes actuales. (Véase la figura 3.2.)

¿Cuál es la pendiente probable de mejora del rendimiento de la tecnología disruptiva en comparación con la pendiente de mejora del rendimiento que exigen los mercados existentes? Si los tecnólogos entendidos creen que la nueva tecnología puede progresar más rápido que la demanda de mejora de rendimiento del mercado, entonces esa tecnología, que no satisface las necesidades de los clientes hoy, puede muy bien satisfacerlas mañana. La nueva tecnología, por tanto, es estratégicamente crítica.

En lugar de adoptar este enfoque, la mayoría de los directivos se hacen las preguntas equivocadas. Comparan la tasa prevista de mejora del rendimiento de la nueva tecnología con la de la tecnología establecida. Si la nueva tecnología tiene el potencial de superar a la establecida, el razonamiento es que deben ponerse a desarrollarla.

Bastante sencillo. Pero este tipo de comparación, aunque es válida para las tecnologías de mantenimiento, pasa por alto la cuestión estratégica central de la evaluación de las tecnologías potencialmente disruptivas. Muchas de las tecnologías disruptivas que estudiamos nunca superaron la capacidad de la tecnología antigua. Lo importante es la trayectoria de la tecnología disruptiva comparada con la del mercado. Por ejemplo, la razón por la que el mercado de los ordenadores centrales se está reduciendo no es que los ordenadores personales superen a los centrales, sino que los ordenadores personales conectados en red con un servidor de archivos satisfacen eficazmente las necesidades informáticas y de almacenamiento de datos de muchas organizaciones. Los fabricantes de ordenadores mainframe se tambalean no porque el rendimiento de la tecnología de los ordenadores personales supere al de los mainframe, sino porque se cruza con el rendimiento exigido por el mercado establecido.

Consideremos de nuevo el gráfico. Si los tecnólogos creen que la nueva tecnología progresará al mismo ritmo que la demanda de mejora del rendimiento del mercado, la tecnología disruptiva puede tardar más en invadir los mercados establecidos. Recordemos que Seagate tenía como objetivo la informática personal, donde la demanda de capacidad de disco duro por ordenador crecía un 30 % al año. Como la capacidad de las unidades de 3,5 pulgadas mejoraba a un ritmo mucho más rápido, los principales fabricantes de discos de 3,5 pulgadas pudieron expulsar a Seagate del mercado. Sin embargo, otros dos fabricantes de discos de 5,25 pulgadas, Maxtor y Micropolis, se habían dirigido al mercado de las estaciones de trabajo de ingeniería, en el que la demanda de capacidad de disco duro era insaciable. En ese mercado, la trayectoria de la capacidad demandada era esencialmente paralela a la trayectoria de mejora de la capacidad que los tecnólogos podían suministrar en la arquitectura de 3,5 pulgadas. En consecuencia, entrar en el negocio de las unidades de 3,5 pulgadas era estratégicamente menos importante para esas empresas que para Seagate.

Una vez que los directivos han determinado que una nueva tecnología es disruptiva y estratégicamente crítica, el siguiente paso es localizar los mercados iniciales para esa tecnología. El estudio de mercado, la herramienta en la que tradicionalmente han confiado los directivos, rara vez resulta útil. En el momento en que una empresa necesita hacer una apuesta estratégica por una tecnología disruptiva, no existe un mercado concreto. Cuando Edwin Land pidió a los investigadores de mercado de Polaroid que evaluaran las ventas potenciales de su nueva cámara, llegaron a la conclusión de que Polaroid vendería apenas 100.000 cámaras a lo largo de la vida del producto; pocas personas a las que entrevistaron podían imaginar los usos de la fotografía instantánea.

Dado que las tecnologías disruptivas suelen señalar la aparición de nuevos mercados o segmentos de mercado, los directivos deben obtener información sobre dichos mercados: quiénes serán los clientes, qué dimensiones del rendimiento del producto serán las más importantes para cada cliente, cuáles serán los precios adecuados. Los directivos solo pueden crear este tipo de información experimentando de forma rápida, iterativa y económica tanto con el producto como con el mercado.

Para las empresas establecidas es muy difícil emprender tales experimentos. Los procesos de asignación de recursos que son fundamentales para la rentabilidad y la competitividad no dirigirán —y no deberían hacerlo— recursos a mercados en los que las ventas serán relativamente pequeñas. Entonces, ¿cómo puede una empresa establecida sondear un mercado para una tecnología disruptiva? Deje que sean las empresas de nueva creación —ya sea las que financia la propia empresa o las que no tienen ninguna relación con ella— las que lleven a cabo los experimentos. Las organizaciones pequeñas son buenas para hacer apuestas económicas, seguir las tendencias y cambiar ágilmente las estrategias de producto y de mercado en respuesta a las reacciones de las primeras incursiones en el mercado.

(sigue en pág. 73)

¿Es la innovación inversa como la innovación disruptiva?

por Vijay Govindarajan y Chris Trimble

En el número de octubre de 2009 de Harvard Business Review, publicamos el artículo «How GE Is Disrupting Itself» (Cómo GE se está perturbando a sí misma), en coautoría con Jeff Immelt, entonces presidente y consejero delegado de General Electric. El artículo presenta el fenómeno de la innovación inversa. Desde esa introducción, varias personas nos han preguntado por la relación entre la innovación inversa y la innovación disruptiva, tal y como la define Clay Christensen.

Existe un solapamiento entre la innovación inversa y la innovación disruptiva, pero no una relación de uno a uno. En otras palabras, algunos ejemplos de innovación inversa, pero no todos, son también ejemplos de innovación disruptiva.

Una innovación inversa, de forma muy sencilla, es cualquier innovación que probablemente se adopta primero en el mundo desarrollado. Se llama así porque históricamente casi todas las innovaciones se han adoptado primero en los países ricos. En nuestro artículo, argumentamos que la innovación inversa será cada vez más común y que representa un formidable desafío organizativo para las multinacionales con sede en el mundo rico. También explicamos un modelo organizativo para superar ese reto.

Una innovación disruptiva tiene una dinámica particular que pone en peligro a los actores establecidos. El producto del operador tradicional tiene dos dimensiones principales de mérito, A y B. (Por ejemplo, A podría ser la calidad y B podría ser la velocidad de entrega.) Los clientes de la corriente principal están interesados principalmente en A, pero hay un conjunto minoritario de clientes que valora más B que A. La innovación disruptiva, en su lanzamiento, es débil en A pero fuerte en B. Como tal, solo atrae a la minoría. Como los clientes mayoritarios no la quieren, las empresas establecidas tienden a ignorar al nuevo participante y la nueva tecnología. Pero con el tiempo, la tecnología mejora y la innovación es cada vez mejor en A. Finalmente, satisface las necesidades de los clientes mayoritarios en la dimensión A y, dado que también dan cierto valor a B, empiezan a elegir el nuevo producto. El operador tradicional se ve repentinamente perturbado, ya que siempre ha ignorado la nueva tecnología.

En el famoso estudio de Christensen sobre la industria de las unidades de disco, A era la capacidad de la unidad de disco y B era el tamaño de la unidad de disco. Christensen demostró que los nuevos participantes perturbaron repetidamente a los ya existentes al introducir unidades de disco más pequeñas con menor capacidad. Al principio, los clientes mayoritarios no estaban interesados. Necesitaban más memoria, no menos. Pero, con el tiempo, la capacidad de las unidades de disco más pequeñas fue aumentando hasta que los clientes mayoritarios se interesaron por ellas.

Entonces, ¿cuál es la relación entre la innovación inversa y la innovación disruptiva?

Vemos tres situaciones principales que crean la posibilidad de una innovación inversa. Solo la primera es también una ilustración de la innovación disruptiva.

La primera situación se debe a la diferencia de ingresos entre los países ricos y los países en desarrollo. Como la renta per cápita es tan baja en el mundo en desarrollo, las condiciones son propicias para las innovaciones que ofrecen una calidad decente a un precio ultrabajo, es decir, una solución del 50 % a un precio del 5 %. Al principio, la solución del 50 % es poco atractiva en el mundo rico, pero con el tiempo, el rendimiento aumenta hasta el punto de ser atractivo en el mundo rico. Se trata claramente de una historia de innovación disruptiva, en la que A es el rendimiento o la calidad y B es el precio.

La segunda se debe a la diferencia de infraestructuras entre los países ricos y los países en desarrollo. La mayor parte de las infraestructuras (energía, transporte, telecomunicaciones, etc.) del mundo en desarrollo aún no se han construido. Por ello, la demanda de nuevas tecnologías de infraestructura es mucho mayor en el mundo en desarrollo que en el mundo rico, donde la demanda de infraestructura se crea principalmente por la necesidad de sustituir la infraestructura existente. Esto no es un ejemplo de innovación disruptiva.

La tercera situación se debe a la brecha de sostenibilidad entre los países ricos y los países en desarrollo. Muchas naciones en desarrollo se enfrentan a limitaciones medioambientales mucho antes en su camino de desarrollo económico que las naciones ricas. Las tecnologías de desalinización, por ejemplo, probablemente se adopten en lugares como el norte de África antes de que el suroeste desértico de Estados Unidos las necesite. Esto tampoco es un ejemplo de innovación disruptiva.

Ya sea que una innovación sea inversa, disruptiva o ambas, es difícil de ejecutar para una organización establecida. En el caso de las innovaciones inversas, las empresas deben superar la resistencia a trasladar el poder y el control fuera de la sede central, y deben estar dispuestas a remodelar los modelos organizativos y las expectativas de los equipos del país. En el caso de las innovaciones disruptivas, las empresas deben superar la resistencia inicial a dar prioridad a una inversión que no interesa a los clientes habituales. Y, aunque inviertan, deben superar el miedo a que el nuevo producto acabe canibalizando el negocio existente.

(viene de la pág. 70)

Pensemos en Apple Computer en sus inicios. El producto original de la empresa, el Apple I, fue un fracaso cuando se lanzó en 1977. Pero Apple no había hecho una gran apuesta por el producto y había conseguido que al menos algo estuviera en manos de los primeros usuarios rápidamente. La empresa aprendió mucho del Apple I sobre la nueva tecnología y sobre lo que los clientes querían y no querían. Igual de importante es que un grupo de clientes aprendió lo que querían y lo que no querían de los ordenadores personales. Con esta información, Apple lanzó el Apple II con bastante éxito.

Muchas empresas podrían haber aprendido las mismas valiosas lecciones observando de cerca a Apple. De hecho, algunas empresas siguen una estrategia explícita de ser las segundas en inventar, permitiendo que los pequeños pioneros abran el camino hacia un territorio de mercado inexplorado. Por ejemplo, IBM dejó que Apple, Commodore y Tandy definieran el ordenador personal. A continuación, se introdujo agresivamente en el mercado y creó un considerable negocio de ordenadores personales.

Pero el relativo éxito de IBM al entrar tarde en un nuevo mercado es la excepción, no la regla. Con demasiada frecuencia, las empresas que tienen éxito someten los resultados de los pioneros de los mercados pequeños a las mismas normas financieras que aplican a sus propios resultados. En un intento de asegurarse de que están utilizando bien sus recursos, las empresas establecen explícita o implícitamente umbrales relativamente altos para el tamaño de los mercados en los que deberían considerar entrar. Este enfoque les condena a realizar entradas tardías en mercados que ya están llenos de actores poderosos.

Por ejemplo, cuando surgió la unidad de 3,5 pulgadas, Seagate necesitaba un producto de 300 millones de dólares al año para sustituir a su maduro modelo estrella de 5,25 pulgadas, el ST412, y el mercado de 3,5 pulgadas no era lo suficientemente grande. Durante los dos años siguientes, cuando la prensa especializada preguntaba cuándo presentaría Seagate su unidad de 3,5 pulgadas, los ejecutivos de la empresa respondían sistemáticamente que aún no había mercado. En realidad, había un mercado, y estaba creciendo rápidamente. Las señales que Seagate recogía sobre el mercado, influidas por los clientes que no querían unidades de 3,5 pulgadas, eran engañosas. Cuando Seagate introdujo finalmente su unidad de 3,5 pulgadas en 1987, ya se habían vendido 750 millones de dólares en unidades de 3,5 pulgadas. La información sobre el tamaño del mercado estaba ampliamente disponible en toda la industria. Pero no era lo suficientemente convincente como para cambiar el enfoque de los directivos de Seagate. Siguieron mirando el nuevo mercado a través de los ojos de sus clientes actuales y en el contexto de su estructura financiera actual.

La postura de los principales fabricantes de discos de hoy en día ante la nueva tecnología disruptiva, las unidades de 1,8 pulgadas, es inquietantemente familiar. Cada uno de los líderes de la industria ha diseñado uno o más modelos de estas pequeñas unidades, y los modelos están en las estanterías. Su capacidad es demasiado pequeña para ser utilizada en ordenadores portátiles, y nadie sabe aún dónde estará el mercado inicial de las unidades de 1,8 pulgadas. Las máquinas de fax, las impresoras y los sistemas de cartografía del salpicadero de los automóviles son candidatos. «No hay mercado», se queja un ejecutivo del sector. «Tenemos el producto y la fuerza de ventas puede recibir pedidos. Pero no hay pedidos porque nadie lo necesita. Simplemente se queda ahí». Este ejecutivo no ha considerado el hecho de que su fuerza de ventas no tiene ningún incentivo para vender las unidades de 1,8 pulgadas en lugar de los productos de mayor margen que vende a clientes de mayor volumen. Y aunque las unidades de 1,8 pulgadas están en las estanterías de su empresa y de otras, el año pasado se vendieron unidades de 1,8 pulgadas por valor de más de 50 millones de dólares, casi todas ellas por parte de empresas emergentes. Este año, se calcula que el mercado será de 150 millones de dólares.

Para evitar que las pequeñas empresas pioneras dominen los nuevos mercados, los ejecutivos deben supervisar personalmente la información disponible sobre el progreso de las empresas pioneras mediante reuniones mensuales con tecnólogos, académicos, inversores de capital riesgo y otras fuentes de información no tradicionales. No pueden confiar en los canales tradicionales de la empresa para calibrar los mercados porque esos canales no fueron diseñados para ese fin.

La estrategia de formar pequeños equipos en proyectos de skunkworks (diseño avanzado de productos) para aislarlos de las asfixiantes exigencias de las organizaciones principales es ampliamente conocida, pero poco comprendida. Por ejemplo, aislar a un equipo de ingenieros para que desarrolle una tecnología radicalmente nueva solo porque esa tecnología es radicalmente diferente es un error de aplicación fundamental del enfoque skunkworks. Gestionar fuera de contexto también es innecesario en el inusual caso de que una tecnología disruptiva sea más atractiva financieramente que los productos existentes. Consideremos la transición de Intel de los chips de memoria dinámica de acceso aleatorio (DRAM) a los microprocesadores. El primer negocio de microprocesadores de Intel tenía un margen bruto mayor que el de su negocio de DRAM; en otras palabras, el proceso normal de asignación de recursos de Intel proporcionó naturalmente al nuevo negocio los recursos que necesitaba.9 La creación de una organización separada solo es necesaria cuando la tecnología disruptiva tiene un margen de beneficios inferior al del negocio principal y debe atender las necesidades exclusivas de un nuevo conjunto de clientes. CDC, por ejemplo, creó con éxito una organización a distancia para comercializar su unidad de 5,25 pulgadas. Hasta 1980, CDC era el principal proveedor independiente de unidades de disco gracias a su experiencia en la fabricación de unidades de 14 pulgadas para los fabricantes de ordenadores centrales. Cuando surgió la unidad de 8 pulgadas, CDC realizó un esfuerzo de desarrollo tardío, pero sus ingenieros fueron retirados repetidamente del proyecto para resolver problemas para los proyectos de 14 pulgadas, más rentables y prioritarios, dirigidos a los clientes más importantes de la empresa. Como resultado, CDC se retrasó tres años en el lanzamiento de su primer producto de 8 pulgadas y nunca llegó a captar más del 5 % de ese mercado.

Cuando llegó la generación de 5,25 pulgadas, CDC decidió que afrontaría el nuevo reto de forma más estratégica. La empresa asignó a un pequeño grupo de ingenieros y comercializadores de Oklahoma City (Oklahoma), lejos de los clientes de la organización, la tarea de desarrollar y comercializar un producto competitivo de 5,25 pulgadas. «Teníamos que lanzarlo en un entorno en el que todo el mundo se entusiasmara con un pedido de 50.000 dólares», recuerda un ejecutivo. «En Minneapolis, necesitabas un pedido de un millón de dólares para que alguien te hiciera caso.» CDC nunca recuperó la cuota del 70 % que había tenido en el mercado de las unidades de disco para mainframes, pero su operación en Oklahoma City se aseguró un rentable 20 % del mercado de alto rendimiento de 5,25 pulgadas. Si Apple hubiera creado una organización similar para desarrollar su asistente digital personal (PDA) Newton, quienes lo han declarado un fracaso podrían haberlo considerado un éxito. Al lanzar el producto, Apple cometió el error de actuar como si se tratara de un mercado establecido. Los directivos de Apple se adentraron en el proyecto de la PDA asumiendo que tenía que contribuir significativamente al crecimiento de la empresa. En consecuencia, investigaron exhaustivamente los deseos de los clientes y luego apostaron enormes sumas lanzando el Newton. Si Apple hubiera hecho una apuesta tecnológica y financiera más modesta y hubiera confiado el Newton a una organización del tamaño de la propia Apple cuando lanzó el Apple I, el resultado podría haber sido diferente. El Newton podría haber sido visto más ampliamente como un sólido paso adelante en la búsqueda de lo que los clientes realmente quieren. De hecho, en el año de su introducción se vendieron muchos más Newtons que los modelos de Apple I en el año de su introducción.

Las empresas establecidas solo pueden dominar los mercados emergentes creando pequeñas organizaciones del tipo que CDC creó en Oklahoma City. Pero, ¿qué deben hacer cuando el mercado emergente crece y se establece?

La mayoría de los directivos asumen que, una vez que una empresa derivada es comercialmente viable en un nuevo mercado, debe integrarse en la organización principal. Razonan que los costes fijos asociados a las actividades de ingeniería, fabricación, ventas y distribución pueden repartirse entre un grupo más amplio de clientes y productos.

Este enfoque puede funcionar con las tecnologías sostenibles; sin embargo, con las tecnologías disruptivas, tener la spin-off en la organización principal puede ser desastroso. Cuando las organizaciones independientes y las principales se unen para compartir recursos, inevitablemente surgen discusiones debilitantes sobre qué grupos obtienen qué recursos y sobre si hay que canibalizar los productos establecidos o cuándo. En la historia de la industria de las unidades de disco, todas las empresas que han intentado gestionar los negocios principales y los disruptivos dentro de una única organización han fracasado.

Sea cual sea el sector, una empresa está formada por unidades de negocio con una vida útil finita: las bases tecnológicas y de mercado de cualquier negocio acabarán desapareciendo. Las tecnologías disruptivas forman parte de ese ciclo. Las empresas que entienden este proceso pueden crear nuevos negocios para sustituir a los que inevitablemente deben morir. Para ello, las empresas deben dar rienda suelta a los gestores de las innovaciones disruptivas para que desarrollen todo el potencial de la tecnología, incluso si eso significa acabar con el negocio principal. Para que la empresa viva, debe estar dispuesta a ver morir a las unidades de negocio. Si no las elimina ella misma, lo harán los competidores.

La clave para prosperar en los puntos de cambio disruptivo no es simplemente asumir más riesgos, invertir a largo plazo o luchar contra la burocracia. La clave es gestionar tecnologías disruptivas estratégicamente importantes en un contexto organizativo en el que los pequeños pedidos crean energía, en el que son posibles las incursiones rápidas y de bajo coste en mercados poco definidos, y en el que los gastos generales son lo suficientemente bajos como para permitir obtener beneficios incluso en los mercados emergentes.

Los directivos de empresas establecidas pueden dominar las tecnologías disruptivas con un éxito extraordinario. Pero cuando pretenden desarrollar y lanzar una tecnología disruptiva que es rechazada por clientes importantes en el contexto de las finanzas de la empresa establecida, fracasan, no porque tomen decisiones equivocadas, sino porque toman las decisiones correctas para las circunstancias que están a punto de convertirse en historia.

___________________

7 Joseph L. Bower es profesor emérito Donald Kirk David de la Harvard Business School y coautor del artículo de HBR «Global Capitalism at Risk: What Are You Doing About It?» y del libro Capitalism at Risk (Harvard Business Review Press, 2011).

8 Clayton M. Christensen fue titular de la cátedra Kim B. Clark de Administración de Empresas en la Harvard Business School y colaborador habitual de la Harvard Business Review.

9 Robert A. Burgelman, «Fading Memories: A Process Theory of Strategic Business Exit in Dynamic Environments», Administrative Science Quarterly 39 (1994), pp. 24-56.