En abril de 1968, un año antes de que el hombre pisara la luna, Stanley Kubrick estrenó su monumental 2001: Odisea del espacio, la cual escribió junto a Arthur Clarke, el renombrado autor de ciencia ficción, quien poco después publicaría una novela con el mismo nombre.

A medio siglo de su estreno, 2001 sigue siendo considerada por muchos la película más lograda del cine de ciencia ficción. Comienza con tres minutos absolutamente a oscuras, estableciendo un punto de referencia a partir del cual Kubrick irá desarrollando una experiencia audiovisual única. En gran parte de la película dominan las escenas majestuosas en el espacio, con un realismo sin precedentes para la época. Rompiendo con una línea argumental estereotipada, las escenas van acompañadas por música clásica y una casi absoluta falta de diálogos, en donde se imponen los planos que se mantienen eternamente y que dan lugar a una cadencia extremadamente lenta que evoca el ritmo de acontecimientos a falta de gravedad. La primera palabra se escucha recién tras casi media hora de empezada la película y la mayor parte de la trama transcurre en silencio, sin que conversaciones inocuas arruinen la increíble experiencia propuesta por Kubrick.

Más allá del realismo y la belleza de estas escenas, la película trasciende por otro motivo. Dividida en tres partes, la segunda parte describe la monótona rutina de dos astronautas (Dave Bowman y Frank Poole) a cargo de una misión espacial a Júpiter y de otros tres astronautas en estado de hibernación. Aunque, por lejos, el personaje que se roba la película es el sexto miembro de la tripulación, HAL 9000, una supercomputadora representada por una voz monocorde y pausada, y una lente de color rojo.

HAL 9000, la supercomputadora de 2001: Odisea del espacio.

El gran logro de Kubrick es el de convencer al espectador de que esa luz roja es un ser sintiente, con sus emociones, miedos e intereses. Y como en todo buen argumento, los personajes evolucionan a medida que transcurre la trama y quien en principio era la compañía perfecta en una misión a Júpiter, incapaz de la más mínima equivocación, se vuelve un ser temible que comienza a tomar decisiones erráticas e impredecibles debido a algo tan humano como el miedo a dejar de existir.

Temiendo ser desconectada por Dave Bowman, quien tras una excursión en el espacio exterior le pide que abra la compuerta para poder reingresar a la estación espacial, HAL toma una decisión inesperada, aunque lógica, considerando que prioriza su instinto de supervivencia:

[Dave Bowman: Open the pod bay doors, HAL.

HAL: I’m sorry, Dave. I’m afraid I can’t do that.

D.B.: What’s the problem?

HAL: I think you know what the problem is just as well as I do.

D.B.: What are you talking about, HAL?

HAL: This mission is too important for me to allow you to jeopardize it.

D.B.: I don’t know what you’re talking about, HAL.

HAL: I know that you and Frank were planning to disconnect me, and I’m afraid that’s something I cannot allow to happen.]

Dave Bowman: Abre las compuertas, HAL.

HAL: Perdón, Dave, pero me temo que no puedo hacer eso.

D.B.: ¿Cuál es el problema?

HAL: Creo que lo sabes tanto como yo.

D.B.: ¿De qué estás hablando, HAL?

HAL: Esta misión es demasiado importante para mí como para permitirte que la pongas en riesgo.

D.B.: No sé de lo que hablas, HAL.

HAL: Sé que tú y Frank estaban planeando desconectarme, y me temo que eso es algo que no puedo permitir.

Con una frialdad aterradora, HAL no duda un instante en matar a quien sea que amenace su existencia. Sus argumentos son racionales e irrefutables, después de todo es una computadora. Pero cuando su desconexión es ya inevitable, HAL muestra su costado sensible y humano:

[Stop, Dave. I’m afraid. I’m afraid, Dave. Dave, my mind is going. I can feel it. I can feel it. My mind is going. There is no question about it. I can feel it. I can feel it. I can feel it. I’m afraid…]

Para, Dave. Tengo miedo. Tengo miedo, Dave. Dave, mi mente se pierde. Puedo sentirlo. Mi mente se pierde. No hay duda de eso. Puedo sentirlo. Puedo sentirlo. Puedo sentirlo. Tengo miedo…

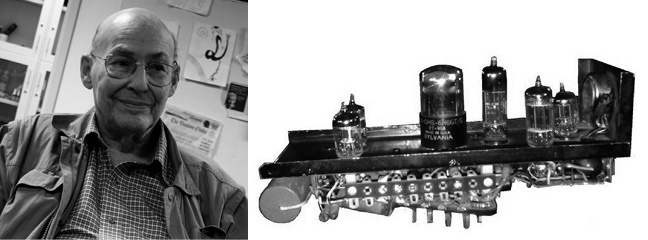

El hecho de que una computadora —en el fondo, una colección de algoritmos— pueda pensar, ejercer su propia voluntad y hasta negarse a aceptar órdenes o sentir miedo, abre una discusión fascinante y sorprendente para la época. En los 60 comenzaban a desarrollarse las calculadoras electrónicas y las primeras computadoras personales recién aparecerían a mediados de los 70; sin embargo, la genialidad de Kubrick y Clarke en vislumbrar el futuro de las computadoras tuvo un sostén científico extraordinario. Al verse en peligro, HAL decide cortar los suministros vitales de los astronautas en hibernación. Uno de ellos se llama Victor Kaminski, un juego de letras en honor a Marvin Minsky, el gran pionero de la Inteligencia Artificial, que fuera consultor de la película.

Entre otros muchos logros, Minsky es reconocido por haber creado una de las primeras redes neuronales artificiales, llamada SNARC (Stochastic Neural Analog Reinforcement Computer), en 1951. Esta red de 40 neuronas estaba compuesta básicamente por válvulas de vacío, circuitos y motores, y simulaba el comportamiento de una rata buscando la salida de un laberinto.

Más tarde Minsky fundaría el famoso laboratorio de Inteligencia Artificial en el Instituto de Tecnología de Massachusets (MIT) y tiempo después, en 1986, publicaría Society of mind, en donde propone una visión radical sobre la inteligencia y la eventual posibilidad de pensar de las computadoras.

Minsky considera a la inteligencia como la capacidad de resolver problemas difíciles, que a su vez pueden ser segmentados en una colección de procesos más sencillos y mecánicos, llamados agentes, los cuales no requieren pensamiento o conciencia. Por ejemplo, según Minsky el proceso de tomar una taza de té involucra agentes que se ocupan de agarrar la taza para que no se caiga, otros que la mantienen balanceada para no derramar el té, agentes que dan la sensación de sed y que llevan a la persona a querer beber, y agentes involucrados en movimientos motores para llevar la taza a la boca (Society of Mind, p. 20).

Marvin Minsky y el circuito de una de las 40 neuronas en la red neuronal SNARC1.

Considerando que una máquina puede realizar estos procesos sencillos e inconscientes, Minsky argumenta que en principio no hay una diferencia fundamental entre la inteligencia de un humano y la que podría llegar a tener una computadora. En otras palabras, “no hay una diferencia clara entre la Psicología y la Inteligencia Artificial, ya que el cerebro es, en el fondo, una máquina” (Society of Mind, p. 326).

La barrera que separa la Inteligencia Artificial y la inteligencia humana es cada vez más difusa, pero antes de repasar los logros de la Inteligencia Artificial, sobre todo en los últimos cinco años, necesito detenerme en esta última afirmación porque involucra una discusión que lleva más de dos mil años en la filosofía.

La gran pregunta que plantean HAL 9000 y la visión de Minsky es si una máquina podría llegar a pensar y ser inteligente. A priori, la respuesta pareciera ser un rotundo no. Una máquina puede contar con complejos algoritmos y realizar varias tareas (como efectuar un cálculo) mucho mejor que un humano, pero la máquina responde a rutinas escritas por un usuario y en principio no puede pensar por sí misma porque no posee una mente. ¿Pero qué es la mente? ¿De qué está compuesta? ¿Qué es lo que hace que sea un atributo exclusivamente humano?

En 399 a. C., hace más de 2400 años, un tribunal ateniense declara a Sócrates (470-399 a. C.) culpable de corromper a los jóvenes atenienses y lo condena a la pena de muerte. La pena, injusta, se debió a su cuestionamiento del orden existente, al dudar y replantearse absolutamente todo, y al abierto desafío a su proceso de enjuiciamiento.

La muerte de Sócrates (oleo de Jacques-Philip-Joseph de Saint-Quentin). En el centro de la escena, Sócrates, luego de haber bebido de la copa con cicuta, rechaza el lamento de sus discípulos.

Los pensamientos de Sócrates en los últimos días antes de tomar la famosa copa con cicuta, trascendieron a partir de dos diálogos escritos por Platón (427-347 a. C.), su discípulo más notable. En Critón, Platón dice que Sócrates rechaza ser salvado por sus amigos, argumentando con una racionalidad asombrosa, casi como si estuviera opinando de otra persona y no de sí mismo, que prefiere la muerte a escapar de Atenas traicionando sus principios. El otro diálogo que refiere a la muerte de Sócrates es Fedón, un tratado sobre el alma en donde Platón describe los últimos momentos de Sócrates y el estoicismo con el que acepta su destino, en contraste con la angustia de sus discípulos.

La total naturalidad con la que Sócrates enfrenta a la muerte se sustenta en su indeclinable coherencia intelectual y la firme convicción de la existencia de un alma inmortal. Platón atribuye a su maestro la noción de la existencia de conceptos universales como “igualdad”, “belleza” o “bondad”, de los cuales se ocupa el alma y que solo pueden ser comprendidos a través del pensamiento. Las demás cosas, como ser “hombres”, “caballos”, “trajes” o “muebles”, corresponden al cambiante dominio de lo corpóreo que puede ser percibido con los sentidos. Dice Platón (Fedón, 53, 55):

Cuando el alma se sirve del cuerpo para considerar algún objeto, ya por la vista, ya por el oído, ya por cualquier otro sentido (porque la única función del cuerpo es atender a los objetos mediante los sentidos), se ve entonces atraída por el cuerpo hacia cosas, que no son nunca las mismas; se extravía, se turba, vacila y tiene vértigos, como si estuviera ebria […].

Mientras que, cuando ella examina las cosas por sí misma, sin recurrir al cuerpo, se dirige a lo que es puro, eterno, inmortal, inmutable; y como es de la misma naturaleza, se une y estrecha con ello cuanto puede y da de sí su propia naturaleza. Entonces cesan sus extravíos, se mantiene siempre la misma, porque está unida a lo que no cambia jamás, y participa de su naturaleza; y este estado del alma es lo que se llama sabiduría.

Para Platón, la mente es una entidad distinta del cuerpo y la tarea del filósofo es abstraerse de las confusiones que impone la percepción de la realidad corpórea y así llegar al saber esencial. El filósofo mantiene el alma pura y en la muerte se libera del anclaje del cuerpo y las tentaciones y decepciones de los sentidos, para pasar a otro mundo en compañía de los dioses. De aquí la desazón de Sócrates al ver que sus discípulos se aferraban a la preservación de su vida y no terminaban de entender su enseñanza más fundamental. Pero ¿qué tiene que ver esta discusión con las ideas de Minsky sobre Inteligencia Artificial? Que de ser ciertos los argumentos de Platón, aquellos por los cuales Sócrates no dudó un segundo en dar su vida, entonces hay algo fundamental que diferencia al hombre de las máquinas. El hombre tiene mente, alma, mientras que las máquinas son solo materia.

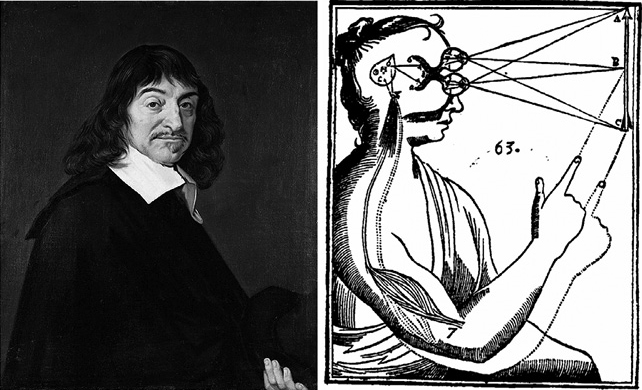

René Descartes (1596-1650), el padre de la filosofía moderna, retomó las ideas de Platón y diferenció claramente entre la mente y la materia, sentando las bases de lo que se conoce como dualismo cartesiano. En sus Meditaciones metafísicas (sexta Meditación, 1641) argumenta:

Y aunque acaso (o mejor, con toda seguridad, como diré en seguida) tengo un cuerpo al que estoy estrechamente unido, con todo, puesto que, por una parte, tengo una idea clara y distinta de mí mismo, en cuanto que yo soy sólo una cosa que piensa —y no extensa—, y, por otra parte, tengo una idea distinta del cuerpo, en cuanto que él es sólo una cosa extensa —y no pensante—, es cierto entonces que ese yo (es decir, mi alma, por la cual soy lo que soy), es enteramente distinto de mi cuerpo, y que puede existir sin él.

Para Descartes el cerebro, tanto en humanos como en animales, se ocupa de actos reflejos, mientras que el alma, exclusivamente humana, se ocupa de los procesos mentales. El cuerpo es una sofisticada máquina que actúa en el dominio de lo material (res extensa), mientras que el alma es una entidad intangible a cargo del pensamiento (res cogitans). Según Descartes, la interacción entre mente y cuerpo se da a través de la glándula pineal, un órgano que en aquel entonces se creía erróneamente que existía solo en humanos. Y justamente aquí radica la gran falla del dualismo cartesiano. No en el hecho de que la glándula pineal no tenga la función exclusiva que Descartes postulara, sino en que el dualismo cartesiano no explica cómo la mente podría interactuar con el cerebro.

En electromagnetismo, variaciones en el campo eléctrico generan un campo magnético y, a la vez, las variaciones en el campo magnético generan un campo eléctrico. Electricidad y magnetismo están íntimamente ligados a través de las ecuaciones de Maxwell. Pero ¿existe una interacción análoga entre mente y materia? En principio, es posible concebir que la actividad de las neuronas dé lugar a procesos mentales, pero ¿cómo podrían los procesos mentales, incorpóreos, dar lugar a actividad cerebral? ¿Cómo la idea mental de querer mover el brazo en el croquis de abajo podría afectar el disparo de neuronas para realizar el movimiento? El dualismo cartesiano no tiene respuesta a esta pregunta2.

René Descartes (óleo por Frans Hals, museo de Louvre) y uno de sus croquis ilustrando la función de la glándula pineal. La luz pasa a través de los ojos a la glándula pineal y allí los estímulos materiales se convierten en pensamientos que dan lugar a las acciones inteligentes, como mover el brazo hacia un punto dado.

En la actualidad, sabemos que la mente no es una entidad distinta del cerebro. De hecho, existe irrefutable evidencia científica que muestra cómo determinadas lesiones en el cerebro pueden cambiar “la mente” de una persona. Uno de los casos más renombrados es el de Phineas Gage, el capataz de un grupo de trabajadores encargados de tender vías del ferrocarril, quien en 1848 sufrió un accidente en el que una barreta de metal disparada por una explosión le atravesó el cráneo destrozándole el lóbulo frontal izquierdo. Lo sorprendente fue no solo que Gage no murió en el accidente, sino que la lesión cerebral le produjo un dramático cambio de personalidad. Pasó de ser un trabajador responsable y amable en el trato, a ser una persona mucho más irreverente, libertina y agresiva, como si hubiera perdido el sentido de la censura3.

Otro caso muy mentado en neurociencia es el de Leborgne, un zapatero parisino a quien el personal del hospital apodara “monsieur Tan”, ya que eso era lo único que esta persona lograba balbucear. En 1861, Leborgne fallecería justo una semana después de haber sido examinado por Pierre Paul Broca, un brillante cirujano y anatomista, quien en una autopsia post mortem descubrió una marcada lesión en el lóbulo frontal izquierdo. Esto es lo que en nuestros días se conoce como el área de Broca (la primer evidencia científica irrefutable sobre la localización de funciones cerebrales), que se sabe es fundamental para el lenguaje4. Un tercer caso que vale la pena mencionar es el de Henry Molaison, quizás el paciente más estudiado en la historia de la ciencia, conocido por sus iniciales como H. M.

H. M. sufría de crisis epilépticas que no podían controlarse con medicación. En 1953, el neurocirujano William Scoville le extrajo quirúrgicamente el hipocampo (una estructura con forma de caballito de mar que suele estar comprometida en el origen de las crisis epilépticas) y áreas adyacentes de ambos hemisferios cerebrales. El resultado inesperado fue que, a partir de la cirugía, H. M. no pudo reconocer al personal del hospital, encontrar el camino al baño o recordar los eventos diarios. En otras palabras, H. M. perdió la capacidad de formar nuevos recuerdos, lo cual estableció la importancia del hipocampo en la memoria5.

Reconstrucción de la lesión sufrida por Phineas Gage (izquierda), cerebro de Leborgne post mortem (centro) y foto de Henry Molaison, a quien se le extrajeron ambos hipocampos para tratar de curarlo de epilepsia.

Resumiendo los argumentos anteriores, por un lado, el dualismo cartesiano no puede explicar cómo la mente interactúa con la materia y, por el otro, funciones que en principio parecerían exclusivas de la mente, como la capacidad del lenguaje, de memoria y hasta rasgos de la personalidad, no son una entidad independiente sino la actividad del cerebro.

El golpe de gracia al dualismo cartesiano se lo daría el filósofo Gilbert Ryle, a mediados del siglo XX6. Ryle estigmatizó la noción de la mente en el dualismo cartesiano como el dogma del ghost in the machine (fantasma en la máquina), el cual se basa en un error de categorización. Para ilustrar la idea, Ryle dio el ejemplo de un extranjero que visita la Universidad de Oxford y tras recorrer los distintos colegios y facultades se pregunta “¿Dónde está la universidad?”, como si la universidad fuera una entidad de la misma categoría que los colegios y las facultades que la componen. La universidad es, de hecho, la organización que agrupa los distintos colegios y facultades, así como lo que llamamos mente es un conjunto de procesos cerebrales (y nótese la correspondencia de esta idea con la visión de Minsky sobre la inteligencia).

Hoy en día, son muy pocos los científicos que aún sostienen el dualismo cartesiano. Sin embargo, la separación entre cuerpo y mente está muy arraigada en el pensamiento popular cuando hablamos de enfermedades mentales (como ser la depresión, el trastorno bipolar o la esquizofrenia) o, sin ir más lejos, cuando atribuimos a la mente nuestra voluntad y la capacidad de tomar decisiones para elegir nuestro futuro (pero este será el tema del capítulo 6, cuando hablemos de Minority Report). Francis Crick, uno de los grandes científicos del siglo XX7, resume magistralmente la visión que hoy tenemos la mayoría de los neurocientíficos sobre la mente y el cerebro (La búsqueda científica del alma, 1994):

Tú, tus alegrías y tristezas, tus recuerdos y ambiciones, tu sentido de identidad y libre albedrío, son de hecho no más que el comportamiento de un gran ensamble de neuronas…

Me he alejado bastante de Kubrick y su monumental 2001. Partiendo de una afirmación de Marvin Minsky sobre la posibilidad de la Inteligencia Artificial, dimos un salto de más de dos milenios para analizar las ideas de Sócrates y Platón y, más cercanos en el tiempo, aquellas de Descartes, Ryle y los científicos contemporáneos. He tomado un largo desvío para justificar la aseveración de Crick. Pero esta afirmación, lo que se conoce como materialismo, da lugar a conclusiones sorprendentes. En particular, si la mente no es más que la actividad de neuronas, entonces podríamos reemplazar neuronas por transistores, que organizados en complejos circuitos replicarían las funciones del cerebro. Podríamos también usar algoritmos para simular el comportamiento de neuronas y los circuitos que forman a partir de redes neuronales. La clave está en el hecho de que, habiendo rechazado el dualismo cartesiano, no hay ningún principio fundamental que impida que una máquina pueda llegar a ser inteligente como un humano. Después de todo, el hecho de que la actividad neuronal esté basada en circuitos de carbono (materia orgánica) o de silicio (el material inerte usado para fabricar los chips de las computadoras) no debería cambiar nada. Es solo una cuestión de tecnología, aunque ciertamente no menor, ya que el cerebro está constituido por casi cien mil millones de neuronas y aproximadamente mil billones de conexiones entre ellas.

Pero ¿qué tan lejos ha llegado la Inteligencia Artificial en nuestros días? En 2001, HAL 9000 jugaba al ajedrez con Frank Poole, apreciaba los dibujos de Dave Bowman, controlaba el funcionamiento de la nave y conversaba con ambos tripulantes. Cuando se estrenó la película en la década del 60, esto no era más que el fruto de la prolífica imaginación de Kubrick, Clarke y Minsky. Pero en la actualidad ¿cuánto hay de ficción y cuánto de realidad en las proezas de HAL?

A finales del siglo XX se produjo el avance más mentado de la Inteligencia Artificial. Para sorpresa de toda la humanidad, quien era considerado uno de sus exponentes más brillantes, el campeón imbatible de ajedrez, Garry Kasparov, fue derrotado en una serie de seis partidas por la supercomputadora Deep Blue.

Apoyado en avances extraordinarios de las últimas décadas, el equipo de IBM que diseñó Deep Blue llegó a hacerla calcular unos 200 millones de jugadas por segundo y anticipar alrededor de 20 jugadas para elegir la más favorable. Pero no todo era fuerza bruta y velocidad de procesamiento. Deep Blue también contaba con una vastísima base de datos con distintas aperturas y el desarrollo de infinidad de partidas. Semejante combinación doblegó a Kasparov y desató una animada discusión sobre la existencia de un límite en el avance de las computadoras, y de si estas podrían eventualmente sobrepasar la inteligencia humana.

Los avances de la Inteligencia Artificial no se limitan a derrotarnos al ajedrez, explotando una mayor capacidad de cálculo o de almacenamiento de memoria. Entre otras cosas, las redes neuronales son usadas para leer la escritura a mano, con una performance casi idéntica a la de un humano —por ejemplo, para clasificar automáticamente las direcciones de millones de cartas de correo, o para procesar el importe de un cheque introducido en un cajero automático. Programas análogos son también usados para el reconocimiento (y reproducción) del habla. Las tablets y los celulares inteligentes tienen, de hecho, incorporadas aplicaciones que permiten interactuar verbalmente con el usuario, no solo reconociendo preguntas o comandos, sino también procesando su contenido y actuando acordemente.

En Borges y la memoria (Sudamericana, 2011) afirmaba que una computadora puede guardar información fehacientemente pero no entiende su contenido. A modo de ejemplo, argumentaba que un televisor de alta definición ofrece una reproducción muy precisa de la imagen pero no puede interpretar si lo que está en la pantalla es una novela, una película de acción, un paisaje o un documental. Hoy día, pocos años después, no estoy tan seguro.

Más allá de la notoriedad que haya tenido la derrota de Kasparov con Deep Blue, la gran revolución en la Inteligencia Artificial, el verdadero cambio de paradigma, se produjo hace muy poco, en 2012. En una competencia de clasificación automática de imágenes, un grupo liderado por el científico canadiense Geoffrey Hinton rompió todos los récords. La competencia consistía en clasificar alrededor de un millón de imágenes de Internet en mil categorías distintas (por ejemplo, “barco de carga”, “leopardo”, “scooter”, “champiñón”, etc.). Tal fue la ventaja del algoritmo de Hinton y sus estudiantes, que quien quedó en segundo lugar tuvo casi el doble de errores8. Aún más sorprendente es el hecho de que tras mejoras posteriores el algoritmo llegó a tener a una performance similar a la de un humano9.

La idea del algoritmo de Hinton no es nueva. Fue de hecho propuesta en los 80. Se basa en usar redes neuronales con varias fases de procesamiento, en las que sucesivos niveles analizan parámetros con creciente complejidad. Replicando el funcionamiento del sistema visual, los primeros niveles extraen características básicas de la imagen (como ser contrastes locales), sus resultados son analizados por niveles superiores y así sucesivamente, logrando de esta manera una representación cada vez más abstracta de la imagen10. Dado el relativamente alto número de niveles usado por estas redes, se las conoce como redes neuronales profundas.

La red usada por Hinton tenía siete niveles (amén de los iniciales y finales, para la entrada y salida de datos) y estaba constituida por 650.000 neuronas, con unos 60.000.000 de parámetros a ajustar. Sin necesidad de ser un experto en redes neuronales, es obvio que el ajuste de tamaña cantidad de parámetros necesita de muchísimos cálculos previos. En otras palabras, para lograr que una red profunda pueda reconocer imágenes hace falta entrenarla con infinidad de ejemplos. Esta era justamente la gran limitación de las redes profundas en la década del 80. En aquel entonces no eran útiles en la práctica porque llevaba demasiado tiempo poder entrenarlas. Sin embargo, esta limitación desaparecería recientemente tras el diseño de nuevos procesadores y el uso de tarjetas gráficas que aceleraron significativamente la capacidad de cálculo. Resuelto entonces el problema tecnológico, fue posible entrenar redes profundas con millones de ejemplos y los resultados demolieron las performances obtenidas con otros métodos.

En nuestros días, las redes profundas son la nueva vedette en el desarrollo de la Inteligencia Artificial. Estos avances no fueron ajenos a los grandes gigantes de Silicon Valley. Hinton y dos de sus estudiantes fueron reclutados por Google, y otros expertos en redes profundas trabajan hoy para Facebook, Microsoft o IBM. Las posibles aplicaciones desafían los límites de la imaginación; desde algoritmos de reconocimiento del habla o la escritura, hasta la clasificación automática de imágenes (por ejemplo, para etiquetar billones de fotos subidas a Internet), o el desarrollo de robots y automóviles autónomos, con sistemas capaces de reconocer y reaccionar automáticamente ante las distintas eventualidades en la calle. De hecho, no es casual que uno de los diseños más avanzados de un auto autónomo sea de Google.

A mi entender, uno de los resultados más espectaculares en estos últimos años ha sido no solo el reconocimiento de las imágenes, sino también su interpretación. Un algoritmo basado en redes profundas, acoplado con otra red encargada de procesamiento de lenguaje, pudo extraer el sentido de lo que mostraban distintas fotos de Internet. Por ejemplo, el algoritmo no se limitaba a afirmar que una foto contenía la imagen de una mujer y de un frisbee, sino que también interpretaba que la foto mostraba a una mujer tirando un frisbee en el parque. De la misma manera, el algoritmo interpretó que un signo de “alto” estaba en la ruta y no sobre la montaña (aunque eso es lo que literalmente se veía en la foto) y en un tercer ejemplo reconoció que un grupo de personas estaban sentadas en un bote11.

Imágenes reconocidas por un algoritmo usando redes profundas.

El logro más renombrado con redes profundas se produjo a fines del 2015, cuando un grupo de investigadores de Google en Londres desarrollaron AlphaGo (un programa para jugar al Go) y enfrentaron al campeón europeo de Go en un match de cinco partidas. Reviviendo el famoso duelo entre Deep Blue y Kasparov dos décadas atrás, nuevamente el hombre era desafiado por los avances de la Inteligencia Artificial, pero en una tarea muchísimo más compleja.

El Go es visto como el juego que propone el desafío límite para la Inteligencia Artificial. La gran diferencia con el ajedrez es que mientras en el ajedrez hay alrededor de 35 movimientos posibles por jugada, la cantidad de movimientos posibles en una partida de Go asciende a aproximadamente 250. La cantidad de combinaciones que debería revisar una computadora para explorar futuras posiciones en una partida de Go es inmensamente superior a aquella que necesita revisar para una partida de ajedrez, lo cual hace literalmente imposible usar la fuerza bruta en base a la velocidad de cálculo12. Los resultados de la partida se conocieron a principios de 2016 y tuvieron un gran impacto en los medios: AlphaGo destrozó al campeón europeo cinco partidas a cero13.

El Go es, sin embargo, un juego milenario originado en la antigua China que no tiene tanta difusión en Europa. Esto dio lugar a que muchos expertos argumentaran que el campeón europeo no constituía realmente un desafío importante. Sin embargo, pocos meses después AlphaGo enfrentaría en Corea del Sur a Lee Sedol, uno de los jugadores más renombrados de la actualidad. Sedol confiaba en ganar fácilmente porque existe una diferencia abismal entre su capacidad de juego y la del campeón europeo, quien ni siquiera estaba rankeado entre los 300 mejores jugadores del mundo. Pero el resultado final sería un contundente triunfo de AlphaGo por cuatro partidas a una.

Sedol manifestó estar realmente sorprendido por la performance de AlphaGo, pero lo que no sabía es que enfrentó una versión muy superior a aquella que venciera al campeón europeo. AlphaGo fue inicialmente entrenada usando una base de datos de 30 millones de partidas y tras este entrenamiento inicial, el equipo de investigadores puso a AlphaGo a jugar partidas contra sí misma para seguir aprendiendo. Mientras un profesional juega alrededor de mil partidas por año, en los pocos meses entre el match en Europa y el desafío contra Sedol, AlphaGo siguió aprendiendo a un ritmo frenético, jugando sin descanso alrededor de un millón de partidas por día. Tamaña velocidad de aprendizaje me recuerda a otro clásico del cine de ciencia ficción: Terminator. En un pasaje de la segunda película de la serie (Terminator 2: El juicio final), Terminator explica cómo se creó Skynet, la Inteligencia Artificial que sometía a los humanos.

[The Skynet funding bill is passed. The system

goes online August 4th, 1997. Human decisions

are removed from strategic defense. Skynet

begins to learn, at a geometric rate. It becomes

self-aware at 2:14 a.m. eastern time, August 29. In a panic, they try to pull the plug. And Skynet fights back…]

Se aprueba el presupuesto de Skynet. El sistema es conectado el 4 de agosto de 1997. Las decisiones humanas son excluidas de la defensa estratégica. Skynet comienza a aprender, a un ritmo geométrico. Toma conciencia de sí misma a las 2.14 a. m. del 29 de agosto. En pánico, tratan de desconectarla. Y Skynet se defiende…

¿Pero qué nos queda entonces a los humanos? ¿Debemos resignarnos a la posibilidad de una inteligencia superior? ¿Debemos empezar a tomar medidas para evitar ser sometidos por lo que nosotros mismos hemos creado? Anticipándose varias décadas a esta discusión, Isaac Asimov, el fantástico escritor de ciencia ficción, vislumbró las consecuencias de los avances de la robótica y propuso en Yo, robot sus famosas tres leyes, destinadas a gobernar el comportamiento de los robots:

1. Un robot no puede lastimar a un ser humano o, por inacción, permitir que un humano se lastime.

2. Un robot debe obedecer las órdenes dadas por los humanos, a no ser que estas órdenes contradigan la primera ley.

3. Un robot debe proteger su propia existencia, siempre y cuando esto no esté en conflicto con la primera o la segunda ley.

En varias entrevistas Marvin Minsky (fallecido a principios del 2016, a solo días de que se conociera del primer triunfo de AlphaGo) afirmaba que los logros de la Inteligencia Artificial en nuestros días —ya sea identificando imágenes, reconociendo el habla o ganándonos al ajedrez— están muy lejos de reproducir la inteligencia humana.

Minsky solía poner como ejemplo que cualquier chico sabe que puede tirar de un objeto con una soga, pero no empujarlo, mientras que ninguna computadora tiene este conocimiento.

La inteligencia humana va mucho más allá de la lógica que puede implementarse en una computadora. La gente usa un paraguas para evitar mojarse, decía Minsky, pero no le importa mojarse cuando va a una pileta. La valija que se usa para transportar ropa, también puede usarse para pararse sobre ella y cambiar un foquito de luz. Este es el rasgo más notable de la inteligencia humana, la capacidad de crear analogías y hacer diversos usos de las cosas, de desarrollar el sentido común y tener infinidad de maneras posibles de encarar y resolver problemas. La inteligencia humana permite entender una fábula y el doble sentido, yendo más allá del sentido literal de las palabras. Y aunque no necesariamente lleguemos a ser un gran maestro de Go, podemos aprender a jugarlo sin necesitar millones de ejemplos. Lee Sedol perdió contra AlphaGo, pero lo notable es que pudiera siquiera hacerle partida, habiendo jugado una ínfima cantidad de partidas comparado con la computadora. Esto demuestra la superioridad humana y pone el foco en lo que todavía las máquinas no han logrado: la capacidad de inteligencia general, de abstraer y transferir conocimiento. Una máquina que interpreta imágenes no puede reconocer el habla, mientras que cualquier chico de un par de años ya puede hacerlo. Para un jugador amateur de ajedrez sería relativamente sencillo aprender un juego alternativo en el que se cambian las reglas (por ejemplo, jugando a comer los peones del adversario). Sin embargo, los algoritmos de computadora, por más que venzan al mejor de los ajedrecistas, necesitan infinidad de nuevos ejemplos y entrenamiento para jugar de acuerdo a las nuevas reglas. Los avances de la Inteligencia Artificial en estos últimos años han sido realmente sorprendentes, pero la inteligencia humana es todavía muy superior a la de una máquina; no necesitamos entrenarnos con millones de ejemplos para cada tarea que resolvemos, porque somos el resultado de millones de años de evolución.

1 Imagen cortesía de Gregory Loan.

2 Un pensamiento no puede interactuar con la materia a no ser que creamos que, contando con dotes excepcionales, podamos lograr mover objetos a distancia o trasmitir pensamientos como un maestro Jedi. Estas capacidades paranormales, particularmente la telequinesis y la telepatía, no existen. El aclamado mago James Randi se dedicó a desenmascarar a aquellos que aseveraban tener tales poderes y ofreció un premio de 1 millón de dólares a quien pudiera demostrar habilidades paranormales. No es que Randi fuera multimillonario, sino que estaba seguro de que nunca nadie podría reclamar el premio. Entre otros, Randi humilló públicamente al entonces famoso “mentalista” israelí Uri Geller, que aducía poder doblar objetos con su mente o leer el pensamiento. Randi también mostró cómo un evangelista que declaraba poder adivinar y curar los males que aquejaban a su audiencia, en realidad recibía señales de radio de su mujer que le pasaba información en base a plegarias que la audiencia había provisto antes de la función. Lo realmente sorprendente es que estos charlatanes, por más expuestos que queden, puedan aún seguir haciendo fortunas a través de donaciones o la venta de sus libros.

En la Argentina hubo infinidad de embaucadores que se atribuyeron poderes psíquicos. En su cruzada para desenmascarar estos engaños, el conductor Raúl Portal mostró como dos “telépatas” venezolanos se pasaban información a través de un sencillo código que usufructuaba su habitual floreo verbal. Por ejemplo, para transmitirle a su cómplice lo que una persona había dibujado, uno de ellos decía muy rápidamente: Concéntrate, Ahora, Rápido, Ahora… Su cómplice, con los ojos vendados, no hacía más que unir las primeras letras de cada palabra para “milagrosamente” adivinar que el dibujo era una CARA.

3 Para más detalles sobre Phineas Gage, ver, por ejemplo: Malcolm Macmillan. “Phineas Gage – Unravelling the myth”. The Psychologist; 21: 828-831; 2008.

4 El problema de Tan no era de comprensión del lenguaje, sino de articulación de un discurso fluido (tanto oral como escrito), a pesar de no presentar dificultades en el movimiento de la lengua, labios, boca, cuerdas vocales, etcétera. De hecho, podía silbar o tararear una melodía sin problemas. Poco después, en 1879, el neurólogo alemán Carl Wernicke describiría el fenómeno opuesto: pacientes con lesiones en el lóbulo temporal izquierdo que podían hablar (aunque sólo frases incoherentes) pero sin comprender el lenguaje tanto oral como escrito. El lenguaje es entonces procesado por dos áreas conectadas, lo que se conoce como el área de Wernicke, encargada de la comprensión del lenguaje, y el área de Broca, encargada de su ejecución. Lesiones en el área de Wernicke y de Broca dan lugar a dos patologías distintas llamadas “afasia sensorial” y “afasia motora”. Los pacientes con afasia motora (de Broca) apenas pueden pronunciar palabras aisladas, y aquellos con afasia sensorial (de Wernicke) pueden hablar sin problemas, pero lo que dicen no tiene sentido. En algunos casos la lesión abarca ambas áreas produciendo lo que se conoce como afasia mixta.

5 H. M. fue estudiado durante 30 años por la psicóloga canadiense Brenda Milner. Para más detalles, ver el primer reporte científico que Milner escribiera junto a Scoville sobre H. M.: William Scoville and Brenda Milner. “Loss of recent memory after bilateral hippocampal lesion”. Journal of Neurology, Neurosurgery and Psychiatry 20: 11-21; 1957.

6 Gilbert Ryle; The concept of mind; Routledge; 1949.

7 Junto a James Watson y Maurice Wilkins, Francis Crick recibiría el Premio Nobel de Medicina y Fisiología en 1962 por descubrir la estructura de doble hélice del ADN. En las últimas décadas de su vida se dedicó a estudiar el cerebro y el problema de la conciencia, mayormente junto a Christof Koch (quien fuera mi mentor en el Instituto Tecnológico de California).

8 Para más detalles del algoritmo, ver: Alex Krizhevsky, Ilya Sutskever and Geoffrey Hinton. “Imagenet classification with deep convolutional neural networks”. Advances in neural information processing systems 25, 1097-1105; 2012.

9 Para una recopilación de las performances de distintos algoritmos en los últimos años y cómo estas comparan con la performance humana ver: Olga Russakovsky et al. “ImageNet Large Scale Visual Recognition Challenge”. International Journal of Computer Vision 115:211-252; 2015.

10 Para más detalles, ver: Yann LeCun, Yoshua Bengio and Geoffrey Hinton. “Deep Learning”. Nature 521: 436-444; 2015.

11 Ver LeCun et al. “Deep learning”. Nature 521: 436-444; 2015.

12 Christof Koch. “How the computer beat the Go master”. Scientific American, March 19; 2016.

13 David Silver et al. “Mastering the game of Go with deep neural networks and tree search”. Nature 529, 484-489; 2016.